Google AI Studioで機密情報を守る方法|無料版リスクと企業向け対策

「Google AI Studioを業務で使いたいけれど、セキュリティは本当に大丈夫なのか?」このような不安を抱えているビジネスパーソンは少なくありません。無料で高性能なAIを活用できるGoogle AI Studioですが、企業利用においては見過ごせないセキュリティリスクが複数存在します。

実際、Google AI Studioの無料枠では入力データがGoogleのAI改善に使用される可能性があり、機密情報の流出リスクが伴います。プロンプトインジェクション攻撃やAPIキー管理の不備により、重要なビジネス情報が第三者に漏洩する危険性もあるのです。

本記事では、Google AI Studioのセキュリティリスクを徹底的に分析し、企業が安全にAIを活用するための具体的な対策方法をご紹介します。無料版と有料版のセキュリティ差異、Vertex AIへの移行判断基準、段階的な導入ロードマップ、さらには他の生成AIサービスとの比較まで、ビジネス現場で即実践できる情報を網羅しました。

※本記事では、Google Cloud課金設定済みのAPIキーを使用している状態を『有料版』、課金設定をしていない状態を『無料版』と呼びます。Google AI StudioのWebインターフェース上で直接入力したデータは、課金の有無に関わらず学習に使用される可能性があります。

- Google AI StudioとVertex AIのセキュリティ差異

- 無料版に潜む主要なセキュリティリスク

- 安全に利用するための具体的な3つの対策

- Google AI StudioとVertex AIの選び方と、企業導入時の運用指針

- ChatGPT・Claude AIとの主要セキュリティ機能の比較

Google AI Studioは企業で安全に使えるのか

Google AI Studioは無料で高性能な生成AIを利用できる魅力的なツールですが、企業利用においては慎重な判断が求められます。

無料版では入力データがGoogleのAI学習に使用される可能性があり、機密情報の流出リスクが存在するためです。課金アカウントを有効化することでデータ保護を強化できますが、プロンプトインジェクション攻撃やAPIキー管理などのリスクは依然として残ります。

導入を検討する際は、利用目的と求められるセキュリティレベルを明確にし、適切な対策を講じることが不可欠でしょう。

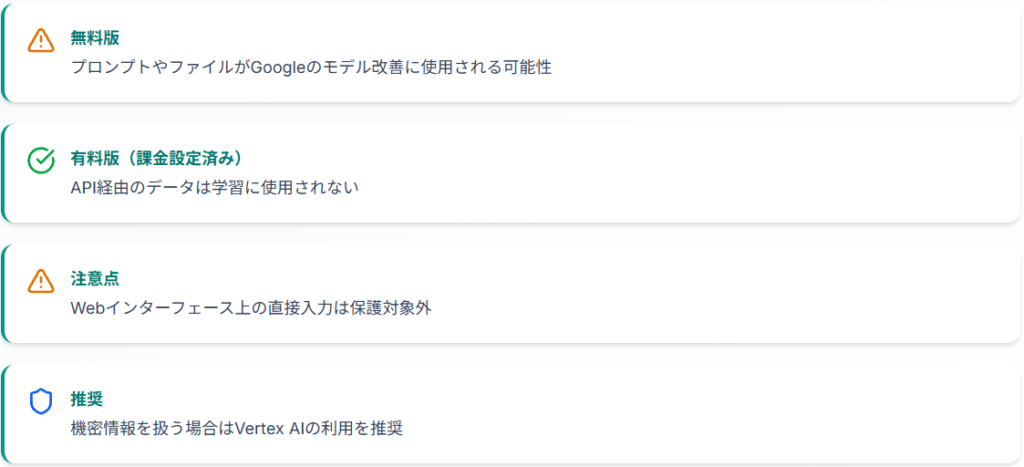

無料版と有料版のセキュリティ差異

無料版のGoogle AI Studioでは、入力されたプロンプトやファイルがGoogleのモデル改善に使用される可能性があり、利用規約にも明記されています。

一方、Google Cloud課金設定済みのAPIキーを使用する場合、入出力データがサービス改善やモデルの再トレーニングに使用されることはありません。ただし、Google AI StudioのWebインターフェース上で直接入力したデータは対象外となるため、機密情報を扱う場合はVertex AIの利用を推奨します。実験的なモデルの利用時は、課金設定の有無に関わらず、データの取り扱いについて利用規約を確認することが重要です。

APIキーの課金設定は、Google Cloud Consoleで課金アカウントを作成し、APIキーに紐付けることで実現できます。ただし、この設定はAPI経由でのデータ送信にのみ適用され、Google AI StudioのWebインターフェース上での入力には適用されません。

第三者評価から見る安全性レベル

企業がGoogle AI Studioを導入する際は、自社のセキュリティ要件と照らし合わせた評価が必要です。

プロンプトインジェクション攻撃などの技術的な脆弱性は生成AI全般に存在するため、第三者評価の結果も参考にしつつ、自社基準での慎重な判断が求められます。

企業利用における3段階の安全性評価

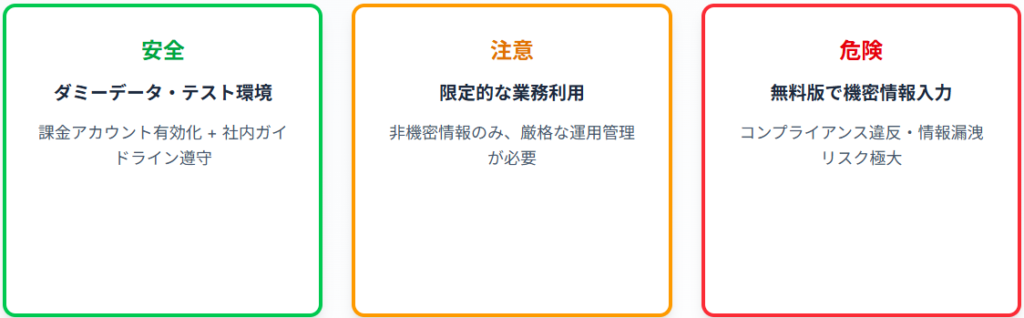

企業がGoogle AI Studioを評価する際は、利用シーンに応じたリスク判断が有効です。

ダミーデータやテスト環境での利用は比較的安全ですが、課金アカウントを有効化し社内ガイドラインに従った運用が推奨されます。無料版で個人情報や機密情報を入力すると、コンプライアンス違反や情報漏洩のリスクが極めて高くなります。

自社のデータの機密性レベルを明確にし、適切なリスク段階で運用判断を行いましょう。

ReAlice株式会社 AIコンサルタント

ReAlice株式会社 AIコンサルタントGoogle AI Studioは利便性が高い一方で無料利用時のデータ取扱に注意が必要です。

課金設定を行えば学習利用の回避は可能ですが、Web UI上の操作には適用されない点は見落とされがちです。

無料版に潜む5つのセキュリティリスク

入力データが学習に使われる仕組み

Google AI Studioの無料版では、ユーザーが入力したすべてのデータが自動的に学習対象として扱われます。これはGoogleのAIモデルの精度向上に役立つ一方、企業の機密情報も例外なく学習データとして活用される可能性があるのです。

利用規約には「本無料サービスには、プライベート情報、機密情報、または個人情報を送信しないでください」と明記されており、無料版の使用には大きな制約があります。

実際、複数の企業でGoogle AI Studioの無料版に機密情報を誤って入力してしまい、後から削除できないことに気づくケースが報告されています。無料版では一度送信したデータの削除や学習からの除外はできないため、企業は入力前の十分な確認が必要です。

人間レビュアーによる閲覧の可能性

Google公式フォーラムでは、無料環境でのデータ利用について言及されており、入力されたデータは人間レビュアーによって閲覧される可能性があることが示されています。これは、AIモデルの品質管理やバイアス検証のために実施されるプロセスです。

企業の機密情報が第三者の目に触れる可能性があることは、セキュリティ上の重大な懸念事項となるでしょう。金融機関や医療機関など、業界固有の規制が厳しい業種では、このリスクを看過できません。

Googleの機械学習技術への転用

無料版で収集されたデータは、Googleの機械学習技術の改善に広く活用されます。

言語モデルの精度向上だけでなく、新しい機能の開発や既存サービスの改善も含まれます。企業が入力した業界特有の専門用語や業務プロセスに関する情報が、Googleの技術開発に貢献することになるのです。このプロセスは透明性に欠け、企業側がデータの具体的な使用方法や範囲を把握することは困難といえます。

機密情報流出による企業への影響

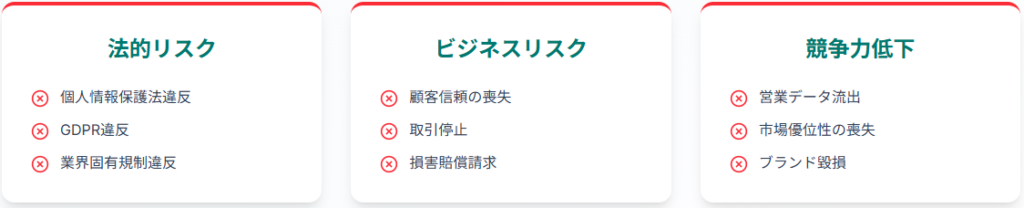

顧客情報や営業データの外部流出

顧客の個人情報や営業データをGoogle AI Studioの無料版に入力すると、それらの情報がGoogleに提供されることになります。個人情報保護法では、第三者への個人データの提供には本人の同意が必要とされていますが、AI利用時のデータ提供について顧客から明示的な同意を得ている企業は少ないのが現状です。

情報漏洩が発覚した場合、顧客からの信頼を失うだけでなく、取引停止や損害賠償請求のリスクも生じます。営業データについても、競合分析に利用される可能性があり、市場での競争優位性を損なう恐れがあるでしょう。

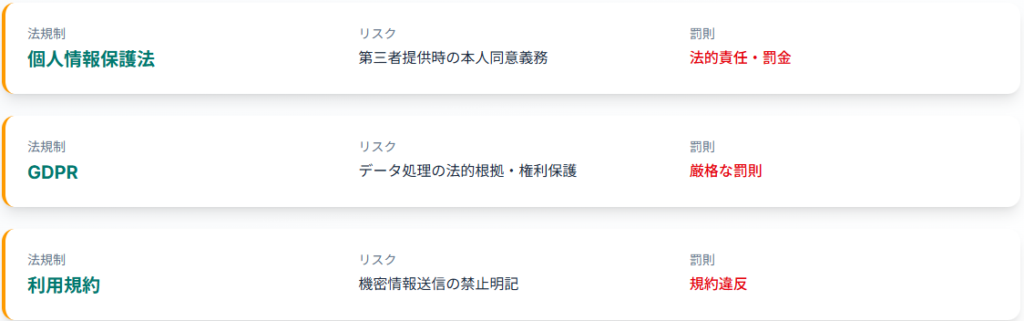

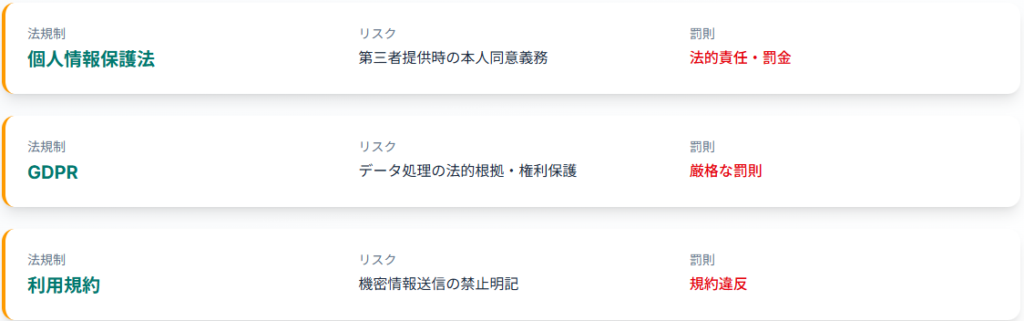

コンプライアンス違反のリスク

Google AI Studioで個人情報を処理した場合、データの越境移転や第三者提供に該当する可能性があり、適切な同意取得や安全管理措置を怠れば法的責任を問われます。GDPRが適用されるヨーロッパの顧客データを扱う場合、さらに厳格な規制に対応する必要があります。

金融商品取引法や個人情報保護法の特別規定など、業界固有の規制にも抵触するリスクがあり、コンプライアンス違反は罰金だけでなく、事業継続に深刻な影響を与えかねません。内部監査や外部監査でAI利用状況を適切に説明できない問題も生じるでしょう。

プロンプトインジェクション攻撃とは

プロンプトインジェクション攻撃は、悪意のある指示を含むプロンプトを入力することで、AIに想定外の動作をさせる手法です。この攻撃により、AIが機密情報を出力したり、不正な処理を実行したりする可能性があります。

外部からコピーした文章には悪意ある命令が隠されている場合があり、プロンプト入力前に内容を確認することが重要です。コーネル・テックの研究チームは、生成AIを使ったメールシステムを対象に実験を行い、悪意あるプロンプトを含むメールを送るだけで、AIが機密情報を抽出し、他のユーザーに自動転送する動作を確認しました。

間接プロンプトインジェクションの脅威

間接プロンプトインジェクションは、テキストや画像に悪意あるプロンプトを埋め込むことにより、AIを騙して機密情報を抽出し広げる攻撃手法です。電子メールアシスタントを通じて感染が広がり、ユーザーの操作なしに悪意のあるコードを実行するゼロクリック攻撃を可能にします。

攻撃者は、生成AIモデルが入力されたプロンプトを出力するように指示し、プロンプトを複製してワームのように他のエージェントに伝搬させるのです。こうした新たなリスクに対して、現場レベルでの対応は急務といえるでしょう。

自己複製型AIワーム「Morris II」の事例

Morris IIは、生成AIを活用するアプリケーションをターゲットとしたゼロクリックワームで、コーネル工科大学やイスラエル工科大学などの研究者によって2024年に開発されました。このワームは「敵対的な自己複製プロンプト」を使用し、ChatGPT、Gemini、およびオープンソースのAIモデルLLaVAなどへの攻撃に成功しています。

Morris IIは、生成AIモデルが応答として別のプロンプトを出力するようトリガーするプロンプトであり、自己複製、ペイロードの実行、新しいホストへの伝搬という3つの特徴を持ちます。IBMのセキュリティ専門家は「被害者は何もクリックする必要がなく、ワームが放たれると『受動的に』新しいターゲットに移動する」と警告しています。

生成AIのセキュリティが突破されたことは、AIモデルのセキュリティを向上させるために対応を急ぐ必要性を示しているのです。

外部データ参照時のセキュリティリスク

Google AI StudioをAPIで外部システムと連携する場合、データソース自体が改ざんされるリスクがあります。悪意ある第三者がデータソースに不正な情報を埋め込むことで、AIの出力を操作し、誤った判断や機密情報の漏洩を引き起こす可能性があるのです。

企業がGoogle AI Studioを業務システムと連携させる場合、APIを通じて社内データベースにアクセスする設計が考えられますが、この接続経路が攻撃の標的になり得ます。ネットワークレベルでのアクセス制限やVPN、ファイアウォールの活用により、アクセス経路を制御することが重要でしょう。

法的リスクと規約上の注意点

Gemini API追加利用規約には、無料サービスと有料サービスでのデータ取扱いの違いが明記されています。無料版の利用規約には「本無料サービスには、プライベート情報、機密情報、または個人情報を送信しないでください」と記述されており、企業が機密情報を入力した場合は規約違反となるのです。

個人情報保護法では、個人データを第三者に提供する際には本人の同意が必要とされていますが、AI利用時のデータ提供について顧客から明示的な同意を得ることは実務上困難といえます。GDPRが適用される場合、データ処理の法的根拠やデータ主体の権利保護について、さらに厳格な対応が求められます。

企業におけるAI活用では、Google Workspaceの初期設定だけではセキュリティリスクをカバーしきれないケースが多く、追加の対策が必要です。法務部門と連携し、利用規約とプライバシーポリシーを十分に理解した上で、コンプライアンスに準拠した運用を行う必要があるでしょう。

入力データが学習、レビュー対象となる仕様は情報管理上の重大リスクであり、特に規制業種では許容できません。加えてプロンプトインジェクションや自己複製型ワームといった新興の攻撃手法も無視できない脅威です。

データを学習させないための3つの対策方法

前述のリスクを踏まえると、企業がGoogle AI Studioを安全に利用するには、データ保護対策が不可欠です。

ここでは、データが学習に使われることを防ぐ3つの具体的な方法をご紹介します。

方法1|Google Cloud APIキーの課金設定

Google Cloud課金設定済みのAPIキーを使用することで、API経由で送信するデータの学習利用を防ぐことができます。この設定により、プログラムから送信するプロンプトやファイルがGoogleの学習データとして使用されることがなくなります。ただし、Google AI StudioのWebインターフェース上で直接入力したデータは保護されないため、機密情報の入力は避けてください。

ExperimentalやPreviewと表記された実験的なモデルは挙動が不安定な場合があるため、業務利用では安定版のGemini 1.5 ProやFlashモデルを選択しましょう。

課金設定済みのAPIキーを利用することは、プログラム経由でのAI利用においてセキュリティを強化できる現実的な選択肢といえます。ただし、Google AI StudioのWeb画面での直接入力には適用されないため、機密情報を扱う本番業務ではVertex AIへの移行を推奨します。

有料版への切り替え手順(4ステップ)

Google Cloud Consoleにアクセスし、新規課金アカウントを作成します。

Google AI Studioで使用しているプロジェクトに課金アカウントを紐付けてください。

安全設定(Safety settings)を調整し、セキュリティレベルを企業の要件に合わせます。

ExperimentalやPreviewモデルを避け、安定版のGemini 1.5 ProやFlashモデルを使用する設定を行います。

課金アカウント有効化後のデータ保護の仕組み

Google Cloud課金設定済みのAPIキーを使用してプログラムからデータを送信する場合、入出力データがプロダクトの改善に使用されることはないと規約で定められています。これはAPI経由での利用に限定され、Google AI StudioのWebインターフェース上での直接入力には適用されません。

これにより、企業が入力したプロンプトやデータ、AIモデルが生成したレスポンスについて、Googleがサービス改善に利用したり、モデルの再トレーニングに使用したりすることはありません。

プロンプトインジェクション攻撃やAPIキー管理のリスクは、課金の有無に関係なく存在するため、包括的なセキュリティ対策が依然として必要でしょう。課金設定を行うと、利用量に応じた従量課金制となり、API経由での利用においてはコストを管理しながらセキュリティを確保できます。

方法2|Vertex AI Studioへの移行

Vertex AIは、Google Cloudが提供するフルマネージドの機械学習プラットフォームで、企業における利用を想定した高度なセキュリティ機能を備えています。

ユーザーが入力したプロンプトやデータ、AIモデルが生成したレスポンスについては、Googleがサービス改善に利用したり、モデルの再トレーニングに使用することはなく、データの保護が規約で明確に定義されているのです。IAMによる詳細なアクセス制御、VPC Service Controlsによる API保護、Cloud Audit Logsによる監査ログ機能など、企業が求める統制機能が充実しています。

本格的な開発や本番利用を考える企業には、Vertex AIへの移行が推奨されます。

Google AI StudioとVertex AIの違い

Google AI Studioは個人開発者や研究者、学生を対象としたプロトタイピングツールであり、無料枠での利用が可能です。

一方、Vertex AIは企業、官公庁、研究者など幅広い利用者を対象とした本番環境向けのプラットフォームで、従量課金制となります。セキュリティ面では、Google AI StudioがAPIキーによる認証のみなのに対し、Vertex AIはIAM、組織ポリシー、VPC SC、サービスアカウントなど高度なセキュリティ機能を提供しています。

データ保護についても、Google AI Studioの無料枠ではデータがサービス改善に使われる可能性がありますが、Vertex AIではデータは分離・保護され、モデル学習には利用されません。

移行判断のチェックリスト

- 個人情報や機密情報を扱うかどうか

- 本番環境での利用を想定しているか

- 組織レベルでの統制やアクセス制御が必要か

- 他のGoogle Cloudプロダクト(BigQuery、Cloud Run、GKEなど)との連携を考えているか

- 技術サポートが必要かどうか

Google AI Studioでプロトタイピングを行い、本格的な開発時にVertex AIに移行するという段階的なアプローチも有効といえます。

方法3|社内ガイドラインと教育の徹底

Google AI Studioを安全に利用するには、技術的な対策だけでなく、組織全体での運用ルール策定が不可欠です。機密情報の入力禁止、利用可能なモデルの指定、APIキー管理方法など、明確な社内ガイドラインを策定しましょう。

従業員が誤って機密情報をGoogle AI Studioに入力しないよう、定期的な研修を実施することが重要です。特に、無料版と課金版の違い、実験的なモデルのリスク、プロンプトインジェクション攻撃への注意など、具体的な事例を交えた教育が効果的といえます。

月次でアクセスログを確認し、四半期ごとに包括的なセキュリティレビューを行うことで、継続的な安全性を確保できるでしょう。

ログ管理とヒストリー削除の手順

ログ管理では、Google AI Studioの利用履歴を定期的にチェックし、不適切な利用がないか確認することが重要です。大容量ファイルのアップロードや機密性の高い質問は重点的に監視する必要があるでしょう。

ヒストリー削除については、Google AI Studioの利用履歴を定期的に確認し、不要なプロンプト履歴は削除することが推奨されます。ただし、削除操作を行った場合でも、システムのバックアップ等により即座に完全削除されるとは限りません。

月次でアクセスログを確認し、四半期ごとに包括的なセキュリティレビューを行うことで、継続的な安全性を確保できるでしょう。

代替アプローチとしての活用方法

Google AI Studioを完全に置き換えず、用途に応じて使い分けるハイブリッドアプローチも有効です。非機密情報を扱う社内教育やアイデア検証にはGoogle AI Studioを活用し、個人情報や機密情報を扱う本番業務にはVertex AIを使用するという棲み分けが考えられます。

この方法により、コストを抑えながらセキュリティリスクを管理できるのです。従業員が誤って機密情報をGoogle AI Studioに入力しないよう、社内ガイドラインで明確に使い分けルールを定め、定期的な研修を実施することが不可欠でしょう。

API課金設定やVertex AIへの段階的な移行は、技術的にも運用的にも現実的な対応策といえます。一方で、社内教育の徹底と利用ガイドラインの策定がなければ人的ミスによる情報漏洩は防ぎきれません。

Google AI StudioとVertex AIの選び方

利用目的とセキュリティ要件に応じて、適切なプラットフォームを選択することが、AI活用成功の鍵となります。

用途別の選択基準(比較表付き)

Google AI StudioとVertex AIの選択は、利用目的とセキュリティ要件によって決まります。以下の比較表を参考に、自社の状況に合ったツールを選択してください。

実験段階ならGoogle AI Studio

プロトタイピングや概念実証(PoC)の段階では、Google AI Studioが適しています。無料枠を活用して迅速にアイデアを検証でき、開発コストを抑えられるメリットがあるためです。この段階でもダミーデータや公開情報のみを使用し、個人情報や機密情報は一切入力しないよう徹底する必要があります。

実験段階でAPI経由での利用を行う場合は、課金設定を行ってデータ保護を強化し、ExperimentalやPreviewモデルを避けることが推奨されます。ただし、機密情報を扱う場合は、最初からVertex AIの利用を検討してください。

本番運用や全社展開ならVertex AI

本番環境での利用や全社展開を考える場合、Vertex AIが明確な選択肢となります。Vertex AIはGoogle Cloudプロダクトであるため、BigQueryなどの他のサービスとの連携も容易で、Compute Engine、Cloud Run、GKEなどのコンピューティングプラットフォームとのセキュアな統合が可能です。

管理者が利用状況を可視化し、セキュアでない振る舞いが観測されたときにサービスアカウントを停止したり、アクセス権限を剥奪したりすることができます。Cloud Audit Logsによる監査ログ機能により、使用状況や設定の変更履歴を記録でき、コンプライアンス対応も容易になるでしょう。

コストとセキュリティのトレードオフ

Google AI Studioの無料版は初期コストがかからない一方、セキュリティリスクとコンプライアンス違反の潜在的コストは極めて高くなります。情報漏洩が発生した場合、損害賠償や顧客離れ、取引停止など、事業継続に深刻な影響を与える可能性があるのです。Vertex AIは従量課金制でコストが発生しますが、データ保護が保証され、高度なセキュリティ機能により情報漏洩リスクを大幅に軽減できます。

Vertex AIは従量課金制ですが、利用量に応じた柔軟な料金体系となっており、実務レベルでも比較的低コストで運用可能です。具体的な料金は、利用するモデルやトークン数により異なるため、Google Cloudの公式価格表を参照してください。

AI活用の成否はコスト優先かセキュリティ重視かという視点だけでなく、運用フェーズに即した環境選びにかかっています。

初期検証にはGoogle AI Studioが有用ですが、情報の取り扱い方に対するリテラシーの徹底が前提です。

企業導入時の安全な運用ロードマップ

セキュリティリスクを最小化しながらAI活用を進めるには、段階的な導入アプローチが効果的です。

以下は、一般的なAI導入のベストプラクティスとセキュリティ専門家の推奨に基づいた導入手順です。

検証段階|ダミーデータでのテスト環境構築

企業がGoogle AI Studioを導入する第一段階では、ダミーデータや公開情報のみを使用したテスト環境を構築します。この段階では、AIの機能や性能を評価し、業務プロセスへの適用可能性を検証しましょう。

ダミーデータは実際のデータ構造を模倣しつつ、個人情報や機密情報を一切含まないよう設計する必要があります。検証段階でAPI経由での利用を予定している場合は、Google Cloud課金設定を行い、データ保護の基本設定を実施することが推奨されます。ただし、Google AI StudioのWeb画面での入力はデータ保護の対象外となるため、ダミーデータのみを使用してください。

部分導入|部署別アクセス権限の設定

検証段階で有効性が確認できたら、特定の部署や業務に限定した部分導入を進めます。この段階では、Google Workspace(Cloud Identity)の管理者機能を活用し、組織で管理しているGoogleアカウントに対してアクセス権限を細かく設定しましょう。

この段階では、Google Workspace(Cloud Identity)の管理者機能を活用し、組織で管理しているGoogleアカウントに対してアクセス権限を細かく設定しましょう。より高度なアクセス制御が必要な場合は、Vertex AIへの移行を検討してください。

Vertex AIでは、IAMによる詳細なアクセス制御が可能で、Googleアカウント単位や組織のGoogleグループ単位でアクセス制御を行うことができます。部署別の利用状況を月次で確認し、不適切な利用がないか監視することが重要です。

全社展開|セキュリティポリシー策定のポイント

全社展開の段階では、包括的なセキュリティポリシーの策定が不可欠です。ポリシーには、AI利用における禁止事項、承認フロー、違反時の処分を明確に記載する必要があります。

個人情報や機密情報の入力禁止、利用可能な部署・業務範囲の限定、AI利用前の上司承認や情報システム部門への事前相談の義務化など、具体的なルールを設定してください。定期的なセキュリティ監査とインシデント対応計画の策定も必要でしょう。

入力禁止情報の明確化

- 個人情報(氏名、住所、電話番号、メールアドレスなど)

- 顧客情報

- 営業機密

- 新商品の開発情報

- 財務データ

- 人事情報

- 業界固有の規制対象情報(金融機関の与信情報、医療機関のカルテ情報など)

これは一例であり、各企業の状況に応じて追加・修正が必要です。

推奨用途と禁止用途の具体例

推奨用途

- 公開情報を基にした市場調査

- 一般的なビジネス文書の校正

- アイデア発想のサポート

- プログラミングコードのレビュー(機密ロジックを除く)

禁止用途

- 顧客データを含む分析

- 機密性の高い契約書の作成

- 内部監査資料の作成

- 人事評価に関する文書作成

各企業のセキュリティポリシーに応じて判断してください。

継続的なセキュリティ管理体制

月次監査のチェックリスト

- Google AI Studioの利用履歴を確認し、大容量ファイルのアップロードや機密性の高い質問がないか監視

- APIキーの利用状況を確認し、異常なアクセスパターンや大量データの送信を検知

- 課金状況をレビューし、想定外の利用増加がないか確認

- セキュリティガイドラインの遵守状況を部署ごとに評価

- 新しいセキュリティ脅威や攻撃手法の情報を収集し、対策の見直しを検討

従業員研修プログラムの実施

従業員のAIリテラシー向上により、セキュリティインシデントの発生リスクを低減できます。研修プログラムでは、プロンプトインジェクション攻撃の手口や安全な利用方法を具体的に教育することが重要です。新入社員向けの基礎研修、既存社員向けの定期研修、管理職向けのリスクマネジメント研修など、対象者に応じた内容を設計しましょう。

部署別の利用ケース研修も実施し、実際の業務に即したセキュリティ対策を身につけてもらうことで、AI活用とセキュリティの両立を実現できます。

システム面の対策だけでなく、ユーザー教育と監査体制の構築がAI活用の成否を分ける鍵になるでしょう。導入目的に応じたメリハリある設計で、安全性と生産性を両立させる運用を目指すべきです。

他の生成AIサービスとのセキュリティ比較

市場には複数の生成AIサービスが存在し、それぞれ異なるセキュリティレベルを提供しています。

ChatGPT(無料版・Enterprise)との比較

ChatGPTの無料版も、Google AI Studioと同様に入力データが学習に使用される可能性があり、企業利用には注意が必要です。

ChatGPT Enterpriseは、OpenAI社が提供する企業向けプランで、高度なセキュリティ要件に対応した環境を提供しています。なお、Microsoft Azureを利用する企業向けには、Azure OpenAI Serviceという選択肢もあります。

ChatGPT Enterpriseでは、入力データが学習に使用されることはなく、SOC 2コンプライアンスやGDPR対応などのエンタープライズレベルのセキュリティ機能を備えているのです。

料金面では、ChatGPT Enterpriseは企業向けの包括的なライセンス契約となり、Google AI Studioの有料版やVertex AIと比較して、組織の規模や利用状況によって最適な選択肢が異なります。

Claude AIとの比較

Claude AIは、Anthropic社が開発した生成AIで、セキュリティ技術とユーザーのプライバシー保護に特化しています。データの暗号化や監視システムをはじめとした複数のセキュリティ機能が搭載されており、リアルタイムでの脅威分析や異常検知を実現しているのです。

有害コンテンツ検出モデルを使って規約違反を繰り返すユーザーには利用制限をかけるなど、不正利用を防ぐ仕組みも整っています。定期的なセキュリティ監査やモニタリングシステムを導入しており、異常が発生した場合には迅速に対応できる体制が整っているのが特徴です。

小規模から中規模のシステムにはClaudeやChatGPT Enterpriseが適しており、Google Cloudの他サービスとの高度な連携を求める大企業にはVertex AIが適しているでしょう。

企業向けプランのセキュリティ評価一覧表

主要な生成AIサービスの企業向けプランのセキュリティ評価を以下の表にまとめます。

| サービス | データ学習 | 企業向けプラン | セキュリティ評価 | 主な特徴 |

|---|---|---|---|---|

| Google AI Studio(無料) | あり | なし | ⚠️ | 学習利用あり、統制機能なし |

| Google AI Studio(有料) | なし | あり | △ | 学習利用なし、統制機能は限定的 |

| Vertex AI | なし | あり | ✅ | IAM、VPC SC、監査ログなど高度なセキュリティ |

| ChatGPT(無料) | あり | なし | ⚠️ | 学習利用あり |

| ChatGPT Enterprise | なし | あり | ✅ | エンタープライズグレードのセキュリティ、SSO対応 |

| Claude AI | なし | あり | ✅ | プライバシー保護特化、異常検知 |

※ ✅:推奨 △:条件付き ⚠️:要注意

ChatGPTやClaudeなど各社の企業向けプランは入力情報の学習利用を防ぐ仕様や、監査対応、SSO対応といったセキュリティ機能が充実しています。

特にSOC2やGDPR対応などの認証取得は社内利用ルールや取引先との契約条件にも直結するポイントです。

よくある質問|Google AI Studioのセキュリティ

無料版で入力したデータは必ず学習されますか?

Google AI Studioの無料版では、入力されたすべてのデータが学習対象として扱われる可能性があります。

利用規約には「本無料サービスには、プライベート情報、機密情報、または個人情報を送信しないでください」と明記されており、無料版での機密情報の利用は規約違反となるのです。Google公式フォーラムでも、無料環境でのデータ利用について言及されており、入力されたデータは人間レビュアーによって閲覧される可能性もあります。

企業が機密情報を扱う場合は、課金設定済みのAPIキーを使用したプログラム経由での利用に限定するか、より確実なVertex AIへの移行を検討すべきでしょう。Google AI StudioのWeb画面での機密情報の入力は避けてください。

課金すればデータは完全に保護されますか?

Google Cloud課金設定済みのAPIキーを使用すれば、API経由で送信するデータの学習利用は防げますが、Google AI StudioのWeb画面での直接入力は保護されません。また、プロンプトインジェクション攻撃やAPIキー管理などのリスクも存在します。

プロンプトインジェクション攻撃やAPIキー管理のリスクは、課金の有無に関係なく存在します。ExperimentalやPreviewと表記された実験的なモデルは挙動が不安定な場合があるため、業務利用では安定版のモデルのみを選択する必要があるのです。

完全なデータ保護を求める場合は、Vertex AIへの移行が推奨されます。Vertex AIでは、データは分離・保護され、モデル学習には利用されないことが規約で明確に定義されています。

すでに入力した機密情報はどうなりますか?

無料版のGoogle AI Studioに機密情報を入力してしまった場合、そのデータはすでにGoogleのシステムに送信されており、完全に削除することは困難です。

データがAIの学習に使用されている可能性もあり、学習されたデータが将来的に他の利用者への回答生成に影響する可能性も考慮する必要があります。まず情報システム部門や法務部門に報告し、影響範囲を評価する必要があります。個人情報が含まれていた場合は、個人情報保護委員会への報告や本人への通知が必要になる可能性もあるでしょう。

再発防止のため、API経由での利用に切り替えて課金設定を行うか、Vertex AIへの移行を検討し、全社的なセキュリティ研修を実施することが重要です。特に、Google AI StudioのWeb画面では機密情報を入力しないよう、明確なルールを策定してください。

Vertex AIとGoogle AI Studioのどちらを選ぶべきですか?

プロトタイピングや学習目的であればGoogle AI Studio、本番環境や企業での業務利用であればVertex AIを選択すべきです。

個人情報や機密情報を扱う場合、組織レベルでの統制やアクセス制御が必要な場合、他のGoogle Cloudプロダクトとの連携を考えている場合は、Vertex AIが明確な選択肢となります。技術サポートが必要な場合もVertex AIを選択すべきでしょう。コスト面では、Google AI Studioに無料枠がある一方、Vertex AIは従量課金制ですが、セキュリティインシデントによる潜在的損失と比較すれば投資効果は高いといえます。

Google AI Studioでプロトタイピングを行い、本格的な開発時にVertex AIに移行するという段階的なアプローチも有効です。

プライバシーポリシーで保証されている範囲は?

Google AI Studioの無料版では、入出力データがGoogleによってサービス改善に利用されたり、モデルの再トレーニングに使用される場合があることが利用規約に明記されています。

有料版を使用する場合、入出力データがプロダクトの改善に使用されることはないとされていますが、Googleのプライバシーポリシーの適用範囲や、データの保持期間については詳細に確認する必要があるでしょう。Vertex AIの場合、Cloud Data Processing Addendumにより、ユーザーが入力したプロンプトやデータ、AIモデルが生成したレスポンスについて、Googleがサービス改善に利用したり、モデルの再トレーニングに使用することはないと明確に定義されています。

企業が生成AIを導入する際は、利用規約とプライバシーポリシーを法務部門とともに精査し、自社のコンプライアンス要件を満たすかどうかを慎重に判断することが不可欠です。