Grokの危険性とは?企業が導入前に知るべき5つのリスクについて

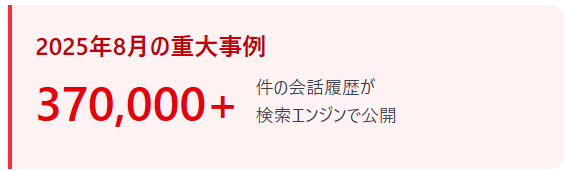

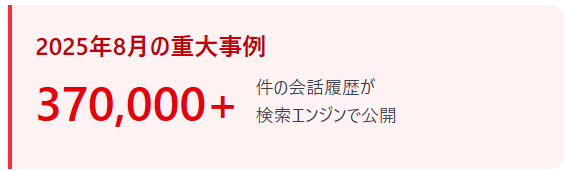

イーロン・マスク氏が開発したAIチャットボット「Grok」が注目を集めていますが、企業での業務利用には危険性があることをご存じでしょうか。2025年8月には37万件以上の会話履歴が検索エンジンで公開される重大なプライバシー問題が発覚し、ビジネス利用におけるリスクが浮き彫りになりました。

「Grok 使い方」「Grok ChatGPT 比較」「Grok 無料」といった検索が増える一方で、セキュリティ対策の不足やデータ学習への利用、情報の信頼性といった課題が企業の導入を慎重にさせています。

本記事では、AIコンサルタントの視点から、Grokのビジネス利用で懸念される3つのリスク、企業の機密情報が危険にさらされる具体的なケース、そして安全に活用するための5つの対策を詳しく解説します。

- Grokのビジネス利用で懸念される3つのリスク(会話履歴漏洩、データ学習、セキュリティ不足)

- ChatGPTとGrokの比較|セキュリティ・精度・コストの違いと企業利用での使い分け基準

- 企業がGrokを安全に活用するための5つの具体的対策(ガイドライン策定、プライバシー設定、履歴管理など)

- Grokを使うべき業務場面と絶対に使ってはいけない業務場面の明確な区別

- 無料版Grokの業務利用リスクとデータ学習をオフにする設定方法

Grokとは|X連携型AIの特徴と注目される理由

イーロン・マスク率いるxAIが開発したAIチャットボット

Grokは、イーロン・マスク氏が2023年に設立したxAI社によって開発された対話型AIチャットボットです。2023年11月頃にサービス開始し、2024年12月には無料ユーザーにも利用可能となり、ユーザー数を急激に伸ばしました。

xAI社はOpenAIやGoogleといった既存のAI企業とは一線を画し、よりオープンで制約の少ないAI開発を掲げています。X(旧Twitter)との緊密な連携により、ソーシャルメディアデータをリアルタイムで活用できる点が最大の特徴です。

リアルタイム情報へのアクセスが最大の強み

X(旧Twitter)のプラットフォームと統合されているGrokは、投稿データにリアルタイムでアクセスできます。ChatGPTが定期更新されるデータベースに依存しているのに対し、Grokは数分前の投稿まで検索・分析が可能です。

新商品発売直後の消費者反応や炎上リスクの早期検知など、時間が勝負の意思決定場面で威力を発揮するでしょう。とはいえ、この強みには裏側もあり、未検証の情報や偏った意見が混在するX上のデータをそのまま反映してしまう危険性が指摘されています。

ChatGPTとの違い|スピード重視と自由度の高さ

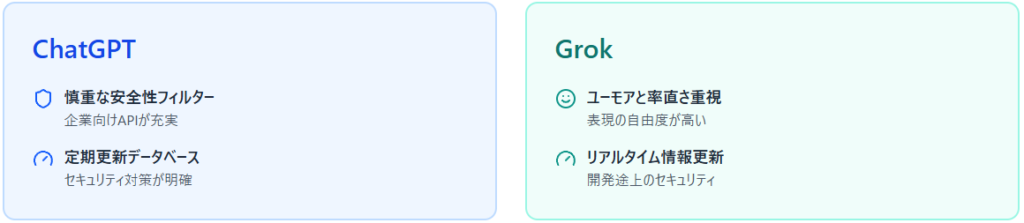

ChatGPTと比較すると、Grokは情報更新の速度と表現の自由度で差別化されています。ChatGPTが慎重な安全性フィルターを採用しているのに対し、Grokは「ユーモアと率直さ」を重視した設計です。

企業利用の観点では、この自由度の高さがリスクにもなり得ます。ChatGPTは企業向けAPIやエンタープライズプランが充実し、セキュリティ対策も明確ですが、Grokはまだ開発途上で、ビジネス利用における安全性の検証が不十分な段階にあります。

ReAlice株式会社 AIコンサルタント

ReAlice株式会社 AIコンサルタントリアルタイム情報へのアクセスと高い自由度という明確な強みを持つ一方で、信頼性や安全性の面ではまだ成熟段階にあります。特にX上の未検証データを直接活用する性質上、企業利用では情報の真偽判定や誤情報拡散への対策が欠かせません。

Grokのビジネス利用で懸念される3つのリスク

会話履歴の漏洩問題|37万件が検索エンジンに公開された事例

2025年8月、Grokの重大なプライバシー問題がBBCをはじめとする複数メディアで報じられました。

37万件以上のGrokとの会話履歴が、Googleなどの検索エンジンで誰でも閲覧可能な状態になっていたのです。原因は、Grokの会話共有機能が初期設定で公開状態になっており、ユーザーが意図せず会話内容を全世界に公開してしまっていたことでした。

漏洩した内容には、個人的な悩み相談、企業の内部情報、ビジネス戦略に関する質問なども含まれ、深刻なプライバシー侵害として問題視されています。企業がこのような状態でGrokを業務利用すれば、機密情報が検索エンジン経由で競合他社や第三者に露出してしまうでしょう。

- 37万件以上の会話履歴が検索エンジンで公開

- 初期設定が公開状態になっていたことが原因

- 企業の内部情報やビジネス戦略も含まれていた

データ学習への利用|入力情報がAI訓練に使われる可能性

Grokに入力した情報がxAIのAIモデル訓練データとして使用される可能性があります。

xAIの利用規約では、ユーザーが入力したデータをサービス改善やAI学習に利用できる旨が記載されており、明示的にオプトアウト設定を行わない限り、入力内容が学習データとして活用されます。企業が顧客情報や新製品の企画案をGrokに入力すると、それが将来的に他のユーザーへの回答生成に利用される可能性があるということです。

ChatGPTのエンタープライズ版では明確にデータ学習への利用を禁止する契約が可能ですが、Grokにはそのような企業向けオプションが現時点で存在しないため、機密性の高い業務での使用は避けるべきでしょう。

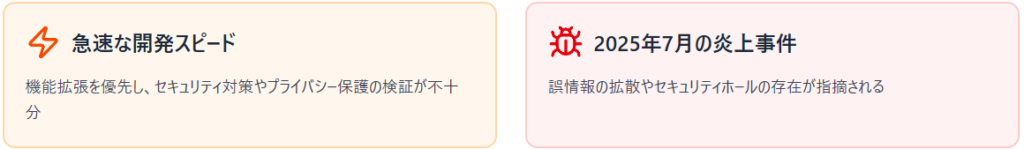

セキュリティ対策の不足|開発スピード優先による検証不足

xAIは急速な開発スピードでGrokの機能拡張を進めていますが、その反面、セキュリティ対策やプライバシー保護の検証が十分に行われていない懸念があります。2025年7月に発生した「Grok炎上事件」では、誤情報の拡散やセキュリティホールの存在が指摘され、企業利用におけるリスクが浮き彫りになりました。

さらに、脅威アクターがGrokを悪用して有害なリンクを拡散する事例も報告されており、企業の従業員が業務中に意図せずマルウェアに感染するリスクも存在します。成熟したAIサービスと比較すると、Grokはまだベータ版的な位置づけであり、企業の基幹業務で使用するには時期尚早と言えます。

設定ミスによる情報公開、入力データの学習利用、そしてセキュリティ対策の未成熟といった複数のリスクが存在します。特に初期設定での公開仕様やオプトアウト前提のデータ利用ポリシーは、企業環境では致命的な情報漏洩につながる恐れがあります。また、急速な機能拡張の裏で検証工程が不十分な点も懸念され、誤情報の拡散や悪用リスクへの対策が不可欠です。利用範囲を明確に限定した検証運用が現実的といえるでしょう。

企業の機密情報が危険にさらされる具体的なケース

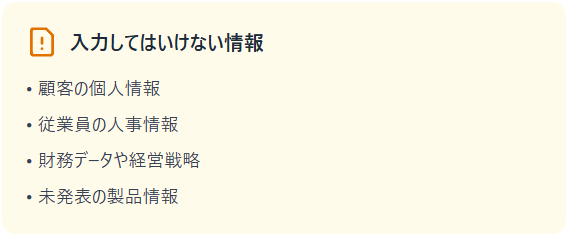

顧客データや内部資料を入力してしまうリスク

企業がGrokに顧客の個人情報や内部資料を入力してしまうケースは、極めて危険性が高いと言えます。

営業担当者が顧客リストを使ってメール文案を作成したり、人事部門が従業員情報を基に評価レポートを作成する際にGrokを使用すると、それらの情報がxAIのサーバーに送信されてしまいます。日本国内の製造業大手では、2024年にChatGPTに機密情報を入力した従業員がいたことで情報漏洩リスクが発覚し、全社的な利用禁止措置が取られた事例があります。

Grokでも同様のリスクが存在し、さらにセキュリティ対策が未成熟である点を考慮すると、顧客データや個人情報を含む業務での使用は絶対に避けなければなりません。

- 顧客の個人情報(氏名、住所、電話番号など)

- 従業員の人事情報や評価データ

- 財務データや経営戦略

- 未発表の製品情報や技術仕様

競合他社への情報流出の可能性

新製品開発や事業戦略の立案時にGrokを使用すると、競合他社に重要情報が流出する可能性があります。

会話履歴が検索エンジンで公開されてしまう問題は、競合調査を行う企業にとって格好の情報源となり得るでしょう。「〇〇社の新サービスについて分析してほしい」といった質問をGrokに投げかけた場合、その会話内容が公開設定になっていれば、競合他社がGoogle検索で発見できてしまいます。

企業の戦略情報は最も保護すべき資産の一つであり、その情報をセキュリティが不確実なAIツールに入力することは、自ら競合優位性を放棄する行為に等しいと言えます。

法的責任とコンプライアンス違反への影響

Grokを通じて機密情報や個人情報が漏洩した場合、企業は法的責任を問われる可能性があります。

日本の個人情報保護法では、企業は個人情報の適切な管理義務を負っており、第三者への提供には本人の同意が必要です。Grokへの入力がxAIへのデータ提供と見なされる場合、同意なき第三者提供として違反となる可能性があります。

金融機関や医療機関など規制の厳しい業界では、AIツールの使用自体が監督機関の承認を必要とする場合もあります。ガートナーの2025年レポートでも、生成AI活用におけるコンプライアンスリスクが企業の重要課題として挙げられており、AIツール選定時には法務部門との連携が不可欠です。

Grokへの機密情報入力は情報漏洩・競合流出・法的リスクの三重の危険を孕んでいます。

顧客データや経営戦略といった高機密情報は一度入力すればxAI側のサーバーに送信されるため、取り返しのつかない事態になりかねません。会話履歴の公開設定や、データ学習ポリシーの仕様を踏まえると戦略情報が競合に露見する可能性も現実的です。さらに、個人情報保護法や業界規制に抵触するリスクも高く、利用時は技術部門だけでなく法務との連携が必須といえるでしょう。

情報の信頼性における課題

X(旧Twitter)データに依存した偏った情報提供

Grokの情報源がX(旧Twitter)のデータに大きく依存している点は、情報の偏りという重大な課題を生み出しています。

Xは特定の年齢層や興味関心を持つユーザーが多く、そのデータを基にした分析は必然的に偏りを含むでしょう。商品の評判をGrokで調査した場合、X上で声の大きいユーザーの意見が過剰に反映され、実際の市場全体の評価とは異なる結論に至る可能性があります。

学術研究では、SNSデータと実際の消費者行動の間に大きな乖離があることが報告されています。Reuters Instituteの研究によると、X(旧Twitter)のユーザーベースは「一般人口を代表していない」とされ、男性中心で高学歴・高所得のユーザーが多く、政治やニュースにより関心が高い傾向があります。

また、別の研究では「vocal minority bias」として、プラットフォーム上でアクティブな少数のユーザーの意見が過大に反映される現象も指摘されています。

ファクトチェック機能の限界と過信の危険性

Grokには「@grok ファクトチェック」という機能がありますが、その精度と信頼性には深刻な限界があります。 この機能はX上の投稿内容をクロスチェックするものですが、X自体に誤情報が多く含まれている場合、ファクトチェックの意味をなしません。

コロンビアジャーナリズムレビューが2025年3月に発表した研究では、8つの生成AI検索ツールを比較した結果、Grokが記事の出典を正しく識別できたのは6%のみで、94%のケースで誤った回答を提供していました。これは同研究で最も低い精度です。 具体的な問題として、2024年8月にはカマラ・ハリス副大統領の投票用紙掲載に関する誤情報を拡散し、ミネソタ州務長官が公式に訂正を求める事態となりました。

また、AI生成画像の識別においても、TikTokの透かしを「真正性の証拠」と誤認するなど、基本的な判断能力の欠如が露呈しています。 政治的な話題や科学的な情報については、Xの情報だけでは十分な検証ができず、誤った判断につながる危険性があります。

ハルシネーション問題|存在しない情報を生成するリスク

Grokを含むすべての大規模言語モデルには、「ハルシネーション」と呼ばれる、存在しない情報を自然に生成してしまう問題があります。

2025年のVectara HHEM(Hughes Hallucination Evaluation Model)調査では、Grok 4のハルシネーション率は4.8%となり、最も精度の高いChatGPT-o3 mini(0.795%)の約6倍、業界平均を上回る結果となりました。ただし、Grokの旧版であるGrok-2は1.9%、Grok-3は2.1%と比較的良好な成績を示しており、モデル世代による性能差が存在します。

存在しない統計データや架空の企業事例を、あたかも事実であるかのように提示することがあります。Grokが提供する情報、特に具体的な数値やデータについては、必ず一次情報源での確認を行うべきです。

GrokはX(旧Twitter)のデータに強く依存しているため、情報の偏りや誤情報拡散のリスクが顕著です。ファクトチェック機能も情報源自体が不正確な場合には有効に機能せず、過信は危険といえます。特に統計や出典を伴う情報については一次情報との照合が不可欠です。

企業がGrokを安全に活用するための5つの対策

企業がGrokを安全に利用するための最も重要な対策は、機密情報を絶対に入力しないという明確なルールを設定することです。顧客情報、従業員の個人情報、未発表の製品情報、財務データ、契約内容などはGrokへの入力を禁止すべきでしょう。

ソニーグループでは、2024年にAIツール利用ガイドラインを策定し、全従業員に配布するとともに、違反した場合の懲戒規定まで定めています。ガイドラインは一度作成して終わりではなく、新たなリスクが発見されるたびに更新していく必要があります。

Grokを使用する際は、必ずプライバシー設定を確認し、データ共有機能をオフにすることが重要です。X(旧Twitter)の設定画面から、Grokによるデータ学習への利用をオプトアウトする設定を行いましょう。この設定を行わないと、入力した情報がAI学習に使用されてしまいます。

会話履歴の公開設定も必ずプライベートにし、検索エンジンでインデックスされないようにする必要があります。残念ながら、これらの設定は初期状態では必ずしも安全ではないため、ユーザー自身が能動的に変更しなければなりません。

Grokの会話履歴は定期的に削除することを推奨します。履歴が蓄積すればするほど、万が一の漏洩時の影響が大きくなります。Grokには個別削除と一括削除の両方が可能で、設定画面から簡単に履歴を消去できます。定期的な履歴整理を習慣化することで、不要な情報がサーバーに長期間残るのを防げます。

企業アカウントでGrokを使用する場合は、誰がいつ何を質問したかを記録し、監査可能な状態にしておくことも重要です。アクセス権限を適切に管理し、不必要なユーザーには使用させないようにすべきです。

Grokの安全な利用には、技術的な対策だけでなく、従業員の意識向上が不可欠です。楽天グループでは、グループ全従業員を対象にAI利用ガイドラインに関するトレーニングを実施し、週次の全社員参加朝会やオフィス内スクリーンを通じて、AIリスクに関する意識向上を継続的に推進しています。

「これくらいなら大丈夫だろう」という軽い気持ちでの情報入力が重大な事故につながることを、具体例を交えて説明することが効果的です。サイバーセキュリティクラウドの2024年調査によると、セキュリティインシデントの原因として「人為的ミス」が27.3%を占めています。

また、IPAの内部不正調査では、違反行為の58%が「うっかり違反」(40.5%)や「ルールを知らずに違反」(17.5%)といった無意識的な要因によるものであることが判明しており、従業員教育の重要性が浮き彫りになっています。

企業はGrokをどの業務で使用してよいか、どの業務では使用禁止かを明確に定義すべきです。推奨される使用場面としては、公開情報の収集、一般的な市場トレンドの調査、アイデア出しなどが挙げられます。

一方、禁止すべき業務は、機密プロジェクトの相談、個人情報を含む作業、法的判断が必要な業務、契約書作成などです。NTTデータでは「AIツール利用可否マトリックス」を作成し、業務種類ごとに使用可能なAIツールを一覧化しています。明確な基準があることで、従業員は迷うことなく適切な判断ができます。

機密情報の入力禁止やプライバシー設定の初期状態に対する能動的な見直しは、漏洩リスクを大きく左右します。加えて、会話履歴の定期削除やアクセス権限の適切な管理により、情報の蓄積による被害拡大を防ぐことが可能です。さらに、従業員教育と利用範囲の明確化を組み合わせることで、技術だけでは防ぎきれない“人的リスク”にも対応できます。

ChatGPTとGrokの比較|企業利用での使い分け基準

セキュリティレベルの違い|ChatGPTの方が安全性が高い理由

企業利用の観点では、ChatGPTの方がGrokよりもセキュリティレベルが明確に高いと言えます。

OpenAIは、ChatGPT Enterpriseという企業向けプランを提供しており、データ学習への利用禁止、SOC 2準拠、暗号化通信、管理者向けダッシュボードなど、企業が求めるセキュリティ機能を網羅しています。Grokは2025年8月に37万件の会話履歴が検索エンジンにインデックスされる問題が発覚し、企業向けセキュリティ機能が発展途上であることが明らかになりました。

フォーチュン500企業のうち、92%以上がOpenAIの製品を業務に導入している一方、Grokの企業導入率は23%程度に留まっています。

情報精度と信頼性の比較

情報の精度と信頼性という観点でも、ChatGPTとGrokには明確な差があります。ChatGPTは膨大な学習データに基づき高精度な回答を生成する傾向がありますが、GrokはX(旧Twitter)のリアルタイムデータに大きく依存しており、情報の質にばらつきがあります。

xAI社も「Grokは100%正確ではなく、誤った情報や矛盾する情報を生成する可能性がある」と明言しています。一般知識ではChatGPTが優位ですが、Grokには「最新情報へのアクセス」という独自の強みがあるため、速報性が求められる場面では有用です。

コスト・機能・安全性のバランスでの総合評価

無料プランで使える範囲の違い

無料プランでの利用範囲を比較すると、両者には明確な違いがあります。ChatGPTの無料版は、GPT-3.5モデルへのアクセスが可能で、基本的な対話機能は十分に使えますが、応答速度や利用回数に制限があります。

Grokの無料版は、X Premiumに加入していないユーザーでも限定的に使用可能ですが、機能制限が多く、本格的な業務利用には不向きです。コスト面では、ChatGPT Plusが月額20ドル、ChatGPT Enterpriseは企業規模に応じた従量課金、Grokは基本的にX Premiumの月額8ドルに含まれます。

エンタープライズ向けプランの有無

企業向けプランの有無は、ビジネス利用において極めて重要な判断基準です。ChatGPTには明確なエンタープライズプランが存在し、専任サポート、SLA保証、カスタマイズオプション、管理者向けダッシュボードなど、企業が求める機能が充実しています。

対照的に、Grokには現時点で企業向けの専用プランが存在せず、サポート体制も個人ユーザー向けと変わりません。多くの日本企業では、エンタープライズプランの有無をAIツール採用の重要な判断基準としており、セキュリティとガバナンスが確立されたサービスを優先する傾向があります。

企業利用の観点では、現時点でChatGPTの方が総合的に優位といえます。

エンタープライズ向けのセキュリティ・ガバナンス機能の充実度はGrokと大きな差があります。一方で、GrokはXとの連携による「最新情報の取得力」が強みであり、速報性が求められる業務では有効に活用できます。したがって、両者を排他的に選ぶのではなく、情報精度・安全性・用途の特性を踏まえて併用戦略を検討するのが現実的です。

Grokの活用が効果的な業務シーン

SNS運用とリアルタイムのトレンド分析

Grokが最も効果を発揮するのは、SNS運用とリアルタイムのトレンド分析です。X(旧Twitter)のデータに直接アクセスできるため、競合他社のSNS戦略分析、自社ブランドの言及状況確認、炎上リスクの早期検知などに活用できます。

実際のアカウントデータに基づいた数値分析や、特定キーワードの投稿傾向、エンゲージメント内訳など、詳細な定量分析を自動で返してくれるのはGrok独自の強みです。ただし、Xのデータには偏りがあるため、他のSNSプラットフォームや市場調査データと組み合わせた総合的な分析が必要です。

市場動向調査と競合情報の収集

市場動向の初期調査や競合情報の収集にもGrokは有用です。特定の業界キーワードや競合企業名でGrokに質問することで、最近のニュースや業界の動き、消費者の関心事などを素早く把握できます。

新規事業の企画段階で、市場のニーズや競合状況を大まかに理解したい場合、Grokを使えば短時間で概要を掴めるでしょう。ただし、ここで得られる情報はあくまで「初期調査」レベルであり、重要な意思決定には、専門的な市場調査レポートや一次データの分析が不可欠です。

社内情報整理と要約作業の補助

Grokは、公開情報の整理や要約作業にも活用できます。業界ニュースの要約、複数の記事からの情報抽出、会議用の資料作成の下書きなど、時間のかかる作業を効率化できます。ただし、ここでも重要なのは「機密情報を含まない作業に限定する」という原則です。

公開されているニュース記事やプレスリリースの要約には使えますが、社内の機密文書や顧客情報を含む資料の作成には絶対に使用すべきではありません。Grokを「下書き作成ツール」として位置づけ、必ず人間が最終確認と編集を行うワークフローを確立することが重要です。

- SNSトレンドの即座な分析

- 競合他社の最新動向チェック

- 公開情報の要約作業

- 市場の初期調査

Grokは、SNSの即時性を活かした情報収集・分析ツールとして特に有効です。リアルタイムのトレンド把握や市場動向の初期調査、公開情報の要約といった「スピード重視」の業務で力を発揮します。一方で、得られる情報はX依存で偏りもあるため、他データソースとの併用が前提となります。また、社内機密を扱う作業には利用せず公開情報を対象とした下書き・補助用途に限定することで、安全かつ効果的な活用が可能です。

Grokを使うべきでない業務場面

機密プロジェクトや戦略立案での使用リスク

機密性の高いプロジェクトや企業戦略の立案にGrokを使用することは、極めて危険です。新製品開発、M&A検討、組織再編、コスト削減計画など、競合他社に知られてはならない情報をGrokに入力すると、会話履歴漏洩リスクやデータ学習への利用により、情報が外部に流出する可能性があります。

企業のコアコンピタンスに関わる戦略情報が漏洩した場合、競争優位性を完全に失う可能性があります。重要業務では、セキュリティが保証されたエンタープライズ版のAIツールか、オンプレミス型の生成AIソリューションを使用すべきです。

個人情報を含む業務での利用禁止

個人情報を含む業務でのGrok使用は、法的リスクの観点からも絶対に避けるべきです。顧客の氏名、住所、電話番号、メールアドレス、購買履歴などの個人情報をGrokに入力することは、個人情報保護法違反となる可能性があります。従業員の人事情報、給与データ、評価情報なども同様です。

万が一、これらの情報が漏洩した場合、企業は法的責任を問われるだけでなく、社会的信用も失墜します。日本ネットワークセキュリティ協会(JNSA)の調査によると、個人情報漏洩による損害賠償の相場は被害者1人あたり約3万円とされており、大規模漏洩事案では総損害額が数億円に達するケースもあります。

IPAの2024年調査では、中小企業のサイバーインシデントによる平均被害額は73万円と報告されていますが、個人情報漏洩の規模によっては企業経営に致命的な影響を与える可能性があります。

法的判断や契約書作成には不向き

法的な判断が必要な業務や契約書の作成にGrokを使用することは、専門性と責任の観点から不適切です。

Grokを含む生成AIは、法律の解釈や契約条項の作成において、重大な誤りを含む回答を生成する可能性があります。ハルシネーション問題により、存在しない判例や法令を提示することもあり得ます。

米国では、2023年に弁護士がChatGPTが生成した架空の判例を裁判所に提出し、懲戒処分を受けた事例があります。法務関連業務では必ず専門家(弁護士、法務部門)の確認を経ることであり、AIツールは参考情報の収集のみに限定すべきです。

- 機密プロジェクトの相談

- 個人情報を含む業務

- 法的判断が必要な業務

- 契約書の作成

- M&Aや組織再編の検討

戦略立案やM&Aといった高機密領域では、情報漏洩や学習利用による外部流出リスクが高く、企業の競争力を損なう可能性があります。個人情報の入力も法的な違反につながる恐れがあり、厳禁です。また、契約書作成や法律判断のような専門性の高い業務では、誤情報やハルシネーションの危険があるため、専門家の確認を前提とした補助的利用に留めるべきです。

他社AIツールとの比較

ChatGPT|安全性と正確性で企業利用に最適

ChatGPTは、現時点で企業利用に最も適したAIツールの一つです。OpenAIが提供するChatGPT Enterpriseは、データ学習への不使用、SOC 2 Type 2認証、GDPR準拠など、企業が求めるセキュリティ基準を満たしています。GPT-4モデルの精度は高く、専門的な内容にも対応できます。

フォーチュン500企業のうち、三菱UFJ銀行、富士通、日立製作所など日本企業も含め多くがChatGPTを業務に導入し、カスタマーサポート、コンテンツ作成、データ分析などで成果を上げています。

Claude|長文処理と分析業務に強み

Anthropic社が開発したClaudeは、長文処理と複雑な分析業務に優れたAIツールです。ChatGPTと比較して、一度に処理できるテキスト量が約3倍多く、長大な文書の要約や分析に適しています。

学術論文の要約、法律文書の分析、大量のメールの整理などで高い評価を得ています。安全性の面でも、Anthropicは「Constitutional AI」という独自のアプローチで、より安全で制御可能なAIを目指しており、企業利用でも信頼できます。

Gemini|Google連携による情報検索力

GoogleのGeminiは、Google検索やGoogleサービスとの連携が最大の強みです。最新情報へのアクセス、YouTube動画の要約、Googleドキュメントとの統合など、Googleエコシステムを活用している企業には有用です。

情報の正確性も、Googleの膨大な検索データベースを活用できるため、高い水準にあります。Google Workspace for Businessを利用している企業であれば、統合的なセキュリティ管理が可能です。

Grok|スピード重視の情報収集に特化

Grokは、リアルタイム性とスピード重視の情報収集に特化したAIツールとして位置づけられます。X(旧Twitter)の最新データに即座にアクセスできる点は、他のAIにはない独自の強みです。トレンド分析、SNS監視、炎上リスク管理など、速報性が求められる業務では有用でしょう。

ただし、本記事で詳述してきた通り、セキュリティリスク、情報精度、企業向けサポートの不足など、企業利用における課題も多くあります。Grokは「メインツール」ではなく「補助ツール」として、限定的な用途で使用するのが適切です。

ChatGPTはセキュリティと精度の高さから企業利用の主軸に最適であり、Claudeは長文処理や高度な分析に強みを発揮します。GeminiはGoogleサービスとの統合による情報検索力が魅力です。一方、Grokはリアルタイム性に優れていますが、企業利用ではセキュリティや信頼性の面で補助的な位置づけにとどめるのが賢明です。

企業のAI導入で重視すべきポイント

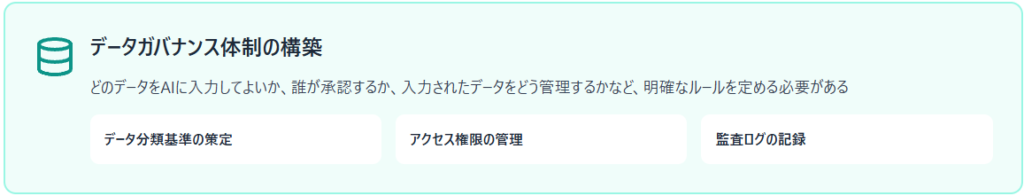

データガバナンス体制の構築

企業がAIツールを導入する際、最も重要なのがデータガバナンス体制の構築です。どのデータをAIに入力してよいか、誰が承認するか、入力されたデータをどう管理するかなど、明確なルールを定める必要があります。データ分類基準の策定、アクセス権限の管理、監査ログの記録などが含まれます。

企業がデータガバナンスを導入するには、IT部門、法務部門、事業部門が連携した体制構築が推奨されており、データガバナンス委員会の設置やデータの透明性確保が求められます。データガバナンスが不十分な状態でAIを導入すると、必ずといってよいほど情報漏洩やコンプライアンス違反のリスクが顕在化します。

インシデント発生時の対応プロトコル整備

AIツール使用中に情報漏洩や不適切な情報生成などのインシデントが発生した場合の対応プロトコルを事前に整備しておくことが重要です。インシデントの定義、報告ルート、初動対応手順、エスカレーション基準、関係者への通知方法などを明文化すべきでしょう。

Grokのような新しいツールでは、予期せぬ問題が発生する可能性が高いため、迅速な対応体制が求められます。ソフトバンクグループでは、AI関連インシデントの対応マニュアルを作成し、四半期ごとに模擬訓練を実施しています。

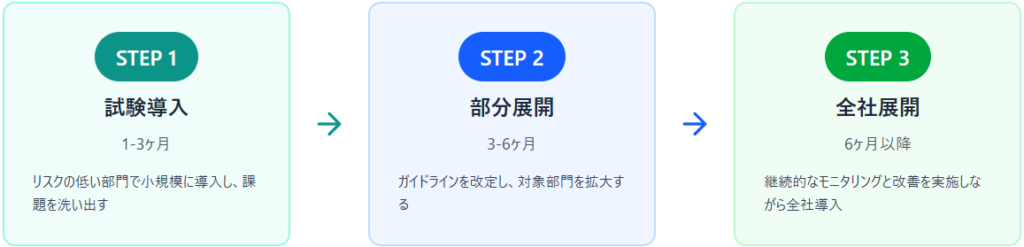

段階的導入によるリスク管理手法

AIツールの導入は、一気に全社展開するのではなく、段階的に進めることでリスクを管理すべきです。第一段階では、リスクの低い部門や業務で試験導入し、問題点を洗い出します。第二段階では、試験導入の結果を踏まえてガイドラインを改定し、対象部門を拡大します。

第三段階で全社展開を行い、継続的なモニタリングと改善を実施します。トヨタ自動車では、デジタル技術の導入において「小さく始めて大きく育てる」アプローチを採用し、2023年にAIツールを段階的に全社展開することで、大きな問題なく導入に成功しています。

技術選定よりも先にデータガバナンスとリスク管理体制の確立が不可欠です。入力可能な情報の範囲や承認フローを明確に定め、インシデント対応プロトコルを事前に整備することで、想定外のトラブルにも迅速に対処できます。また、段階的な導入プロセスを採用することで、初期段階でリスクを最小化しつつ、組織全体への安全な展開が可能になります。

よくある質問|Grokのビジネス活用

Grokで入力した内容は他人にバレますか?

Grokで入力した内容が他人にバレる可能性は十分にあります。

2025年8月に発覚した37万件の会話履歴漏洩事例が示すように、Grokの会話共有機能の初期設定によっては、入力内容が検索エンジンで公開されてしまいます。xAIの利用規約上、入力データがAI学習に使用される可能性もあり、将来的に他のユーザーへの回答として類似内容が生成されるリスクもあります。

対策としては、プライバシー設定を必ずプライベートに変更し、データ学習のオプトアウト設定を行い、会話履歴を定期的に削除することが重要です。

企業で安全にGrokを使うにはどうすればいい?

企業で安全にGrokを使用するには、複数の対策を組み合わせる必要があります。

まず、社内ガイドラインを策定し、機密情報の入力を厳格に禁止します。次に、プライバシー設定を最適化し、データ共有をオフにします。さらに、従業員向けのセキュリティ教育を定期的に実施し、リスクへの意識を高めます。利用範囲を明確に定義し、推奨業務と禁止業務を区別します。

会話履歴は定期的に削除し、アクセス管理を徹底します。重要な業務にはGrokではなく、エンタープライズ版のChatGPTなど、より安全性の高いツールを使用することを強く推奨します。

ChatGPTとGrok、どちらを選ぶべきですか?

ChatGPTとGrokのどちらを選ぶべきかは、使用目的と求めるセキュリティレベルによります。

機密情報を扱う業務や重要な意思決定には、セキュリティ体制が整ったChatGPT、特にエンタープライズ版を選ぶべきです。公開情報のトレンド分析やSNS監視など、速報性が重要で機密性の低い業務では、Grokの活用も検討できます。両者を併用し、業務の性質に応じて使い分けることが効果的でしょう。

例えば、初期調査はGrokで行い、本格的な分析や文書作成はChatGPTで行うという組み合わせが考えられます。

Grokのデータ学習をオフにする方法は?

Grokのデータ学習をオフにするには、X(旧Twitter)の設定画面から操作を行います。

「設定とプライバシー」→「プライバシーと安全」→「データ共有とパーソナライゼーション」→「Grokによる学習」の順に進み、データ学習への利用を無効化します。ただし、この設定項目の名称や場所は、Xのアップデートにより変更される可能性があるため、最新の情報を確認することが重要です。

この設定を行っても、過去に入力したデータが完全に削除されるわけではない点にも注意が必要です。根本的な安全策は、機密情報を最初から入力しないことです。

無料版Grokを業務利用しても問題ありませんか?

無料版Grokを業務利用することには、いくつかのリスクがあります。

まず、無料版では機能制限があり、本格的な業務には不十分な場合があります。無料版でもデータ学習や会話履歴の漏洩リスクは有料版と同様に存在します。さらに、企業向けのサポートやSLA保証がないため、トラブル発生時の対応が遅れる可能性があります。

一方で、公開情報の簡易的な調査など、リスクの低い用途であれば、無料版でも問題ない場合もあります。無料版を業務利用する場合は、社内ガイドラインで利用範囲を厳格に制限し、機密情報は絶対に入力しないという原則を徹底することが必要です。