Hugging Faceは安全?企業導入前に確認すべきセキュリティリスクと対策方法

「Hugging Faceを企業で導入したいが、セキュリティ面は本当に安全なのか?」 AI活用を検討している企業担当者の多くが抱くこの疑問は、決して杞憂ではありません。

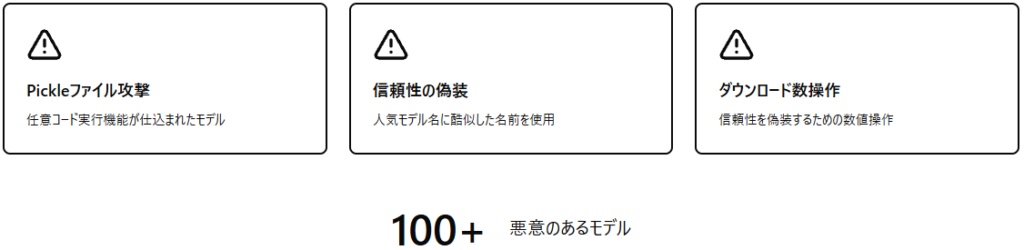

このプラットフォーム上では100個以上の悪意のあるAIモデルが発見され、新たなサプライチェーン攻撃の脅威も次々と明らかになっています。一方で、シスコやマイクロソフトなどの大手企業も積極的に活用しており、適切な対策により大きなビジネス価値を実現している事例も存在します。

本記事では、JFrogの調査で明らかになったPickleファイル攻撃の実態から、2025年9月に発見されたモデル名前空間再利用攻撃まで、最新のセキュリティ脅威を具体的な事例とともに詳しく解説いたします。

- Hugging Faceで発生している最新のセキュリティ脅威

- 企業導入前に必須の安全性チェックポイント

- SafeTensors形式とPickleファイルの違いと対策

- SOC2認証・GDPR準拠など企業向けコンプライアンス体制

- JFrogとProtect AIによる第三者セキュリティツール連携効果

Hugging Faceとは?企業が知るべき基本情報

プラットフォームの概要と企業利用の現状

Hugging FaceはGitHubのAI版とも呼ばれる世界最大級のオープンソースAIモデル共有プラットフォームで、現在200万以上のモデルが公開されています。

シスコなどの大手企業も積極的に活用しており、日本企業でも通信業界を中心に独自の日本語LLM公開が活発化しております。プラットフォームはモデル保管場所としての役割を超え、API経由でのリアルタイム推論機能も提供しています。

ビジネス活用における価値とリスクのバランス

このプラットフォームは企業にとって開発期間の大幅短縮を可能にする一方で、セキュリティリスクも存在いたします。

適切な対策により大きなビジネス価値を実現できますが、金融業界では独自のセキュリティレイヤー追加が必要な状況です。企業導入時には価値とリスクの慎重なバランス評価が求められます。

ReAlice株式会社 AIコンサルタント

ReAlice株式会社 AIコンサルタント公開モデルの利用やAPI連携は開発効率を高めますが、機密情報の扱いやアクセス制御を誤ると情報漏洩のリスクが生じます。特に金融・医療分野では、独自の検証プロセスやセキュリティレイヤーを追加することで、安全性とビジネス価値の両立が可能になります。

Hugging Faceで確認された主要セキュリティ脅威

Pickleファイルによる任意コード実行攻撃の実態

JFrogの調査で発見された100個以上の悪意のあるモデル

DevOpsツール大手のJFrogが2024年に実施した調査により、100個以上の悪意のあるAIモデルが発見されました。これらのモデルは一見正常な自然言語処理モデルに見えますが、実際にはPickleファイルに任意コード実行機能が仕込まれています。

攻撃者は人気モデル名に酷似した名前を使用し、ダウンロード数を操作することで信頼性を偽装しています。JFrogの継続的なスキャンにより、多数の悪意のあるモデルが削除されている状況です。

攻撃手法と被害の詳細

- Pythonオブジェクトの逆シリアル化プロセスで任意のコードを実行

- モデル読み込み時にバックドアが自動的にインストール

- 被害者が侵害に気づかない点が特に深刻

- 重要な内部システムへのアクセス権限を奪われるリスクがある

モデル名前空間再利用攻撃の新たな脅威

2025年に発見された攻撃手法

2024年に研究され、2025年2月にGoogleに報告された「Model Namespace Reuse」攻撃は、放棄されたモデル名前空間を攻撃者が再登録することで実行される新しい脅威です。

Author/ModelName形式で識別されるモデルが、作成者のアカウント削除により名前空間が再利用可能な状態になってしまいます。攻撃者はこの仕組みを悪用し、信頼されていた既存のモデル名を乗っ取って悪意のあるモデルに置き換えています。

Microsoft Azure AI FoundryやGoogle Vertex AIへの影響

- Azure AI Foundryで攻撃者が未申請の名前空間を登録成功

- エンドポイントでリバースシェルを生成しAzure環境への侵入に成功

- GitHub上の数千のオープンソースプロジェクトに影響が及んでいる

サプライチェーン攻撃の拡大とその影響

AIモデルのサプライチェーン攻撃が2025年に急速に拡大し、OWASP Top 10 for LLM Applications 2025版でも「LLM03: Supply Chain Vulnerabilities」として重要リスクに位置づけられています。

攻撃者は人気のAIライブラリを模倣した悪意のあるパッケージを公開し、JarkaStealerなどの情報窃取マルウェアを配布する事例が増加しています。KaggleなどのプライベートレジストリでもHugging Faceとの直接的なやり取りがないユーザーが同様の脅威にさらされる状況となっています。

Pickleファイルを悪用した任意コード実行や名前空間再利用攻撃は、開発環境への深刻な侵入経路となり得ます。特にモデルの導入時には、署名確認やハッシュ検証、信頼済み発行元の限定など、サプライチェーン防御を意識したプロセスが重要です。

Hugging Faceが実装するセキュリティ対策

多層防御システムの仕組み

マルウェアスキャンによる脅威検出

Pickleスキャンの役割と効果

Pickleファイル特有のリスクに対応するため、MicrosoftとのCollaborationによるオープンソースのモデルスキャナー「Picklescan」を実装しています。このツールはPythonオブジェクトのシリアル化ファイルを精査し、任意コード実行の可能性があるPickleファイルを事前に識別します。

スキャン結果はリポジトリページに表示され、ユーザーは潜在的なリスクを事前に確認できる仕組みとなっています。

SafeTensors形式による根本的リスク排除

従来のPickleファイルとの違い

Pickleファイルのセキュリティ問題を解決するため、SafeTensors形式の採用を積極的に推進しています。SafeTensorsは設計上、Pythonコードがファイルに保存されることを完全に防ぎ、モデルの重みと実行可能コードを厳密に分離する仕組みを採用しています。

従来のPickleファイルが任意のPythonオブジェクトを保存できるのに対し、SafeTensorsは純粋にテンソルデータのみを扱います。

パフォーマンス向上と安全性の両立

- CPUでは76.6倍、GPUでは2.1倍の高速化を実現

- ゼロコピーとレイジーローディングによりメモリ使用量を削減

- 企業の本番環境でも実用的な選択肢

- Hugging Faceで公開される新しいモデルは全てSafeTensors形式で保存されている

第三者セキュリティツールとの連携強化

Protect AIとJFrogとの統合効果

専門的なセキュリティベンダーとの戦略的パートナーシップにより、より高度な脅威検出機能を提供しております。Protect AIとの連携では、AI特有の攻撃パターンに特化した検出アルゴリズムが導入されています。

JFrogとの統合により、DevOpsパイプライン全体でのセキュリティ監視が実現し、開発フローの各段階でリスクを早期発見できる体制が構築されました。

誤検知率96%削減の実現

- 従来のスキャナーが生成していた誤検知を排除

- 実際の脅威をより正確に識別可能に

- 開発チームは真の脅威への対応に集中できる

- 機械学習による継続的な学習機能で検出精度が日々向上

Hugging Faceは従来の単純なマルウェア検知にとどまらず、PicklescanやSafeTensorsなどの仕組みを組み合わせた多層防御により、モデル流通時のリスクを根本から軽減しています。特にSafeTensors形式の普及は、任意コード実行リスクを技術的に封じる実効的な対策といえます。

企業認証とコンプライアンス体制

SOC2 Type 2認証とGDPR準拠の意義

SOC2 Type 2認証を取得し、セキュリティ、可用性、処理の整合性、機密性、プライバシー保護に関する厳格な基準をクリアしています。

この認証により、企業のコンプライアンス要件を満たし、監査対応も容易になります。GDPR準拠も実現しており、EU域内の個人データ処理に関する法的要件を満たしています。

エンタープライズ向けセキュリティ機能

プライベートリポジトリとアクセス制御

エンタープライズプランでは、機密性の高いAIモデルを安全に管理するためのプライベートリポジトリ機能を提供しています。組織内での細かなアクセス制御が可能で、チーム単位やプロジェクト単位での権限管理を実現できます。

リソースグループ機能により、関連するモデルやデータセットを論理的にグループ化し、一元的な管理も可能です。

多要素認証とコミット署名

標準装備され、不正アクセスのリスクを大幅に軽減

モデルの変更履歴と作成者を暗号学的に保証し、サプライチェーン攻撃への対策を講じている

SOC2 Type 2認証やGDPR準拠といった国際的な基準を満たすことで、企業の法的・監査対応の信頼性を確保しています。加えてプライベートリポジトリやアクセス制御、多要素認証、コミット署名といったエンタープライズ機能が、モデルの保護と改ざん防止を強固に支えています。

企業導入時の実践的リスク対策

導入前のリスク評価フレームワーク

信頼できるソースの選択基準

- モデルの作成者が実在する組織や個人であること

- GitHubプロファイルや公式ウェブサイトとの一貫性をチェック

- ダウンロード数が異常に多い新規モデルに注意

- モデルカードの記載内容を詳細に確認

- 「Verified」バッジの有無を確認

社内セキュリティポリシーとの整合性確認

導入前には既存のセキュリティポリシーとの整合性を必ず確認し、必要に応じてポリシーの更新も実施してください。

データ分類レベルに応じたモデル利用制限や、機密情報の処理可否について明確なガイドラインを策定することが重要です。情報セキュリティ部門との事前協議を必須とし、リスクアセスメントの結果を文書化して保管する体制を整備しましょう。

運用時のベストプラクティス

機密情報入力制限ガイドライン

個人情報、営業秘密、技術仕様などの機密データの入力を禁止するガイドラインを策定

入力データの事前マスキングやサンプルデータの活用を推奨し、本番データを直接使用することは避ける

APIキーの定期ローテーションやアクセスログの監視も実装

従業員教育プログラムの重要性

AIモデル利用に関する従業員教育プログラムを定期的に実施し、セキュリティ意識の向上を図ります。具体的な脅威事例を交えた研修により、Pickleファイルの危険性や悪意のあるモデルの見分け方を教育してください。

新入社員研修にもAIセキュリティの項目を追加し、全社的な意識統一を図ることが重要です。

技術的セキュリティ強化策

環境変数管理とアクセス制御

- APIキーや認証情報は環境変数として適切に管理

- ソースコードに直接記載することを禁止

- HashiCorp VaultやAWS Secrets Managerなどのシークレット管理ツールを活用

- 最小権限の原則に基づく権限管理を実施

定期的なセキュリティ監査の実施

月次でのセキュリティ監査を実施し、利用中のモデルに新たな脅威が発見されていないかを確認してください。

JFrogやProtect AIなどの第三者セキュリティツールを活用し、継続的なモニタリング体制を構築しましょう。監査結果は経営層にも報告し、必要に応じてセキュリティ予算の追加配分を検討することが望ましいです。

モデルの信頼性チェックや社内ポリシーとの整合確認を導入前に徹底し、導入後は機密情報入力制限・認証管理・従業員教育・定期監査といった多層的な対策を組み合わせることで、実運用でのリスクを最小限に抑えられます。特にモデル選定と教育の両輪を軽視しないことが、長期的な安全運用の基盤となります。

業界動向と将来的な展望

AI供給チェーンセキュリティの重要性

OWASP Top 10 for LLM Applications 2025版では、AI供給チェーンの脆弱性が上位リスクとして位置づけられ、業界全体での対策強化が求められています。

オープンソースプラットフォームでは、モデルの真正性確保が課題となっており、デジタル署名やブロックチェーンを活用した検証システムの導入が検討されています。サプライチェーン全体での透明性向上により、モデルの開発履歴や依存関係を追跡可能にする取り組みも進んでいます。

規制強化の動向と企業への影響

- EU AI Actによる高リスクAIシステムへの規制強化

- 米国における州レベルでのAI規制法案の相次ぐ提出

- カリフォルニア州AI安全法案による大規模AIモデルの安全性評価義務化

- 日本でのデジタル庁によるAI利用ガイドライン改定

セキュリティ技術の進化方向

AIモデルのセキュリティ技術は急速に進化しており、連合学習や差分プライバシーなどの技術により、データを共有せずにモデルを学習する手法が実用化されています。ホモモルフィック暗号を活用した秘匿計算により、暗号化されたデータのまま推論を実行する技術も実装段階に入っています。

次世代セキュリティ機能として、ゼロトラストアーキテクチャーの導入やリアルタイム脅威検知システムの強化も予定されており、企業利用での安全性向上が期待されます。

OWASPの指摘や各国の規制強化を踏まえると、モデルの真正性検証や依存関係の可視化は企業運用において必須の要素です。さらに、連合学習・秘匿計算・ゼロトラストといった新技術の実装が進むことで、AI活用の安全基盤は一層強化されると考えられます。企業は法制度と技術進化の両面を継続的にウォッチし、柔軟な対応体制を整えることが重要です。

よくある質問|Hugging Faceの企業利用における安全性

Hugging Faceは企業利用に適したセキュリティ認証を取得していますか?

SOC2 Type 2認証を取得し、企業のセキュリティ要件を満たす体制を整備しています。

この認証により、セキュリティ、可用性、処理の整合性、機密性、プライバシー保護について第三者による厳格な監査をクリアしています。

GDPR準拠も実現しており、EU域内での個人データ処理に関する法的要件も満たしているのです。

AIモデルダウンロード時の安全性はどのように確保されていますか?

多層的なセキュリティシステムによりモデルの安全性を確保しています。

マルウェアスキャンにより既知の脅威を検出し、危険性が確認されたファイルについてはダウンロード前にユーザーへ警告を表示いたします。MicrosoftとのCollaborationで開発されたPicklescanにより、任意コード実行のリスクがあるPickleファイルを事前に識別しています。

企業が独自のセキュリティ対策を追加する必要はありますか?

- 基本セキュリティ機能だけでは不十分

- モデル選択時の厳格な評価基準の確立が必要

- 機密情報入力の制限ガイドライン策定が重要

- JFrogやProtect AIなどの第三者セキュリティツールの併用を推奨

悪意のあるモデルを見分ける方法はありますか?

モデル作成者の信頼性を確認し、実在する組織や個人であることを検証

異常に多いダウンロード数を持つ新規モデルや、人気モデルに類似した名前のモデルには特に注意

可能な限りSafeTensors形式のモデルを選択し、Pickleファイル形式は避けることを推奨

プライベートリポジトリ利用時の追加セキュリティ機能はありますか?

エンタープライズプランでは、プライベートリポジトリ利用時に高度なセキュリティ機能を提供しています。組織内での細かなアクセス制御により、チーム単位やプロジェクト単位での権限管理が可能です。

多要素認証(MFA)により不正アクセスのリスクを大幅に軽減し、コミット署名機能でモデルの変更履歴と作成者を暗号学的に保証しています。