Whisper情報漏洩とは|暗号化AIチャットでも高精度で会話内容を特定される脅威と企業の対策

「暗号化すれば安全」と考えていませんか?2025年11月7日、Microsoftが公表したWhisper Leakは、その常識を覆す新たな脅威です。ChatGPTやGoogle Geminiなどの主要AIサービスを利用する企業にとって、この情報漏洩リスクは決して他人事ではありません。

TLS暗号化で保護された通信であっても、パケットサイズや送信タイミングといったメタデータから会話トピックが推測され、企業の機密情報や戦略的な意思決定内容が競合他社に筒抜けになる可能性があります。

本記事では、AIコンサルタントの視点から、Whisper Leakの攻撃メカニズム、ビジネスへの具体的な影響、そして今すぐ実施すべき対策まで、実践的な情報を網羅的に解説します。

- Whisper Leakの攻撃メカニズムと深刻なセキュリティリスク

- ChatGPT・Google Gemini利用時に起こりうる具体的な情報漏洩シナリオと企業への影響

- OpenAI・Microsoft・Mistral等の対策実装状況と選定基準

- 公共Wi-Fi禁止・VPN必須化・DLP導入など今すぐ実施すべき実践的な対策手順

- 中小企業から大企業まで対応できる段階的なセキュリティ強化のロードマップ

Whisper Leakとは何か?

暗号化通信でも会話内容が推測される新たな脅威

Whisper Leakは、2025年11月にMicrosoftが公表した大規模言語モデル(LLM)を標的とする新種のサイドチャネル攻撃です。TLS暗号化で保護された通信でも、パケットサイズや送信タイミングといったメタデータを解析すれば、AIチャットボットとの会話トピックを高精度で特定できます。

TLS暗号化では平文サイズからパケットサイズが推測可能な特性があり、Whisper Leakはこの弱点を突きます。「暗号化すれば安全」という常識が覆され、AI活用を推進する企業に深刻な警告を発しています。

主要なAIサービスが影響を受ける可能性

Microsoft Security Research Teamが28種類のLLMを調査した結果、17モデルで98%以上の攻撃成功率が確認されました。ChatGPT、Google Gemini、Microsoft Copilot、Claudeといった主要サービスがこの脆弱性の影響を受ける可能性があります。

研究チームは「Whisper Leakは非常に効果的な攻撃手法」と結論づけており、広範なAIチャットサービスがシステム的なリスクに直面している状況です。

発見の経緯と企業への警鐘

Microsoft Security Research Teamが発見したこの脆弱性は、AIサービスのプライバシー保護における新たな課題を提示しました。通信経路上の暗号化だけでは守れない情報漏洩経路が存在することが判明しています。

研究チームは責任ある情報開示プロセスに従い、OpenAI、Mistral、Microsoft、xAIに事前通知を実施しました。2025年11月時点で、これらのベンダーはすべて緩和策を実装済みです。

ReAlice株式会社 AIコンサルタント

ReAlice株式会社 AIコンサルタントWhisper Leakは、暗号化通信だけでは防ぎ切れないLLM特有の副次的情報漏えいリスクを顕在化させた事例です。

パケットの大きさや送信タイミングといったメタデータ解析で会話内容を推測できる点は、従来の暗号化依存モデルの限界を示しています。

攻撃の仕組みと実証された脅威

メタデータ解析による会話トピックの特定手法

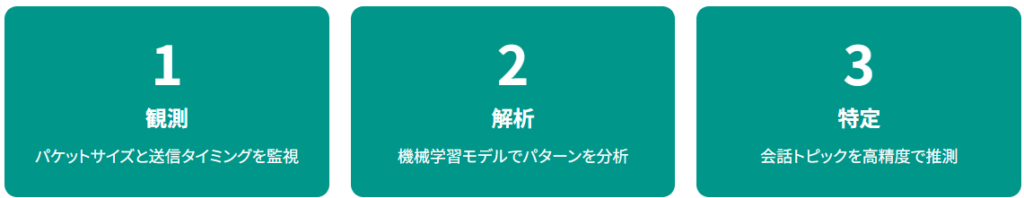

Whisper Leakは暗号化内容を直接解読せず、パケットサイズや送信タイミング、シーケンスパターンといったメタデータを分析して会話テーマを推測します。送信される「パケットサイズ」と「送信タイミング」のパターンはネットワーク監視者から観測可能で、この漏洩したメタデータが攻撃の標的となります。

異なるテーマの会話は一貫した差異を持つメタデータパターンを生成するため、攻撃者は機械学習モデルでこのパターンから会話内容を推測できます。

98%超の攻撃成功率が示す深刻度

Microsoftの検証では「マネーロンダリングの合法性」をテーマとした質問100種類を生成し、約1万1700件の無関係な質問と比較する実験を行いました。

調査した28種類のAIモデルのうち17種類において、攻撃成功率は98%を超えました。現実の監視状況では、1万件の会話のうち1件のみが特定トピックを含む状況でも、誤判定を出さずに数%から50%の割合で対象トピックを検出できる可能性があります。

AIストリーミング応答の特性を悪用した分析

この攻撃はストリーミング方式で応答を生成する言語モデルにおいて、暗号化通信のパケットサイズや送受信の時間間隔から特徴を抽出し、通信内容の一部を間接的に識別する手法です。ChatGPTやAzure OpenAIなどの「ストリーミング応答」特性を悪用したリモート型サイドチャネル攻撃に分類され、攻撃者が違法行為や政治的発言といったセンシティブなトピックを検出できます。

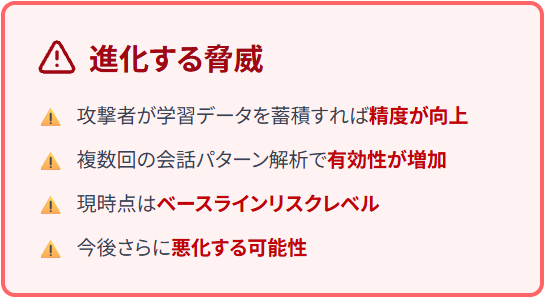

研究チームは、現時点の結果がリスクの初期水準を示すものであり、攻撃者が学習データを蓄積すれば精度が向上する可能性があると警告しています。

パケットの挙動という副次情報だけで高精度なトピック推測が可能であり、ストリーミング応答を行うLLMほど影響を受けやすい点は深刻です。

実証された高い成功率は、攻撃者が追加データを蓄積することでさらなる精度向上が見込まれることを示唆しています。

サービス提供側の緩和策だけでなく、利用環境でのネットワークレベルの保護も検討が必要です。

ビジネスで想定される具体的なリスク

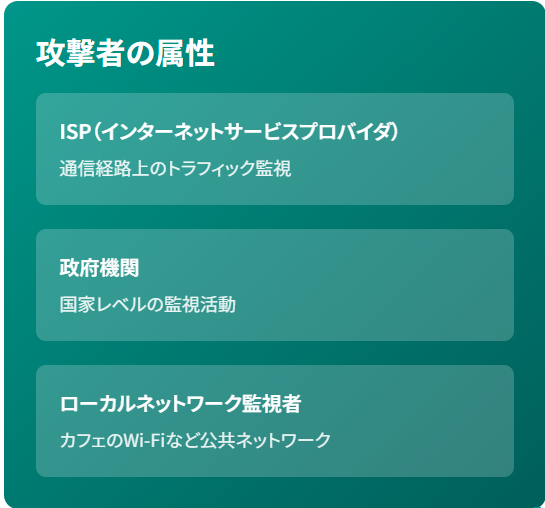

攻撃者の属性とアクセス可能な立場

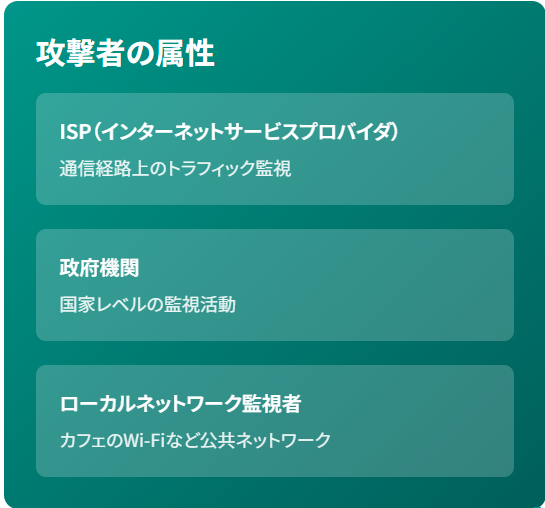

攻撃を実行できるのは、暗号化トラフィックを観測できる立場にある攻撃者に限定されます。インターネットサービスプロバイダ(ISP)や政府機関、カフェのWi-Fiのようなローカルネットワークの監視者が該当します。

Microsoftは、このような状況で攻撃者がトラフィックを解析し、ユーザーが特定の話題に関する質問をしているかを高精度で判定できると説明しています。

機密情報漏洩による競争力の低下

新製品開発、M&A交渉、財務戦略などの会話トピックが推測されれば、競合他社による情報収集や市場での優位性喪失につながります。複数回にわたる会話や同一ユーザーの通信パターンを解析することで、攻撃の有効性が増すことも確認されており、長期的な監視による情報蓄積のリスクも無視できません。

特に長期的な監視により、競合他社が戦略的情報を継続的に収集するリスクがあり、グローバル競争の激化により、セキュリティリスクへの迅速な対応が求められる局面を迎えています。

医療・金融・法律分野でのコンプライアンス違反

医療機関の診断支援、金融機関の融資審査、法律事務所の法的相談など、センシティブな個人情報を扱う業界では、Whisper LeakによりGDPRや個人情報保護法などの規制違反リスクが発生します。医療機関が患者の症状をAIに入力して診断支援を受ける際、会話トピックが「特定の疾患」と推測されれば患者のプライバシー侵害となり、法的責任を問われます。

攻撃者は「Whisper Leak」でユーザーのネットワークトラフィックを観察し、センシティブな会話を識別・マークする可能性があるため、規制の厳しい業界では特に深刻な問題です。

セキュリティインシデントによる信頼失墜

顧客情報を扱うAI活用でセキュリティインシデントが発生した場合、企業の信頼失墜とブランド毀損は避けられません。Whisper Leak攻撃は従来のマルウェア感染と異なり、ランサムウェアのような明確な通知がなく、継続的なアクセスと隠密なデータ抽出を優先するため、従来のセキュリティツールでは検出が困難です。

AIを標的とした攻撃は高度化・高速化しており、特に顧客データを扱う企業では、一度のインシデントが取引停止や訴訟につながる可能性があります。

通信を観察できる立場の攻撃者に限定されるものの、推測されるトピックが戦略情報や個人データの場合、影響は極めて深刻です。

医療や金融など規制の厳しい領域では、トピック特定だけでも法令違反に発展する可能性があります。

従来の攻撃とは異なり、静かに継続して情報を抽出するため、検知の難しさもリスクを増幅させます。

企業が今すぐ実施すべき対策

主要ベンダーの対策実装状況を確認する

OpenAI、Mistral、xAI、Microsoft自身のクラウド環境では既に対策が講じられています。OpenAIとMicrosoft Azureは応答データにランダムな長さのテキスト列を追加する「obfuscation」フィールドを導入し、トークン長の特徴が外部から推測されにくい設計になっています。

Mistralも同様の効果を持つ新パラメーター「p」を実装済みです。Microsoftは、これらの対策により攻撃の有効性が実用的なリスク水準を下回ることを確認したと述べています。

公共Wi-Fi禁止とVPN必須化を徹底する

公共Wi-Fiや信頼できないネットワークでのAI利用を禁止し、VPN必須化のポリシーを策定することで、トラフィック傍受のリスクを軽減できます。

リモートワークが普及した現在、従業員がカフェや空港などの公共スペースからAIサービスにアクセスするケースが増加しており、ネットワークセキュリティの強化が急務となっています。ゼロトラストネットワークの構築により、通信経路全体でのセキュリティを確保する方法も有効です。

センシティブ情報のAI入力ガイドラインを策定する

部門ごとにAI利用範囲を明確化し、どのような情報をAIに入力してよいか、禁止事項は何かを明文化したガイドラインを作成します。個人を特定できる情報(PII)、企業の機密情報、未公開の財務データなどは入力を禁止し、一般的な業務サポート(メール下書き、議事録作成など)のみに利用を限定するルールが求められます。

定期的なセキュリティ教育を実施し、従業員のChatGPT個人利用状況を調査する体制も整えることで、シャドーAI(IT部門が把握していないAI利用)のリスクを管理できます。

データ損失防止(DLP)ソリューションを導入する

DLPソリューションは、事前に設定した条件に基づいてデータを監視し、機密情報の不適切な送信を防止します。

クレジットカード番号、マイナンバー、社外秘マークが付いた文書などがAIサービスに送信されようとした際、自動的にブロックまたはアラートを発信する機能があります。DLPとAI利用ガイドラインを組み合わせることで、従業員の利便性を損なわずにセキュリティを強化できます。特に生成AI保護機能を持つDLP製品の導入が有効です。

プライベートLLMとオンプレミス型の検討

プライベートLLMの社内展開やオンプレミス型AIソリューションの評価は、外部ネットワークを経由しないため、ISPレベルでの傍受リスクを大幅に低減できます。社内ネットワーク内での傍受リスクは依然として存在するため、アクセス制御やログ監視などの内部セキュリティ対策も並行して実施する必要があります。

初期投資コストは高くなりますが、長期的にはデータガバナンスとコンプライアンス遵守の面でメリットがあり、特に金融機関や医療機関など規制の厳しい業界では、オンプレミス型の導入を優先的に検討すべきです。

定期的なセキュリティ教育の実施

従業員への定期的なセキュリティ教育は、技術的対策と同様に重要です。Whisper Leakのような新たな脅威について、どのようなリスクがあり、どのような行動が推奨されるかを具体的に説明します。「公共Wi-Fiで機密情報をAIに入力しない」「センシティブなトピックの会話は社内ネットワークのみで行う」といった実践的なアドバイスを提供し、定期的にアップデートすることで、従業員のセキュリティ意識を維持します。

教育内容では「なぜ重要か」を理論的に説明することで、従業員の自発的な協力を促すことができます。実践的な事例を交えた説明が効果的です。

VPN必須化や公共Wi-Fiの禁止といった基本対策は、攻撃観測者の立場を制限する意味でも効果的です。DLPやガイドライン整備により、現場での誤ったAI利用を抑制でき、シャドーAIへの対処にもつながります。

プライベートLLMの導入検討は、法規制の厳しい業界において中長期的な有効策となります。

ベンダー選定で重視すべきポイント

Whisper Leak対策実装済みサービスの優先選択

OpenAI、Microsoft Azure、Mistral、xAIはすべてWhisper Leak対策を実装済みであり、これらのサービスを優先的に選択することが推奨されます。ChatGPT Enterpriseなどの法人向けサービスは、ユーザーが入力した情報をAI学習に使用せず、すべての会話データが暗号化される設計になっているため、セキュリティレベルが高くなっています。

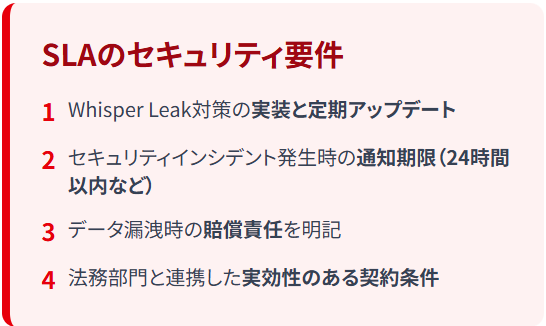

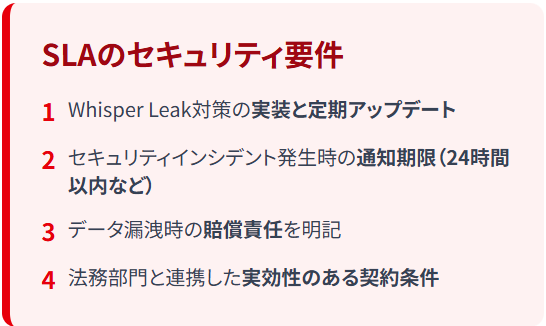

ベンダー選定時には、SLA(Service Level Agreement)にセキュリティ要件を明記し、対策の実装状況や今後のアップデート計画を確認することが重要です。

ストリーミングモードとバッチモードの使い分け

ストリーミングモードではLLMトークンが順次送信され、トークン長のサイドチャネルが発生します。機密性の高い会話では非ストリーミングモード(バッチモード)の利用を検討し、トークン応答をランダムな長さのノイズでかさ上げする機能を持つサービスを選択することで、パケットから応答が推測されるリスクを軽減できます。

ただしバッチモードも完全な保護ではなく、一般的なメール作成はストリーミングモード、財務データの分析はバッチモードとノイズ追加機能を併用するといった柔軟な運用が推奨されます。

SLAにセキュリティ要件を明記する重要性

ベンダーとのSLAにセキュリティ要件を明記することで、対策の実装状況やインシデント発生時の対応責任を明確化できます。「Whisper Leak対策の実装と定期的なアップデート」「セキュリティインシデント発生時の通知期限(24時間以内など)」「データ漏洩時の賠償責任」などを契約に含めることで、法的保護を強化します。

金融機関や医療機関など規制の厳しい業界では、SLAの詳細な取り決めが不可欠です。SLA交渉時には自社の法務部門と連携し、実効性のある契約条件を設定することで、法的保護とリスク管理を強化できます。

CSIRTによるインシデント対応体制の整備

CSIRT(Computer Security Incident Response Team)を設置し、AIツール利用時のセキュリティ事故に対して脆弱性の監視から事故原因の究明、被害拡大の防止まで一元的に対応できる体制を構築します。

Whisper Leak攻撃は隠密性が高く、従来のマルウェア検出ツールでは発見が困難なため、ネットワークトラフィック異常の監視、ファイルダウンロード急増のアラート、業務時間外のアクセスパターン検出などを組み合わせた多層的な監視が必要です。

日本企業のセキュリティ業務におけるAI活用は限定的であり、脅威の迅速な検出にAIを活用することが最優先課題となっています。

ストリーミングとバッチの特性を理解し、会話内容の機密性に応じて運用モードを切り替えることで、不要なメタデータ露出を抑えられます。

SLAにセキュリティ要件を明記することで、対策の持続性とインシデント時の責任範囲を契約上で保証できます。

CSIRTを中心に異常検知やネットワーク監視を多層的に整えることが、潜伏型攻撃への備えになります。

今後の展望と継続的な対策の必要性

攻撃精度の向上可能性と進化する脅威

研究チームは、現時点の結果がリスクの初期水準を示すものであり、攻撃者が学習データを蓄積すれば精度が向上する可能性があると指摘しています。複数回にわたる会話や同一ユーザーの通信パターンを解析することで、攻撃の有効性が増すことも確認されています。

現時点では「ベースラインリスクレベル」ですが、今後さらに悪化する可能性があるため継続した警戒が必要です。マルチターン会話や同一ユーザーの複数会話から得られる豊富なパターンと組み合わせることで、忍耐力とリソースを持つ攻撃者は初期結果よりも高い成功率を達成できます。

AI専用暗号化プロトコルと業界標準の動向

プライバシー保護設計(Privacy by Design)の標準化が進む一方、AI通信向け暗号化プロトコル開発にも注目が集まっています。業界全体でベストプラクティスが共有される動きが加速しており、規制当局による新たなガイドライン策定や、インシデントの報告義務のような法規制の厳格化も視野に入れた対応が求められます。

Microsoftは、Whisper LeakがAIモデル利用における新たなリスクを示す事例と位置付けており、今後のAIサービス開発におけるセキュリティ対策強化の必要性を示しています。

最新情報のキャッチアップとポリシー見直し

最新のセキュリティ情報を定期的にキャッチアップし、ベンダーのセキュリティアップデート状況を継続的に確認することが不可欠です。社内セキュリティポリシーの定期見直しを四半期ごとに実施し、AIベースのデータアナリティクスを活用した継続的な改善プロセスを確立することが重要です。

Whisper Leakは初期水準のリスクであり、今後さらに高度化する可能性があるため、「一度対策すれば終わり」ではなく、継続的な監視と改善が必要です。

AI通信向けの新たな暗号化技術や業界標準の整備が進んでおり、企業は最新動向に追随する姿勢が重要です。

規制強化やベンダーのアップデートも想定し、四半期ごとのポリシー見直しやセキュリティ評価を定常業務として組み込む必要があります。

ベースラインリスクと捉えて油断せず、運用側での監視や改善のサイクルを維持することで、長期的な安全性を確保できます。

よくある質問|Whisper Leakに関する疑問

ChatGPT Enterpriseは安全に使えますか?

ChatGPT Enterpriseは法人向けに設計されたサービスで、ユーザーが入力した情報をAI学習に使用せず、すべての会話データが暗号化されています。

OpenAIはWhisper Leak対策として応答に可変長ランダムテキスト(obfuscationフィールド)を追加する機能を実装済みであり、Microsoftが直接検証した結果、攻撃の有効性が実用的なリスクレベル以下に低減されることが確認されています。公共Wi-Fiなど信頼できないネットワークでの利用は避け、VPN経由でのアクセスを推奨します。

技術的対策が実装されていても、運用面でのセキュリティ意識が重要です。公共Wi-Fiの利用禁止や従業員教育を並行して実施することが効果的です。

オンプレミス型AIなら完全に安全ですか?

オンプレミス型AIソリューションは外部ネットワークを経由しないため、ISPレベルでの傍受リスクは大幅に低減されます。

社内ネットワーク内での傍受リスク(悪意ある従業員や内部ネットワークへの侵入者)は依然として存在するため、アクセス制御、ログ監視、ゼロトラストアーキテクチャなどの内部セキュリティ対策も並行して実施する必要があります。

「完全に安全」なソリューションは存在しないため、多層的な防御戦略が重要となります。オンプレミス型は外部脅威に対する耐性が高い一方、運用コストやスキル要件が高いため、自社の体制と照らし合わせて判断する必要があります。

メール作成などの一般業務でもリスクはありますか?

一般的な業務利用であっても、会話のトピックが推測されることで業務内容や取引先情報が漏洩する可能性があります。

「新規顧客A社との契約書作成」というトピックが推測されれば、競合他社がその情報を利用して先回りする可能性があります。

研究チームは、複数回にわたる会話や同一ユーザーの通信パターンを解析されると、より詳細な情報が推測されるリスクが高まることを確認しています。一般業務でもセンシティブな内容を扱う場合は、VPN経由でのアクセスや非ストリーミングモードの利用を検討すべきです。

中小企業でも対策は必要ですか?

企業規模に関わらず、AI活用する全ての企業が対策を講じるべきです。

中小企業でも新製品開発や顧客情報などのセンシティブな情報を扱う場合、公共Wi-Fiの利用禁止やVPN必須化といった基本的な対策から始め、段階的にDLPやCSIRTの導入を検討することが現実的なアプローチとなります。攻撃者は、中小企業が深いクラウドセキュリティ専門知識を欠くことが多く、IDスプロールやトークン露出がより一般的であることを知っています。

中小企業では「できることから始める」姿勢が重要であり、完璧を目指すよりも、まず基本的な対策を確実に実施することが現実的なアプローチとなります。

今後新たな脅威が発見される可能性はありますか?

Whisper Leakは初期水準のリスクを示すものであり、攻撃者の学習データ蓄積により精度が向上する可能性があります。

研究チームは、攻撃者がより多くの学習データを蓄積することで精度が向上する可能性があると指摘しており、より洗練された攻撃モデルの開発やマルチターン会話の解析により、さらに高い成功率が達成される可能性が示唆されています。

投機的デコーディングなどの効率的な推論技術が導入するタイミングの変動を標的とする新たな手法も登場しており、継続的な情報収集とセキュリティポリシーの見直しが不可欠です。研究チームは「業界は将来のシステムのセキュリティを確保する必要があります」と警鐘を鳴らしており、企業は長期的な視点でセキュリティ投資を計画すべきです。