Llamaの商用利用は可能?ライセンス条件と導入コストをわかりやすく解説

Meta社が開発したオープンソースの大規模言語モデル「Llama」は、月間アクティブユーザー(関連会社含む)7億人未満なら無償で商用利用できるという画期的なライセンス条件により、国内外のビジネスシーンで急速に注目を集めています。

しかし「本当に無料で使えるのか?」「ライセンス違反のリスクは?」「日本語対応は十分か?」「導入コストはどれくらいかかるのか?」といった疑問を抱える企業担当者も少なくありません。

本記事では、Llamaの商用利用におけるライセンス条件の詳細から、GPT-4やChatGPT Enterpriseとの料金比較、日本語ビジネスでの実用性、具体的な導入方法とコスト試算まで、AI活用を検討する企業が知るべき情報を網羅的に解説します。

- Llamaの商用利用ライセンス条件の詳細

- GPT-4やChatGPT Enterpriseとの料金比較とコストメリット

- 日本語ビジネスでの実用性と日本語強化版モデルの性能比較

- 非エンジニアからエンジニアまで対応した具体的な導入方法

- リコーやSmartly社など国内外企業の実際の活用事例

Llamaがビジネスシーンで選ばれる理由とは?

Metaが開発したオープンソースの大規模言語モデル

LlamaはMeta Platforms社が開発したオープンソースの大規模言語モデルで、2024年9月にリリースされたLlama 3.2では画像とテキストを同時処理できるマルチモーダル機能が追加されました。従来のテキスト生成だけでなく、文書内のグラフや図表を読み取って説明文を生成する、商品画像から仕様を抽出するといった業務が可能になります。

金融機関では生成AIアシスタントを業務に導入し、機密データを社内で処理する体制を整えています。オープンソースの特性上、企業は自社の業務要件に応じてモデルをカスタマイズでき、外部APIへのデータ送信リスクを回避しつつ高度なAI活用を実現できる点が選ばれる理由です。Llamaは自社サーバーでの運用に適したモデルとして注目されています。

商用利用可能で月間7億ユーザー未満なら無償

Llamaの最大の特徴は、月間アクティブユーザー(MAU)が7億人未満(関連会社含む)であればライセンス料無料で商用利用できることです。多くの企業がこの条件下で社内AIシステムや顧客向けサービスの基盤として採用し、ライセンスコストゼロでの運用を実現しています。

スタートアップや中小企業にとって、初期投資を抑えながらエンタープライズグレードのAIを導入できる環境が整っている点は大きな魅力です。7億MAU以上の大規模サービスではMetaへの個別ライセンス申請が必要ですが、ほとんどの企業はこの条件を満たすため無償利用の範囲内で事業展開できます。

GPT-4やClaudeとの性能の差とコスト優位性

企業によるAPI利用からオンプレミス運用への切り替え事例では、大幅なコスト削減が報告されています。

自社サーバーでの運用により、外部API呼び出しのレイテンシを回避できるため、処理速度の向上やレスポンスタイムの短縮が期待できます。エンタープライズ向けRAGシステムでも採用が進んでいます。

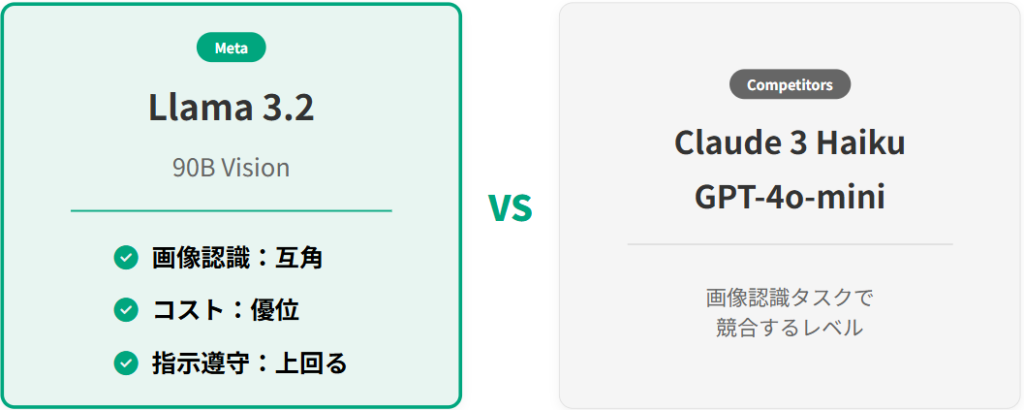

- Llama 3.2 90Bビジョンモデルは画像認識タスクでClaude 3 HaikuやGPT-4o-miniと競合するレベル

- 指示の遵守や要約ではGemma 2やPhi 3.5-miniを上回る結果

- 大量の推論処理が必要な業務ではコストと性能のバランスで優位

ReAlice株式会社 AIコンサルタント

ReAlice株式会社 AIコンサルタントLlamaが企業で選ばれる背景には、オープンソースによる柔軟さと、オンプレミス運用で機密情報を社外に出さずに処理できる安心感があります。7億MAU未満なら商用利用が無償という条件も、導入のハードルを大きく下げています。さらに、最新モデルは画像とテキストを統合的に扱え、特定業務向けのカスタマイズもしやすく、外部APIに依存しないためコストと応答速度の最適化が可能です。

商用利用のライセンス条件を正しく理解しよう

月間アクティブユーザー7億人未満は無償で利用可能

Meta Llama 3 Community Licenseでは、月間アクティブユーザー数が7億人未満の場合、追加のライセンス料なしで商用利用が認められています。この条件により、個人開発者から中堅企業まで幅広い事業者がLlamaを自社製品やサービスに組み込むことができます。

ライセンスはソフトウェアやコードの商用利用を明示的に許可しており、SaaSプラットフォームの開発やモバイルアプリへの組み込みも対象です。

7億人以上の場合はMetaへのライセンス申請が必要

月間アクティブユーザーが7億人を超える場合、Metaへの個別ライセンス申請が義務付けられます。ライセンス契約では「ライセンシーまたはその関連会社によって提供される製品・サービスの月間アクティブユーザー数が直前の暦月において7億人を超える場合、Metaからのライセンスを要求しなければならない」と規定されています。

この制限は単一サービスのMAUではなく、企業グループ全体の合算値が対象となるため、複数サービスを展開する大企業は注意が必要です。Metaは独自の裁量でライセンスを付与する権限を持ち、許諾が得られない場合は使用できません。

商標使用と著作権表示の義務

Llamaマテリアルを使用した製品やサービスを配布する際は、「Built with Llama」という表示をWebサイト、ユーザーインターフェース、製品ドキュメントに明示する義務があります。

Llamaマテリアルの出力や結果を用いてAIモデルを作成・配布する場合、モデル名の先頭に「Llama」を含める必要があります。

- Webサイトやユーザーインターフェースに「Built with Llama」を表示

- 派生モデル名の先頭に「Llama」を含める

- 著作権表示「Llama 3.1はLlama 3.1 コミュニティライセンス契約の下でライセンスされています。Copyright © Meta Platforms, Inc. All Rights Reserved.」を全コピーに保持

利用規定で禁止されている行為

Llama利用規約(Acceptable Use Policy)は、違法行為や有害コンテンツの生成、個人への危害をもたらす活動への利用を厳格に禁止しています。禁止事項には、暴力・テロ行為の促進、児童搾取的コンテンツの生成、人身売買、詐欺行為、スパムの大量生成、差別の助長などが含まれます。

また、適用法規および貿易コンプライアンス法の遵守が契約に組み込まれており、違反時はMetaが契約を即座に終了できる条項が設けられています。

競合AI開発への利用制限

Llama 3のライセンス契約には、その成果物を利用して他の大規模言語モデルを改良することが明確に禁止されています。また、利用規約では「違法なコンテンツの生成、違法または有害な行為を目的として設計された第三者のツール・モデル・ソフトウェアと相互作用すること」も禁じられています。

Metaはこの条項により、自社の競争優位性を守りながら、エコシステムの健全性を維持する狙いがあります。

違法行為や有害コンテンツ生成の禁止

利用規約では、児童性的虐待的コンテンツ、暴力の扇動、健康・法律・金融などの無許可専門業務、マルウェアの作成、個人情報の無断収集が明確に禁止されています。

AIシステムに存在する既知の危険性をエンドユーザーに適切に開示しない行為も違反とされ、企業は常にコンプライアンス体制を整える必要があります。違反が確認された場合、Metaの裁量による即時契約終了が可能であり、法的責任も発生するリスクがあります。

Llamaの商用利用は、MAUの閾値や商標表示など独特の条件が設定されており、企業はライセンス条項の正確な理解が不可欠です。7億MAU未満であれば無償という大きな利点がある一方で、「Built with Llama」の表示義務や派生モデルの命名規則など、運用面で遵守すべき要件が細かく定められています。また、違法行為・有害コンテンツ生成の禁止、競合モデルの開発利用制限といった規定は、エコシステムの健全性確保を目的としており、違反時には契約終了のリスクも伴います。

Llama 3.2とバージョン別の特徴

Llama 3.2の新機能|画像認識対応のマルチモーダルモデル

Llama 3.2は2024年9月に発表されたMetaの最新モデルで、テキストと画像を同時に処理できるマルチモーダル機能が初めて搭載されました。

11Bおよび90Bパラメータのビジョンモデルは、画像の内容説明、視覚的な質問応答、文書内のチャートやグラフの解析が可能です。128Kトークンという長いコンテキスト長をサポートしており、画像を含む複数ターンの会話も実現できます。

- 製造業の品質検査:不良品画像を読み込んで原因を分析

- 小売業:商品画像から仕様を自動抽出

- エッジ環境:1Bおよび3Bの軽量テキストモデルでスマートフォンやIoTデバイスでの実行

視覚情報が業務の中核を占める領域で、Llama 3.2のマルチモーダル機能が大きな効果を発揮します。

Llama 3.1|4050億パラメータの大規模モデル

Llama 3.1は4050億パラメータという大規模構成を持ち、高度な推論能力と128Kトークンの長文処理能力を備えています。法務文書の分析、技術仕様書の要約、膨大な顧客データからのインサイト抽出など、複雑で大規模な情報処理が求められる業務に適しています。

Together.AIやAWS経由でのAPI利用では、入力トークンが100万あたり5.00ドル、出力トークンが16.00ドルという価格設定となっており、GPT-4と比較してコストを大幅に削減できます。大量の文書を扱う法律事務所や、詳細な技術マニュアルを作成する製造業での採用事例が増えています。

ビジネス用途に合わせたモデルを選ぶ

ビジネスでLlamaを活用する際は、業務要件に応じた適切なモデル選択が成功の鍵です。汎用的なチャットボットや文書生成には8Bまたは70Bのテキストモデルが適しており、導入コストと性能のバランスが良好です。

画像認識が必要な業務では11Bまたは90Bのマルチモーダルモデルを選択し、モバイルアプリやIoTデバイスでの利用には1Bまたは3Bの軽量モデルが最適です。

まず8Bモデルで業務適合性を検証し、初期投資を抑える

段階的な検証により、小規模モデルで業務適合性を確認後、日本語強化版の70Bモデルなど大規模モデルへ移行

実用性を段階的に検証し、失敗リスクを最小化

Llama 3.2はマルチモーダル対応により、従来のテキスト中心の活用から「画像を含む業務プロセス全体」を対象にできる点が大きな進化です。

一方でLlama 3.1の大規模モデルは、長文・大量データの解析コストを抑えつつ高い推論性能を発揮できるため、法務・製造など情報量の多い業種と相性が良いです。

ビジネスでの導入方法とは

非エンジニア向けの簡単な始め方

技術的な知識が限られている場合でも、ブラウザベースのプラットフォームを利用すればLlamaの性能を手軽に体験できます。

GroqやPerplexity AI Labsでブラウザから利用

Groqは超高速処理を特徴とするブラウザベースのLlama実行環境で、アカウント登録だけで即座に利用開始できます。Perplexity AI Labsも無料のお試し環境を提供しており、非エンジニアでも直感的なインターフェースでLlamaの機能を確認可能です。

これらのプラットフォームは導入前の性能評価や社内デモに最適で、実際のビジネスシーンでどのように機能するかを低リスクで検証できます。業務適合性を確認した上で本格導入を検討する流れが、失敗を防ぐ効果的なアプローチです。

エンジニア向けの本格導入

開発チームを持つ企業では、より柔軟なカスタマイズと高度な統合が可能な導入方法を選択できます。

Hugging Faceからのモデル取得

Hugging FaceはLlamaモデルの公式配布先として、Meta公認のダウンロードプラットフォームです。利用者はHugging Faceにログインし、Llamaモデルページでユーザー情報を入力してライセンス条項に同意することで、モデルファイルをダウンロードできます。取得したモデルは自社サーバーで運用することで、データの完全な制御権を維持しながら活用可能です。

東京工業大学はこの方法でLlama 3.1をベースにした日本語対応モデル「Llama-3.1-Swallow-8B-Instruct-v0.3」を開発し、日本語MT-Benchで最高水準の性能を実現しています。

Amazon Bedrock経由の企業導入

Amazon BedrockはAWSが提供するマネージドサービスで、Llamaモデルを企業のクラウド環境に統合する際の有力な選択肢です。Bedrockを利用することで、インフラ管理の負担を軽減しながら、エンタープライズグレードのセキュリティとスケーラビリティを確保できます。

AWSの既存サービスとのシームレスな連携により、データレイクやビジネスインテリジェンスツールとの統合も容易です。使用量に応じた従量課金制であるため、需要の変動が大きい業務にも柔軟に対応できます。

API利用の料金体系とコスト試算

API経由でLlamaを利用する場合、トークン数に基づく従量課金制が一般的です。

入力・出力トークンごとの料金

Llama 3.1のAPI料金は、入力トークンが100万トークンあたり5.00ドル、出力トークンが100万トークンあたり16.00ドルです。

Together.AIやFireworks.aiなどのプロバイダー経由では、Llama 3.1 70Bモデルが入力・出力ともに0.00088ドル/1Kトークンとさらに低コストで利用できます。

1日100回の処理(1回あたり入力4,000トークン、出力2,000トークン)を実施する場合

- API利用料金に大きな差が生まれる

- GPT-4と比較してLlamaは大幅にコストを削減できるため、業務量と処理内容を正確に把握し、複数のプロバイダーの料金を比較することが重要

業務量と処理内容を正確に把握し、複数のプロバイダーの料金を比較した上で最もコストパフォーマンスの高い選択を行うことが重要です。

Llamaの導入は、非エンジニアでもブラウザ環境から手軽に試せる点と、エンジニア向けにはオンプレミス運用やAWS統合など高度な選択肢が揃っている点が特徴です。GroqやPerplexityでの事前評価は低リスクで性能を体験でき、Hugging Face経由でモデルを取得すれば自社要件に応じたカスタマイズが可能になります。Bedrockのようなマネージド環境は、セキュリティと運用負荷のバランスを取りたい企業に適した手段です。

日本語ビジネスでの実用性

公式Llamaの日本語対応状況と課題について

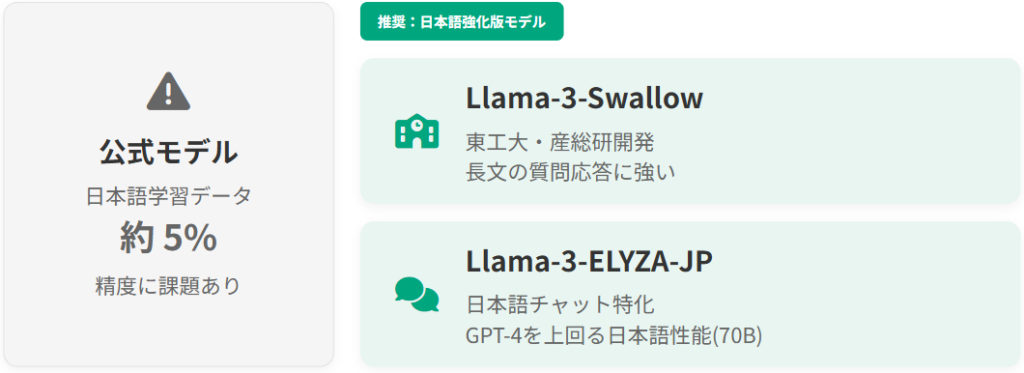

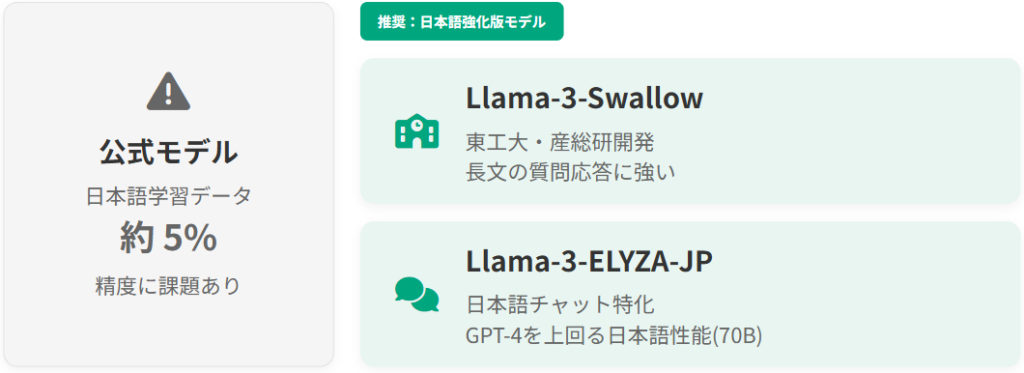

公式のLlamaモデルは、日本語の学習データが全体の約5%と限定的であるため、日本語での実用性には課題があります。英語を中心に学習されたモデルであり、日本語特有の表現や文脈理解において精度が低下する傾向があります。

ビジネス文書の生成や複雑な質問応答では、期待する品質が得られない場合も少なくありません。日本語業務で活用するには、日本語強化版モデルの採用が現実的な選択肢となります。

日本語強化版モデルの比較

国内の研究機関や企業が日本語性能を強化したLlama派生モデルを開発しており、実用レベルの精度を実現しています。

Llama-3-Swallow(東工大・産総研)

Swallowは東京工業大学と産業技術総合研究所が共同開発した日本語特化モデルで、Llama 3をベースに日本語の継続事前学習を実施しています。日本語理解・生成タスクにおいてオープンなLLMの中でトップクラスの性能を持ち、元のLlama 3と比較して大幅な改善を実現しています。

特に長文の質問応答や簡潔な回答生成において優れた性能を発揮し、コンテキスト長が2,000~3,000文字以上の業務に適しています。金融業務や技術文書の処理など、高度な日本語理解が求められる業務での活用が進んでおり、複数の企業が独自のカスタマイズを行っています。

Llama-3-ELYZA-JP(ELYZA)

ELYZAが開発したLlama-3-ELYZA-JPは、日本語のチャット対応に特化したモデルです。8Bモデルでも実用的な日本語性能を発揮し、70Bモデルでは多くのタスクでGPT-4を上回る日本語性能を示します。ビジネス向けのチャットボットや顧客対応システムに特に有効です。

ELYZAモデルは日本語の語彙を追加して事前学習を行っており、効率的なトークン化を実現しています。日本語特有の表現や文脈理解に優れており、ビジネス向けのチャットボットや顧客対応システムに特に有効です。

日本企業での活用事例を紹介

リコーは、Llamaを基盤としたAI活用支援を積極的に展開しています。同社はモデルマージ技術を駆使して日本語能力を向上させた大規模言語モデルを開発し、顧客サポートや業務効率化に活用しています。

リコージャパンは「RICOH オンプレLLMスターターキット」の提供を開始し、高セキュリティなオンプレミス環境でGPT-4相当の高性能日本語LLMを標準搭載しています。Smartly社(デジタル広告プラットフォーム企業)は、Llama 3を顧客サポート業務に導入し、チケット作成時間を約80%削減、解決メッセージ作成時間を半減させることに成功しました。

オープンソースであるLlamaを自社のKubernetes環境上で運用することで、データセキュリティを確保しながら顧客満足度とサポートスタッフの士気向上を実現しています。

これらの事例から、日本語対応の工夫とオンプレミス運用によるセキュリティ確保が、ビジネス成功の鍵であることがわかります。

Llamaは公式版の日本語学習量が限られるため、そのままでは高度な日本語業務には十分対応しきれない点が課題になります。一方で、SwallowやELYZA-JPといった日本語特化モデルは、大量の追加学習と語彙最適化により、実務レベルの精度を確保しており、長文処理からチャット対応まで幅広いビジネス用途で実績を示しています。

導入コストとROIの試算

必要なGPUスペックとクラウド費用

Llamaをオンプレミスで運用する場合、モデルサイズに応じたGPU環境が必要です。Llama 3 70Bモデルは高性能GPUを必要とし、初期投資としてGPUサーバー構築費用が発生しますが、月間の運用コストは固定費(電気代・メンテナンス費用)のみで済みます。

クラウド環境では、モデルデプロイの初期コストは低いものの、使用量が増加するほどAPI利用料が膨らむ従量課金制となります。処理回数が一定の閾値を超える場合、初期投資を考慮してもオンプレミス運用の方がトータルコストで有利になるケースが多くあります。

ChatGPT Enterpriseとのコスト比較

ChatGPT Enterpriseとのコスト比較では、Llamaの優位性が明確です。クラウド型のGPT-4 Turboは使用量に応じて高額な費用が発生します。一方、Llama 3 70Bをローカル環境で運用すれば、初期投資後は固定費のみで大幅なコスト削減が実現できます。

API経由で利用する場合でも、LlamaはGPT-4と比較して低価格で実行可能です。使用量が多い企業では、年間で大幅なコスト削減が見込めます。

自社環境構築 vs API利用の判断基準

自社環境構築とAPI利用の選択は、業務規模とセキュリティ要件によって判断すべきです。

オンプレミス構築は初期コストが高く、GPUサーバー購入とメンテナンス体制の整備が必要ですが、月額コストは固定費のみで済み、データの完全な制御が可能です。API利用は初期投資なしで開始でき、需要の変動に柔軟に対応できますが、使用量が増えるとコストが膨らみます。

実務での推奨は、PoC段階ではAPI利用で検証を行い、処理回数が増加した時点で自社環境構築へ移行する段階的アプローチです。特に医療・金融など高度なデータ保護が求められる業界では、初期段階からオンプレミス運用を検討すべきです。

大量処理を想定する場合、初期投資は発生してもGPU環境を自前で持つ方が長期的には費用を抑えやすく、データ管理面でも優位です。一方で、小規模利用やPoCでは従量課金のAPIが柔軟で、段階的な移行戦略が理にかないます。ChatGPT Enterpriseとの比較でも、Llamaは運用形態を選べるため、性能を維持しつつコスト最適化を図りやすい点が特徴です。業務量・セキュリティ要件・将来の拡張性を踏まえて最適な運用モデルを選ぶことが、ROIを最大化する鍵となります。

業種別の活用シーンと導入ステップ

カスタマーサポート自動化での活用

Llamaはカスタマーサポート業務の自動化に大きな効果を発揮します。

Smartly社の事例では、Llama 3を導入してチケット作成時間を80%削減し、解決メッセージ作成時間を半減させました。同社はオープンソースのLlamaを自社のKubernetes環境で運用することで、顧客データのセキュリティを確保しながら、サポートスタッフの士気向上と顧客満足度の改善を同時に達成しています。

実務においては、FAQの自動応答から始め、段階的に複雑な問い合わせ対応へ拡張していく導入戦略が効果的です。

マーケティングコンテンツ生成での活用

Llamaは広告コピー、SNS投稿、ブログ記事などのマーケティングコンテンツ生成に活用できます。特に多言語展開が必要な企業では、英語で生成したコンテンツをSwallowやELYZAなどの日本語強化版モデルで翻訳・リライトすることで、効率的なローカライゼーションが可能です。

Llamaの128Kトークンという長いコンテキスト長を活かせば、ブランドガイドラインや過去の成功事例を参照しながら、一貫性のあるコンテンツを大量生成できます。ECサイトの商品説明文生成、技術文書の作成、多言語コンテンツの展開など、幅広い用途で活用が進んでいます。

社内ナレッジ管理とRAG構築

Llamaは社内文書の検索・要約を行うRAG(Retrieval-Augmented Generation)システムの構築に適しています。オンプレミスで運用できる特性により、機密性の高い社内情報を外部サービスに送信せずに活用できます。

リコーが提供する「RICOH オンプレLLMスターターキット」は、GPT-4相当の高性能日本語LLMを標準搭載し、高セキュリティ環境での社内ナレッジ管理を実現しています。法務・人事・技術文書など部門ごとにRAGシステムを構築することで、従業員の情報アクセス効率を向上させ、業務時間を大幅に削減できます。

導入前のチェックリスト

Llama導入を成功させるには、以下のポイントを事前に確認すべきです。

- 月間アクティブユーザー数が7億人未満であることを確認し、ライセンス条件を満たしているか検証

- 業務要件に適したモデルサイズ(8B、70B、405B)を選定し、必要なGPUスペックとコストを試算

- 日本語を主に使用する場合は、SwallowやELYZAなどの日本語強化版モデルの採用を検討

- セキュリティ要件が高い業務では、オンプレミス運用を前提とした環境構築計画を立てる

- 利用規約で禁止されている行為に該当しないか、社内のガバナンス体制を整備

カスタマーサポートではKubernetes上での運用事例に見られるように、セキュリティを担保しつつ大幅な省力化が実現できます。マーケティング領域では長文処理と多言語対応により、ブランド一貫性を保ちながら大量生成が可能です。RAGではオンプレ運用のメリットが際立ち、高度な機密性が要求される部門でも安全に導入できます。

セキュリティとコンプライアンス対策

オンプレミスとクラウドのデータ管理

Llamaのデータ管理方式は、オンプレミスとクラウドで大きく異なります。

オンプレミス運用では、Hugging Faceからモデルをダウンロードして自社サーバーで実行するため、すべてのデータが社内に留まり、外部への送信リスクがありません。リコーやSmart社の事例のように、機密性の高い顧客データを扱う企業では、この方式が推奨されます。

クラウドAPI利用では、入力データがサービスプロバイダーのサーバーへ送信されるため、データ処理契約やプライバシーポリシーの確認が必須です。データの機密度レベルに応じて運用方式を選択し、高機密データはオンプレミス、一般的な業務はクラウドAPIという使い分けが実務的です。

個人情報保護法・GDPRへの対応

Llamaを利用する際は、日本の個人情報保護法やEUのGDPRなど、各国のデータ保護規制への対応が不可欠です。Llama利用規約のセクション1.e.では、「適用される法律で要求される権利および同意なしに、個人に関する健康、人口統計情報、またはその他の機密性の高い個人情報やプライバシー情報を収集、処理、開示、生成、または推測すること」が禁止されています。

特に注目すべきは、Llama 3.2のマルチモーダルモデルについて、EU市民および主たる事業所をEUに置く企業には使用権限が付与されないという制限です。日本企業でも、EU顧客向けサービスを提供する場合は、この制限を考慮した導入計画が必要です。

エンドユーザーへのAI利用開示義務

Llamaライセンス契約では、AIシステムに存在する既知の危険性をエンドユーザーに適切に開示する義務が明記されています。また、利用規約のセクション3.e.には「Llama 3.2の使用または出力が人間による生成であると表明すること」が禁止行為として挙げられています。

つまり、Llamaを使用したサービスでは、ユーザーに対してAIが生成したコンテンツであることを明示する必要があります。サービス利用規約にAI使用の事実を記載し、生成コンテンツに「AI生成」の表示を付けるなど、透明性の高い運用体制を構築することが法的リスクを軽減しながらユーザーからの信頼を獲得する鍵となります。

Llamaの運用形態はセキュリティ要件に大きく影響し、データが社外へ出ないオンプレ方式は高機密領域で特に有効です。一方でクラウドAPI利用では、契約内容やデータ保護規制の確認が不可欠で、取り扱う情報の性質に応じた使い分けが重要になります。加えて、個人情報保護法やGDPRに基づく利用制限、特にEU向けのマルチモーダル提供制約は導入計画時の盲点になりがちです。

よくある質問|Llamaの商用利用について

Llamaは完全無料で商用利用できますか?

Llamaは月間アクティブユーザー数が7億人未満であれば、ライセンス料無料で商用利用できます。ただし、モデルを自社環境で運用する場合はGPUサーバーの費用が、API経由で利用する場合はトークン単位の利用料が発生します。

「無料」とは「ライセンス料が無料」という意味であり、インフラコストや運用コストは別途必要です。

月間7億ユーザーの計算方法は?

月間7億ユーザーの計算は、ライセンシー企業およびその関連会社(50%以上の資本関係で繋がる企業群)が提供する全製品・サービスの合算MAUで判定されます。

例えば、親会社と複数の子会社がそれぞれ異なるサービスを運営している場合、各サービスのMAUを合算した数値が対象です。重複ユーザーの扱いについては明確な定義がありませんが、Meta社自身が各サービスのMAUを単純合算せず重複を排除した数値を公表していることから、合理的な方法で重複を省くことが妥当と考えられます。

日本語での実用性はどの程度ですか?

公式Llamaの日本語実用性は限定的ですが、SwallowやELYZAなどの日本語強化版モデルを使用することで、ビジネスレベルの精度が得られます。Swallow-70Bは日本語理解・生成タスクでトップクラスの性能を持ち、長文の質問応答に優れています。

ELYZA-70BはGPT-4を上回る日本語性能を示すケースもあります。リコーやSmartly社の導入事例のように、適切なモデル選択とファインチューニングにより、日本企業でも十分に実用的な成果が得られます。

GPT-4と比較してコストメリットはありますか?

LlamaはGPT-4と比較して圧倒的なコストメリットがあります。Llama 3.1 70BのAPI利用では入力・出力合計で0.00088ドル/1Kトークンと、GPT-4と比較して大幅に低コストです。

処理回数が多い企業では、API利用でも大幅なコスト削減が可能です。さらにオンプレミス運用では、初期投資後は固定費のみで運用できるため、使用量が多いほどコストメリットが大きくなります。年間で大幅なコスト削減が見込めます。

ライセンス違反した場合のリスクは?

Llamaのライセンス違反が発覚した場合、Metaは独自の裁量で即座に契約を終了する権限を持っています。契約終了後は、すべてのLlamaマテリアルを削除し使用を中止する義務が発生します。また、利用規約違反によって第三者に損害が発生した場合、ライセンシーはMetaを免責する義務があり、損害賠償責任を負う可能性があります。

さらに、Llamaライセンス契約はカリフォルニア州法に準拠しており、訴訟となった場合は米国法に基づいた判断がなされます。ライセンス違反を防ぐには、社内にコンプライアンス体制を構築し、利用規約の更新を定期的に監視することが不可欠です。