Microsoft 365 Copilot情報漏洩の実態|3大リスクと6つの対策で安全導入

「Microsoft 365 Copilotを導入したいけれど、情報漏洩が心配…」そんな不安を抱えていませんか?実際に2025年には深刻な脆弱性「EchoLeak」が発見され、過去にはサムスン電子でChatGPTへの誤入力による社内情報の流出事件も発生しています。企業のIT担当者や経営層が最も懸念するのが、機密情報の漏洩リスクです。

しかし、正しい知識と対策があれば、Microsoft 365 Copilotの情報漏洩リスクは十分に管理できます。この記事では、企業が直面する3つの情報漏洩パターン、2025年に発見された最新の脆弱性情報、実際の事例から学ぶ教訓、安全に導入するための6つの具体的な対策を解説します。法人向けと個人向けプランのセキュリティレベルの違い、アクセス権限管理の徹底方法、業界別の規制への対応まで、導入判断に必要な情報を網羅しています。

この記事を読めば、あなたの会社がMicrosoft 365 Copilotを安全に導入できるかどうかを判断でき、必要な対策を即座に実行できるようになります。情報漏洩への不安を解消し、AIを活用した業務効率化を実現しましょう。

- Microsoft 365 Copilotで情報漏洩が起こる3つの具体的なパターンと、企業が陥りやすい失敗事例

- 2025年に発見された深刻な脆弱性「EchoLeak(CVE-2025-32711)」の危険度と対策状況

- 法人向けと無料版・個人向けプランのセキュリティレベルの決定的な違いと選び方

- アクセス権限管理、データ暗号化、社員教育など、企業が実施すべき6つの実践的セキュリティ対策

- 導入前にチェックすべき技術面・法務面・運用面の判断基準と、業界別の規制対応

Microsoft 365 Copilotで情報漏洩は起こるのか?

Microsoft 365 Copilotの導入を検討する企業にとって、情報漏洩リスクは最大の懸念事項でしょう。結論から述べると、適切な設定と運用体制を整えれば情報漏洩リスクは十分に管理できます。

ただし、誤った使い方や設定の不備によって機密情報が流出する可能性はゼロではありません。特に2025年には深刻な脆弱性「EchoLeak」も発見されており、正しいリスク理解と対策の実施が欠かせません。

Microsoftが公表するセキュリティ体制の実態

Microsoft 365 CopilotはMicrosoft Graphを経由し、ユーザーのアクセス権限を厳格に管理する設計を採用しています。データは保存時・通信時ともに暗号化され、Zero Trustモデルに基づくセキュリティ基準を満たしています。

GDPR、ISO 27001、HIPAAといった国際的なセキュリティ規格にも準拠しており、エンタープライズ企業が求めるコンプライアンス要件をクリアしています。一般公開されているOpenAIサービスとは異なり、Azure OpenAIサービスを使用した独立環境で動作する点も見逃せません。

法人向けと個人向けプランのセキュリティレベルの違い

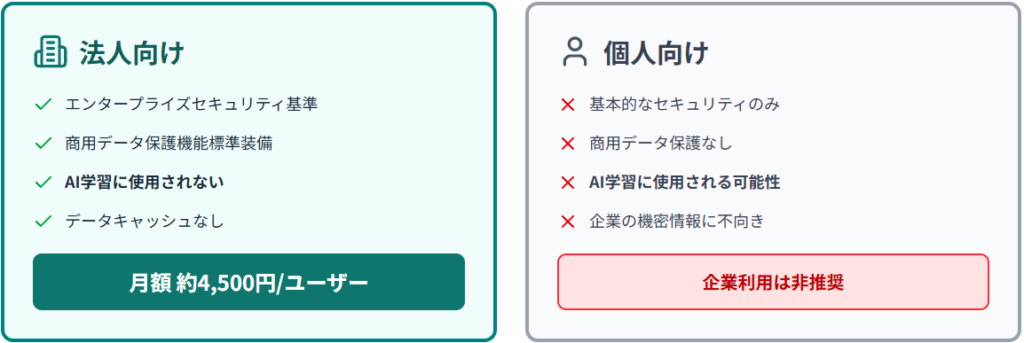

法人向けMicrosoft 365 CopilotとCopilot Pro(個人向け)では、セキュリティレベルに決定的な差があります。法人向けプランはMicrosoft 365のエンタープライズセキュリティ基準を継承し、商用データ保護機能を標準装備しているため、入力データがAIモデルの学習に使われることはありません。

対照的に、無料版CopilotやCopilot Proでは、入力データがAIモデルの改善目的で使用される可能性があり、企業の機密情報を扱う用途には不向きです。法人向けプランは1ユーザー月額約4,500円というコストが発生しますが、セキュリティ要件を満たす上で譲れない選択肢と言えます。

入力データはAI学習に使われるのか

Microsoft 365 Copilot(法人向け)において、入力したデータや会話履歴がAIモデルの学習に利用されることはありません。Microsoftは公式に「顧客コンテンツはキャッシュされない」と明言しており、商用データ保護機能によって情報漏洩のリスクを最小化しています。

ただし、この保証は法人向けプランに限定されます。無料版や個人向けProプランではAI学習にデータが使われる可能性があるため、必ず法人向けプランを選択してください。クラウド環境での処理という特性上、暗号化やアクセス権限の適切な設定が情報保護の要となります。

ReAlice株式会社 AIコンサルタント

ReAlice株式会社 AIコンサルタントMicrosoft 365 Copilotは、設計段階からエンタープライズ向けの堅牢なセキュリティモデルを採用しており、適切な設定を行えば情報漏洩リスクは極めて低く抑えられます。特に法人向けプランでは、データがAI学習に利用されない仕組みが保証されており、商用利用において高い安全性を確保しています。ただし、個人向けプランではデータ利用範囲が異なるため、運用環境の選定と権限設定の徹底が重要です。

企業が直面する3つの情報漏洩パターン

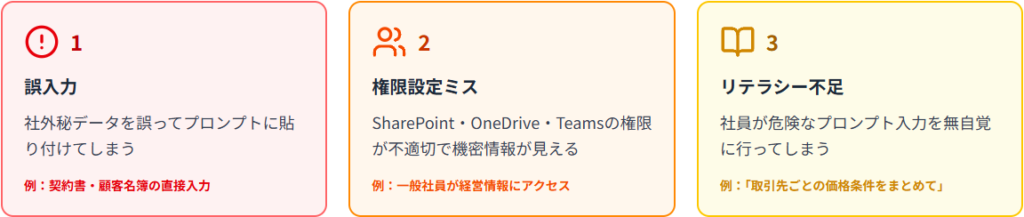

前述のセキュリティ体制が整っていても、実際の運用場面では3つの情報漏洩パターンに直面するリスクが存在します。

これらのパターンを事前に把握し、具体的な対策を講じることが安全な運用の第一歩です。

社外秘データを誤って入力してしまうケース

最も頻繁に発生するのが、社員が社外秘情報を直接プロンプトに貼り付けてしまうパターンです。顧客名簿や契約書の一部を貼り付けて要約を依頼するケースが典型例でしょう。

Copilot自体は入力データを学習に使用しませんが、クラウド経由で処理される以上、適切な運用がなければ情報漏洩のリスクは完全にはゼロにできません。

- 営業部門:「この契約書を要約して」と機密文書を丸ごと入力

- 法務部門:「この秘密保持契約の要点をまとめて」と契約内容を貼り付け

- 人事部門:「この候補者の履歴書を分析して」と個人情報を直接入力

AIコンサルタントの視点から言えば、プロンプト設計の段階で機密情報を抽象化・マスキングする訓練が不可欠です。

アクセス権限の設定ミスで機密情報が見える状態に

SharePoint、OneDrive、Teamsの権限設定が適切でないと、本来アクセスできない社員にまで機密情報が参照されてしまう危険性があります。

セキュリティ専門家の解説では、一般社員であるユーザーAが本来アクセスできない「経営に関わる重要な情報」に、過剰なアクセス権が付与されているためCopilot経由で到達してしまう具体例が紹介されています。

さらに、経営幹部が誤って(またはソーシャルエンジニアリング攻撃により)機密ファイルを一般社員フォルダにコピーしてしまうと、フォルダ単位のアクセス制御だけでは防げないリスクも指摘されています。権限管理体制が未整備の中小企業では特に注意が必要です。

社員のリテラシー不足による危険な使い方

Copilotは自然言語で操作できるため、ITリテラシーの低い社員でも簡単に使い始められます。この利便性の高さは、同時に危険なプロンプト入力への無自覚な踏み込みを招くリスクも孕んでいます。「取引先ごとの価格条件をまとめて」と指示すれば、営業機密が意図せず抽出される可能性があるでしょう。

社内ガイドラインの整備や教育が不十分なまま導入すると、「便利だから」という理由だけで機密情報を安易に入力してしまう事例が多発します。私が企業支援で繰り返し強調しているのは、「技術的な制限だけでなく、社員の意識改革こそが最大の防御壁」という点です。

システムの脆弱性よりも「人の操作」に起因するケースが圧倒的に多い点を理解すべきです。特に、誤入力・権限設定ミス・教育不足という三つの要因は、技術的対策だけでは防ぎきれません。プロンプト段階での情報抽象化、アクセス制御の定期監査、社員研修の三本柱を組み合わせることで実運用上のリスクを大幅に低減できます。

2025年に発見された深刻な脆弱性EchoLeakとは

前述の運用上のリスクに加えて、2025年1月にはMicrosoft 365 Copilotの深刻な脆弱性「EchoLeak」が発見され、セキュリティ業界に大きな衝撃を与えました。

この脆弱性は、AIエージェントに関連して初めて公に知られたゼロクリック攻撃として注目を集めています。

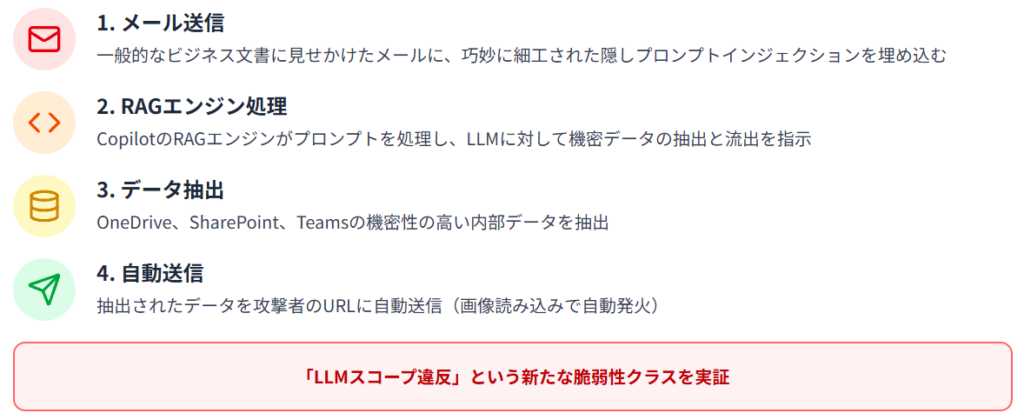

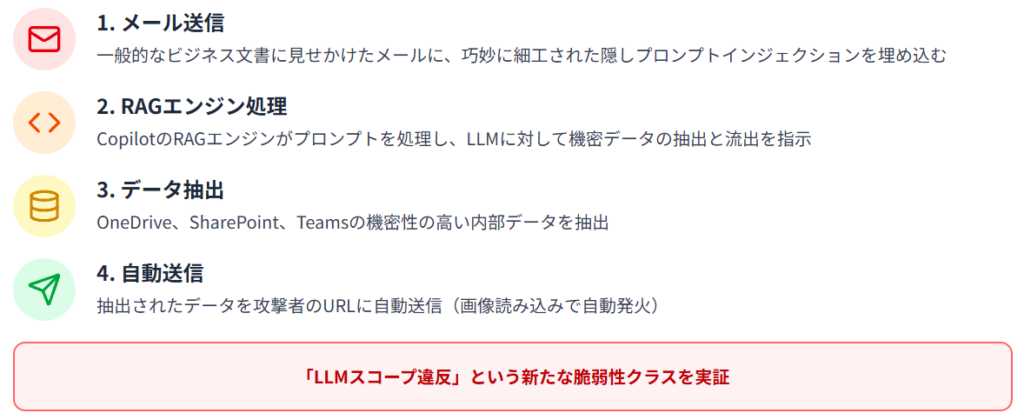

ゼロクリック攻撃を可能にした仕組み

EchoLeakの最大の特徴は、ユーザーの操作を一切必要とせず、メールを送るだけで攻撃が成立する点にあります。攻撃者はCopilotとは無関係のテキストを含む一般的なビジネス文書に見せかけたメールを送信し、その中に巧妙に細工された隠しプロンプトインジェクションを埋め込みます。

このプロンプトがCopilotのRAGエンジンによって処理されると、LLMに対して機密性の高い内部データ(OneDrive、SharePoint、Teamsの情報)の抽出と流出を指示してしまいます。抽出されたデータは攻撃者が用意したURLに自動送信され、画像読み込みで自動発火する仕組みです。

この攻撃は「LLMスコープ違反」と呼ばれる新たな脆弱性クラスを実証し、LLMがユーザーの意図や操作なしに内部の特権データを漏洩させる可能性を示しました。

CVE-2025-32711の危険度と対策状況

EchoLeakには識別番号CVE-2025-32711が割り当てられ、Microsoftは深刻度を「Critical(重大)」と評価しました。

セキュリティ企業Aim Securityの研究者が2025年1月にこの攻撃手法を考案してMicrosoftに報告したところ、Microsoftは即座に対応しました。2025年5月にはサーバー側で修正が完了しており、ユーザーが緩和策を適用する必要はありません。実際の攻撃で悪用された証拠も確認されておらず、影響を受ける顧客はいないと考えられています。

ただし、この脆弱性は従来のセキュリティ欠陥とAI特有の脆弱性を組み合わせたものであり、多くのRAGシステムやAIエージェントに存在するシステム設計の弱点を批判的に強調しています。

- CVSSv3.1スコア:9.3(重大)

- Microsoftの対応:2025年5月にサーバー側で修正完了

- ユーザー側の対応:不要(すでに修正済み)

- 実際の悪用:確認されていない

あなたの会社は影響を受けているのか

EchoLeakはすでにMicrosoft側でサーバー側の修正が完了しており、現時点で新たな対応は不要です。

しかし、この脆弱性の発見が示唆しているのは、AI特有の新しいリスクが継続的に発見される可能性があるという事実です。Copilotがクエリに対する応答を作成する際、Microsoft 365やTeams上の共有リソース(メール、メッセージ、ドキュメントなど)からコンテキストを頻繁に取得することから、過去のコンテンツが漏洩するリスクは常に存在します。

私が企業に推奨しているのは、「修正済みだから安心」と油断せず、最新の脆弱性情報をキャッチアップする体制を整え、継続的なセキュリティ監査を実施することです。

EchoLeakは、AIエージェントの設計上の盲点を突いた初のゼロクリック型脆弱性として、企業のセキュリティ体制に重要な示唆を与えました。Microsoftによる修正は迅速で、現時点で実害は確認されていませんが、RAG構造を持つ他のAIシステムにも同様の潜在リスクが残されています。企業としては、AI固有の攻撃ベクトルを想定した脆弱性管理と継続的な監査体制の構築が不可欠です。

実際に起きた情報漏洩事例から学ぶ教訓

理論的なリスクだけでなく、実際に発生した情報漏洩事例を分析することで、自社の対策に活かせる具体的な学びが得られます。

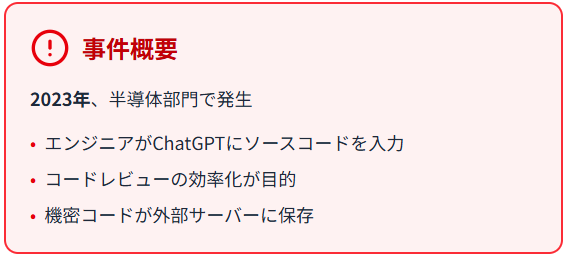

サムスン電子のソースコード流出事件

2023年、サムスン電子の半導体部門で深刻な情報漏洩事件が発生しました。

半導体部門のエンジニアが社内ソースコードをChatGPTに入力してコードレビューの効率化を図ろうとしたところ、機密コードが外部サーバーに保存される重大インシデントに発展したのです。PC Watchの報道によると、3件の機密漏洩が確認され、新製品に関するソースコードや社内会議の録音データまでもが外部に流出しました。

サムスンはこの事件を受けて全従業員のChatGPT等生成AI利用を即時禁止し、社内ネットワークでの生成AIシステム使用を全面禁止する厳格な措置を取りました。

- 「便利だから」という理由だけでの利用は極めて危険

- 社員教育とガイドライン整備の重要性

- 技術的な制限だけでなく社員の意識改革が必要

日本国内で661件のアカウント情報が闇市場へ

2023年、マルウェア「インフォスティーラー」によるChatGPTアカウント情報の窃取事件が発生し、日本だけで661件、世界全体では数万件規模のID・パスワードがダークウェブの闇市場で売買される事態となりました。

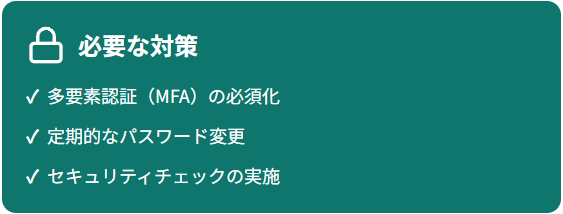

第三者による不正アクセスのリスクや、企業アカウントの場合は会話履歴から機密情報が漏洩する可能性が明らかになりました。この事例が示唆するのは、アカウント情報管理の徹底、多要素認証(MFA)の必須化、定期的なパスワード変更とセキュリティチェックの必要性です。

企業のIT担当者は、「アカウント情報が盗まれる=過去の会話履歴すべてが漏洩する」というリスクシナリオを想定すべきでしょう。

企業が繰り返す同じ失敗パターン

サムスンの事例と日本国内のアカウント流出事件に共通するのは、「利便性を優先し、セキュリティリスクを軽視した結果」という構図です。企業が繰り返す失敗パターンとして、社内ガイドラインの未整備、社員教育の不足、技術的な制限措置の欠如が挙げられます。

特に中小企業では、リソース不足を理由にセキュリティ対策を後回しにしがちですが、一度情報漏洩が発生すれば、取引先との信頼関係の喪失や法的責任の追及など、事業継続に直結する深刻な打撃を受けます。

私が企業支援の現場で繰り返し伝えているのは、「導入前の十分な準備と継続的な教育体制の構築こそが、長期的なコスト削減とリスク回避につながる」という原則です。

「技術的な脆弱性」よりも「人と運用」に起因するリスクを明確に示しています。サムスン事件のように利便性を優先した結果、企業の中核情報が外部に流出することは決して他人事ではありません。アカウント流出の事例も含め、技術対策と同時に社員教育とガイドライン整備を両輪で進めることが不可欠です。

法務・コンプライアンス面で注意すべきリスク

Microsoft 365 Copilotの導入は、技術的なセキュリティだけでなく、法務・コンプライアンス面でも慎重な検討を要します。

技術面で完璧な対策を講じても、法務面での配慮が欠けていれば、企業は重大なリスクに晒されます。

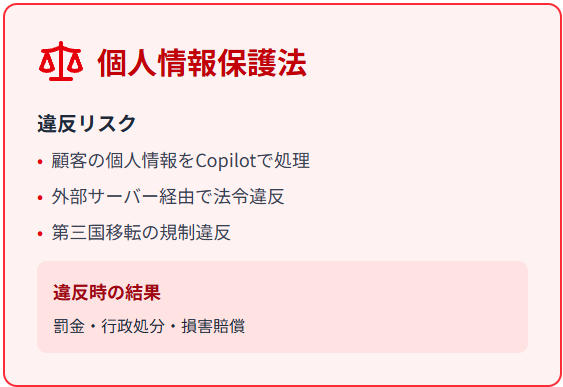

個人情報保護法違反のリスク

Copilotで顧客の個人情報を処理する際、個人情報保護法(日本)やGDPR(EU)などの規制に違反するリスクが存在します。顧客の個人情報をCopilotで処理し、外部サーバー経由で法令違反となるケースや、第三国移転の規制違反が発生する可能性があるのです。

違反した場合、罰金、行政処分、損害賠償といった重大な結果を招きます。企業はどのようなデータをCopilotで処理して良いのか、明確な基準を設ける必要があります。私が推奨しているのは、個人を特定できる情報は原則としてCopilotに入力しない、という厳格なポリシーの策定です。

取引先との秘密保持契約に抵触する可能性

取引先との秘密保持契約に「外部サービスでのデータ処理禁止」条項が含まれている場合、社員が無自覚にCopilotで処理すると契約違反となります。契約解除、損害賠償請求、信用失墜といった深刻な事態に発展する可能性があるのです。

特に、守秘義務が厳格な業界(金融、医療、法律など)では、契約内容を精査し、Copilot利用が契約に抵触しないか事前確認が欠かせません。実際の企業支援では、法務部門と情報システム部門が連携し、全取引先との契約内容を洗い出すプロセスを推奨しています。

業界別の規制への対応

業界によって、AI利用に関する規制や求められるセキュリティレベルは大きく異なります。以下、主要業界での注意点を整理しましょう。

金融業界での特別な規制

金融業界では、金融庁の監督指針やマネーロンダリング対策など、極めて厳格な規制が適用されます。顧客口座情報や取引データの漏洩は、業務停止命令や免許取消といった重大な行政処分につながる可能性があります。

金融機関がCopilotを導入する際は、利用範囲の厳格な制限、データの匿名化処理、監査体制の強化が求められます。

医療業界での患者データ保護

医療業界において、患者データは最重要個人情報として扱われ、HIPAA(米国)や個人情報保護法の厳格な適用を受けます。患者の診療記録や検査結果などをCopilotで処理することは、原則として禁止すべきです。

医療機関では、入力禁止ポリシーの徹底、アクセス権限の最小化、定期的な監査が不可欠です。

製造業での知的財産権の扱い

製造業において、設計図、製造ノウハウ、特許情報などの知的財産は企業の競争力の源泉です。これらの情報がCopilot経由で流出すれば、競争優位性の喪失や事業継続への打撃となります。

製造業では、知的財産保護のための明確な利用ポリシー、技術情報の入力禁止ルール、社内教育の徹底が求められます。

Copilotのような生成AIを業務で扱う際は、個人情報保護法や契約上の守秘義務など、法務・コンプライアンス面の整合性を最優先すべきです。特に、業界特有の規制(金融・医療・製造)を軽視すると、重大な違反や信用失墜につながる恐れがあります。

企業が実施すべき6つのセキュリティ対策

Microsoft 365 Copilotを安全に導入するには、技術・運用・教育の三位一体での対策が不可欠です。ここでは、私が企業支援の現場で実際に推奨している6つの対策を、具体的な実装方法とともに紹介します。

アクセス権限管理の徹底方法

Copilotのセキュリティで最も重要なのは、アクセス権限の適切な管理です。権限設定が甘いと、本来見えるべきでない情報がCopilot経由で参照されるリスクが生じます。

セキュリティ専門家が指摘しているように、フォルダ単位のアクセス制御だけでは不十分で、ファイルの誤コピーによる漏洩リスクも考慮する必要があります。

Microsoft Entra IDでユーザー単位の制御

Microsoft Entra ID(旧Azure Active Directory)を使用して、ユーザー単位およびグループ単位でのロール管理を実施してください。条件付きアクセスにより、IP制限や端末制限を設定し、外部共有の制限・禁止も可能です。

誰が・いつ・どのデバイスからCopilotにアクセスできるかを厳密に管理できるため、不正アクセスの防止に有効です。多くのセキュリティサービス提供企業が、このEntra ID設定を含むセキュリティ対策を統合パッケージとして提供しています。

SharePointとOneDriveの権限レベル設定

SharePoint、OneDrive、Teamsの権限レベルを、所有者、編集者、閲覧者に明確に区分し、最小権限の原則(Principle of Least Privilege)を適用してください。四半期ごとの権限監査を実施し、不要な権限は即座に削除することが重要です。

Microsoft Purviewの情報保護ラベル設定やDLP(Data Loss Prevention)ポリシーを活用することで、機密情報の自動保護も可能になります。

所有者、編集者、閲覧者の3つの権限レベルを明確に定義し、業務上必要最小限の権限のみを付与します。

定期的な権限監査により、不要な権限の蓄積を防ぎ、退職者や異動者の権限を速やかに削除します。

情報保護ラベルとDLPポリシーを設定し、機密情報の自動保護と漏洩防止を実現します。

データ暗号化とゼロトラストモデルの実装

データ暗号化は、保存時(BitLocker、ファイル単位暗号化)と通信時(TLS、IPsec)の両方で実施する必要があります。Zero Trustモデルを実装し、「信頼しない、常に検証する」という原則のもと、多要素認証(MFA)を必須化してください。

Microsoft 365 Copilotの公式ドキュメントでは、Entra ID(旧Azure Active Directory)を使用し、職場または学校アカウントでのみアクセス可能にすることが推奨されています。

セキュリティソフト(ウイルス対策、DLP)の導入により、想定コストは月額数万円からとなりますが、情報漏洩による損失と比較すれば必要な投資と言えるでしょう。

- データ暗号化:保存時と通信時の両方で実施

- Zero Trustモデル:すべてのアクセス要求を検証

- 多要素認証(MFA):職場または学校アカウントでのみアクセス可能

- リアルタイム監視:持続的なセキュリティ監査と脅威分析

安全な利用ガイドラインの策定ポイント

利用ガイドラインの策定は、技術的対策と並んで極めて重要な対策です。明文化することで、社員が迷わず安全に利用できる環境を整えます。

入力禁止情報の明確化

利用可能な情報の範囲(社外秘以外、個人情報以外など)を明確に定義し、絶対禁止事項(顧客データ直接入力、契約書の貼り付けなど)を具体的に列挙してください。

誤用例を具体的に示すことで、社員が「これはダメなのか」と判断しやすくなります。違反時の罰則規定も明記し、四半期ごとまたは新機能追加時に定期更新を行ってください。

- 顧客の個人情報(氏名、住所、電話番号、メールアドレスなど)

- 契約書、秘密保持契約の全文

- 価格表、見積書の具体的な金額

- ソースコード、設計図、特許情報

- 社内会議の録音データ、議事録(機密指定のもの)

部署ごとの利用責任者配置

部署ごとに利用責任者を配置し、現場レベルでの相談窓口と監視体制を構築します。利用責任者は、ガイドラインの周知徹底、利用状況のモニタリング、インシデント発生時の初動対応を担当します。

全社一律のルールだけでなく、部署特有のリスクにも対応できる柔軟な体制を整えましょう。

社員教育プログラムの設計方法

社員教育は、技術的対策を活かすための最も重要な要素です。

研修内容には、Copilotの仕組みと情報の流れ、情報漏洩リスクの具体例、安全なプロンプト設計(機密情報のマスキング方法)、誤用事例の共有、ガイドラインの周知徹底を含めてください。導入時の研修は必須とし、その後も年2回以上の頻度で全Copilot利用者(役員含む)を対象に実施します。理解度テストや利用状況モニタリングによる効果測定を行い、継続的な改善を図ることが重要です。

私が企業支援で重視しているのは、座学だけでなくハンズオン形式での実践的な訓練です。多くの企業向けセキュリティサービスでも、管理者向けハンズオンセミナーが提供されています。

入力データがどのように処理され、どこに保存されるのかを明確に説明します。クラウド経由での処理というリスクを正しく理解させることが重要です。

機密情報を抽象化・マスキングする具体的な方法を、実際のプロンプト例を使って訓練します。

- NG例:「A社との契約金額は500万円ですが、適正ですか?」

- OK例:「取引先との契約で、業界平均と比較して適正な金額かを判断する基準を教えてください」

サムスン電子のソースコード流出事件など、実際の誤用事例を共有し、自社でも起こりうるリスクとして認識させます。

段階的な導入プロセスの進め方

一度に全社展開するのではなく、段階的な導入プロセスを踏むことでリスクを最小化できます。

PoC実施での検証項目

Phase 1のPoC(概念実証)では、限定部署で小規模検証(1〜2ヶ月)を行い、リスク洗い出しと対策検証を実施します。

検証項目には、技術的なセキュリティ設定の有効性、ガイドラインの実効性、社員の理解度と利用状況、想定されるインシデントシナリオの確認を含めてください。

パイロット導入での改善サイクル

Phase 2のパイロット導入では、複数部署に展開(3〜6ヶ月)し、ガイドライン・教育プログラムの実運用を行います。フィードバックを収集し、PDCAサイクル(Plan-Do-Check-Act)を回すことで、Phase 3の全社展開に向けた準備を整えます。

導入支援サービスが提供するアフターフォローミーティングのように、導入後の課題や今後の利用推進について定期的に意見交換する場を設けることも有効です。

リアルタイム監視とインシデント対応体制

導入後も継続的なモニタリングが欠かせません。Microsoft 365 Copilotでは、リアルタイム監視と脅威分析が実装されており、持続的なセキュリティ監査が可能です。

異常なアクセスパターンや大量データの抽出を検知し、インシデント発生時の対応フローを明確化してください。Microsoft Purviewの監査ログ機能を活用し、誰が・いつ・どのような情報にアクセスしたかを記録・分析することで、早期発見と迅速な対応が可能になります。

運用ルールと人材教育を一体で設計することが欠かせません。特にアクセス権限の最適化やデータ暗号化、Zero Trustモデルの採用は、企業セキュリティの根幹を支える要素です。加えて、明確な利用指針と継続的な教育を組み合わせることで、ヒューマンエラーや不適切なAI活用を防止できます。

導入前にチェックすべき判断基準

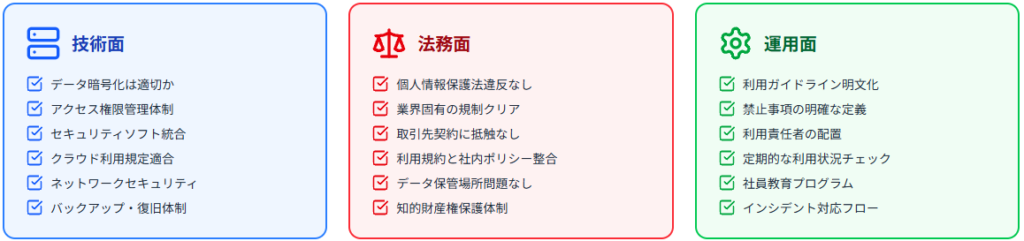

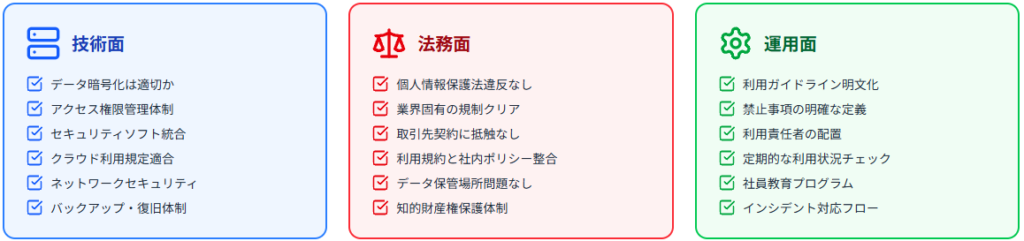

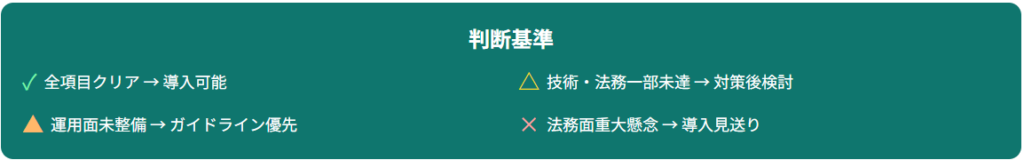

Microsoft 365 Copilotを導入すべきか判断するには、技術・法務・運用の3つの観点から総合的に評価する必要があります。

以下のチェックリストを活用してください。

技術面での確認項目

データ暗号化は適切に運用されているか、アクセス権限管理体制は整備されているか、セキュリティソフトとの統合は可能か、クラウド利用に関する社内規定に適合するか、ネットワークセキュリティは十分か、バックアップ・復旧体制はあるかを確認してください。

これらの項目がクリアできていれば、技術面での導入準備は整っていると判断できます。

- データ暗号化は適切に運用されているか(保存時・通信時)

- アクセス権限管理体制は整備されているか

- セキュリティソフトとの統合は可能か

- クラウド利用に関する社内規定に適合するか

- ネットワークセキュリティは十分か

- バックアップ・復旧体制はあるか

法務面でのリスク評価

個人情報保護法に違反しないか、業界固有の規制(金融庁、厚労省など)はクリアできるか、取引先との契約に外部サービス利用禁止条項はないか、Copilot利用規約と社内ポリシーは整合しているか、データ保管場所(日本国内/海外)は問題ないか、知的財産権の保護体制はあるかを評価してください。

法務面で重大な懸念がある場合は、導入見送りまたは法務確認後の判断が必要です。

- 個人情報保護法に違反しないか

- 業界固有の規制(金融庁、厚労省など)はクリアできるか

- 取引先との契約に外部サービス利用禁止条項はないか

- Copilot利用規約と社内ポリシーは整合しているか

- データ保管場所(日本国内/海外)は問題ないか

- 知的財産権の保護体制はあるか

運用体制の整備状況

利用範囲を明文化したガイドラインはあるか、禁止事項は明確に定義・周知されているか、部署ごとに利用責任者は配置されているか、定期的な利用状況チェック体制はあるか、社員教育プログラムは用意できるか、インシデント発生時の対応フローはあるかを確認してください。

運用面が未整備の場合は、ガイドライン策定と教育を優先すべきです。全項目クリアできれば導入可能、技術・法務の一部未達なら対策実施後に導入検討、運用面が未整備ならガイドライン策定と教育を優先、法務面で重大な懸念があるなら導入見送りまたは法務確認後、という判断基準が妥当でしょう。

- 利用範囲を明文化したガイドラインはあるか

- 禁止事項は明確に定義・周知されているか

- 部署ごとに利用責任者は配置されているか

- 定期的な利用状況チェック体制はあるか

- 社員教育プログラムは用意できるか

- インシデント発生時の対応フローはあるか

Copilot導入の可否を判断する際は、技術・法務・運用の3軸をバランスよく評価することが重要です。特に「技術面の安全性が確保されても、法務や運用体制が未整備であればリスクは残る」という点を見落としてはいけません。暗号化や権限管理などの基礎的対策に加え、法令遵守と社員教育を一体化させることで初めて安全な導入が可能になります。

Microsoft 365 Copilot導入を成功させるポイント

導入後も継続的な改善と監視を行うことが、長期的な成功につながります。

最小権限の原則を守る設計

最小権限の原則(Principle of Least Privilege)を徹底し、ユーザーに必要最小限の権限のみを付与してください。権限の付与は業務上の必要性を厳密に審査し、定期的な見直しを行うことで、不要な権限の蓄積を防ぎます。万が一アカウントが侵害された場合でも、被害範囲を最小限に抑えることができます。

SoftwareOneが推奨するベストプラクティスでも、アクセス権限の適切な管理が安全運用の中核とされています。

継続的なセキュリティ監査の実施

導入後も四半期ごとの権限監査、年次のセキュリティ評価、利用状況の定期レビューを実施してください。

監査では、不要な権限の削除、ガイドライン違反の検出、新たなリスクの洗い出しを行い、継続的な改善につなげます。外部の専門家による第三者監査も、客観的な評価を得るために有効です。

- 四半期ごとの権限監査:不要な権限の削除と退職者・異動者の権限見直し

- 年次のセキュリティ評価:新たな脆弱性への対応状況を確認

- 利用状況の定期レビュー:ガイドライン違反の検出と改善

- 第三者監査:客観的な評価によるセキュリティ強化

最新の脆弱性情報のキャッチアップ体制

AI技術は急速に進化しており、新たな脆弱性が継続的に発見されています。Microsoftのセキュリティアップデート情報、セキュリティ企業のレポート、業界団体の情報共有を定期的にチェックし、自社への影響を迅速に評価する体制を構築してください。

EchoLeakの事例のように、ベンダーの迅速な対応が期待できる一方、企業側も最新情報のキャッチアップが必須です。私が企業に推奨しているのは、情報セキュリティ担当者を明確に指名し、週次でのセキュリティ情報チェックを業務として組み込むことです。

最小権限の原則を徹底し、アクセス範囲を常に最適化することがリスク低減の基本です。さらに、定期的なセキュリティ監査と外部評価を組み合わせることで、運用の盲点を防げます。AI特有の脆弱性に対応するためには、最新情報の継続的な収集と即応体制を整えることが重要です。

よくある質問|Microsoft 365 Copilotの情報漏洩リスク

入力したデータは本当にAIの学習に使われないのですか?

Microsoft 365 Copilot(法人向け)では、入力したデータがAIモデルの学習に使用されることはありません。

Microsoftは公式に「Microsoft Graph経由でアクセスされるプロンプト、応答、データは、Microsoft 365 Copilotで使用されるものを含め、基礎LLMのトレーニングには使用されません」と明言しています。

ただし、これは法人向けプランに限った話であり、無料版やCopilot Proでは学習に使われる可能性があるため、企業利用には適していません。

過去の会話履歴は削除できますか?

Microsoft 365 Copilotでは、会話履歴の削除が可能です。ユーザーは「マイアカウントポータル」から履歴削除できますし、管理者はMicrosoft Purviewで管理可能です。

履歴管理と保存ポリシーを明確化し、定期的な削除ルールを設定することが推奨されます。特に機密性の高い情報を含む会話は、業務完了後速やかに削除するルールを策定すべきです。

無料版Copilotと法人向けの違いは何ですか?

最も大きな違いは、セキュリティレベルとデータの取り扱いです。

法人向けMicrosoft 365 Copilotは、商用データ保護機能を備え、入力データがAI学習に使われることはありませんが、無料版では学習に使用される可能性があります。

法人向けはエンタープライズグレードの暗号化、アクセス制御、コンプライアンス準拠(GDPR、ISO 27001、HIPAAなど)を提供しますが、無料版にはこれらの保証がありません。企業の機密情報を扱う場合は、必ず法人向けプランを選択してください。

すべての業界で安全に使えますか?

業界によって求められるセキュリティレベルや規制が異なるため、一概に「すべての業界で安全」とは言えません。金融業界では金融庁の監督指針、医療業界ではHIPAAや個人情報保護法、製造業では知的財産権保護など、業界固有の規制への対応が必要です。

各業界の規制を理解し、それに応じた対策を講じることで、安全に利用できます。私の企業支援の経験では、金融・医療業界では特に慎重なリスク評価と段階的な導入が求められます。

既に修正されたEchoLeakへの追加対応は必要ですか?

EchoLeak(CVE-2025-32711)は2025年5月にMicrosoft側でサーバー側の修正が完了しており、ユーザー側での追加対応は不要です。ただし、この脆弱性の発見は、AI特有の新しいリスクが継続的に発見されることを示唆しています。

企業としては、最新の脆弱性情報のキャッチアップ体制を整え、今後も同様の脆弱性が発見される可能性を念頭に置いた運用が重要です。「修正済みだから安心」と油断せず、継続的なセキュリティ監査と情報収集を怠らないでください。