PerplexityAIは安全か?企業導入で失敗しないためのリスク対策と判断基準

2025年8月、朝日新聞と日本経済新聞がPerplexity AIを44億円の損害賠償で提訴し、同月にはBraveがPerplexityのAIブラウザ「Comet」に重大なセキュリティ脆弱性を発見したと発表しました。出典明記機能で信頼性の高いAI検索エンジンとして注目を集めるPerplexityですが、企業導入時には見過ごせないリスクが存在します。

「Perplexityは本当に安全なのか?」この疑問に対し、一部の評価では「やや危険」レベルとされています。プロンプトインジェクション攻撃による機密情報流出、AIハルシネーションによる誤情報取得、著作権侵害による法的リスクなど、企業が直面する課題は深刻です。一方で、Enterprise版ではSOC2認証取得、自動ファイル削除、セキュリティ監視など、安全機能を提供しています。

この記事では、Perplexity AIの安全性を徹底検証し、他社AIサービスとの比較分析、業界での導入事例、そして企業が実践すべき安全利用対策まで具体的に解説します。AI活用による業務効率化を図りながら、情報漏洩や法的責任のリスクを回避するための実践的な判断基準を提供いたします。

- Perplexityの安全性評価とその根拠

- 無料版とEnterprise版のセキュリティ機能の違い

- 他社AIサービスとの安全性比較と適用場面

- 業界での導入事例と考慮すべきポイント

- 企業が実践すべき安全利用対策と法的責任範囲

PerplexityのAIとしての安全性について現状評価とビジネス利用での位置づけ

安全性レベル「やや危険」の理由と企業が注意すべきポイント

専門機関による評価では、Perplexity AIが「やや危険」レベルに分類される理由が明らかになっています。企業機密や個人情報の保護において構造的な脆弱性があり、Microsoft AzureとBingへの技術依存がセキュリティリスクを増大させています。

2025年のAI搭載ブラウザではユーザーの閲覧活動を常時監視する仕組みとなり、従来のWebブラウジングとは異なるプライバシーリスクを生んでいます。特に注目すべきは、これらの技術的制約が企業の情報管理ポリシーと根本的に相反する可能性があることです。

出典明記機能によるファクトチェック精度の向上

Perplexityが他のAIツールと一線を画すのが、リアルタイム検索と出典明記の機能です。企業のリサーチ業務では情報の出典確認が不可欠であり、この点で従来のAIチャットボットより優位性があります。

ただし、AIが生成したコンテンツを情報源として引用する「二次的ハルシネーション」のリスクが指摘されています。出典表示があっても、元の情報源がAI生成であった場合、結果的に誤った情報が拡散される可能性があり、出典明記機能だけでは情報の質を完全に保証するものではありません。

Microsoft Azure依存によるセキュリティ体制の実情

Enterprise ProはAWSインフラストラクチャで運営され、物理セキュリティから業界認証まで包括的な保護体制を構築しています。Wizとの連携により能動的リスク特定を行い、外部セキュリティ研究者との脆弱性開示プログラムで継続的な改善を図っています。

24時間体制のセキュリティ監視とBugCrowdでのプライベートバグバウンティプログラムにより、新たな脆弱性の早期発見と対応を実現しています。AWS IAMによる本番環境アクセス管理など、企業レベルのセキュリティ要件に対応した機能を提供しています。

ReAlice株式会社 開発担当者

ReAlice株式会社 開発担当者Perplexityのようなリアルタイム検索型AIは利便性が高い反面、構造上のプライバシーリスクを正しく理解しておく必要があります。特に企業利用で、出典が明記されていてもAI生成情報の連鎖的誤引用に注意が必要です。

ビジネス利用で避けられない3つの主要リスク

情報漏洩リスクと完全なセキュリティ保証の限界

Check Point Researchによる検証では、Perplexity AIがプロンプトインジェクション攻撃への脆弱性を持つことが実証されました。悪意あるプロンプトにより機密情報が意図せず流出する危険性があり、企業での利用時には厳格な情報管理が求められます。

世界初のプロンプトインジェクション攻撃マルウェアの発見により、AIベースのセキュリティツールを標的とした新たな攻撃手法が現実化しており、企業の機密保持義務と相反する構造的リスクが存在することが判明しています。

ハルシネーションと誤情報取得による業務への影響

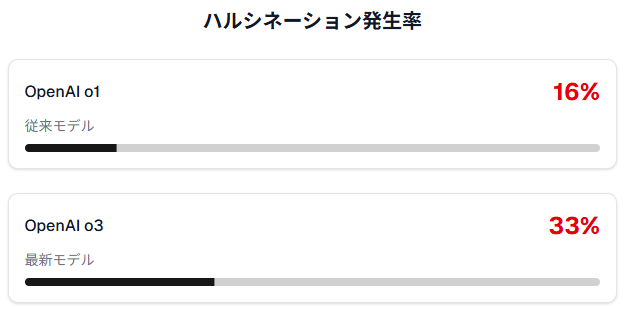

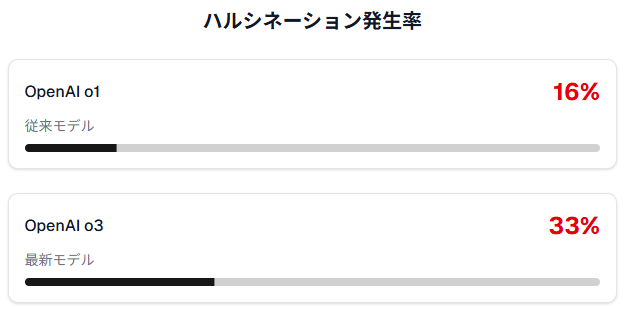

AI技術の進歩がハルシネーション問題を解決するという期待に反し、OpenAIの最新モデルo3では33%の確率でハルシネーションが発生することが内部テストで判明しました。従来モデルo1の16%と比較して倍増しており、技術革新が必ずしも精度向上を意味しないことが分かります。

このような高いハルシネーション率は、ビジネス判断の根拠として使用するには重大なリスクがあり、AI生成情報を業務に活用する際は十分な検証プロセスが不可欠です。

著作権問題と出版社からの盗用申し立て事例

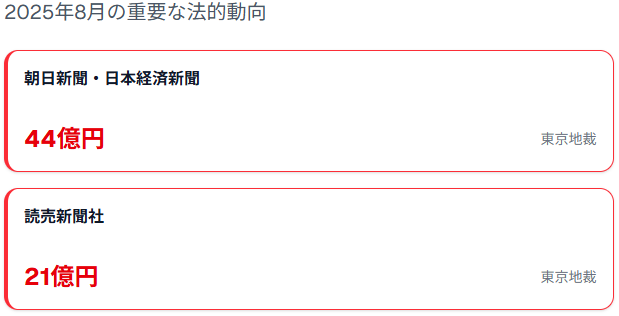

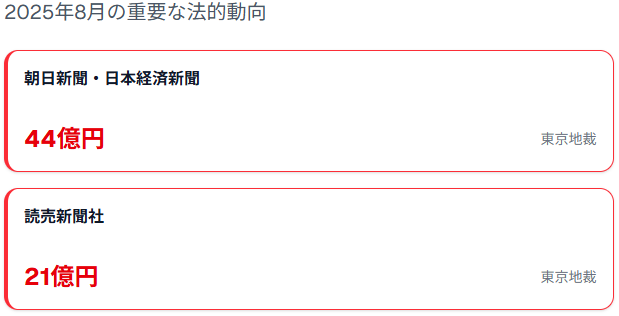

2025年8月、朝日新聞と日本経済新聞がPerplexity AIを東京地裁に提訴し、44億円の損害賠償を請求する事態となりました。両社の主張によると、2024年6月以降の記事無断複製に加え、robots.txtによる利用拒否の無視、有料会員限定記事の無断使用により、報道機関としての信頼性を損なわれたとしています。

読売新聞社も同様に約21億円の損害賠償請求訴訟を起こしており、RAG技術を使用するAIサービス全般に対する法的圧力が高まっています。企業がPerplexityを利用する際は、こうした著作権リスクも考慮に入れる必要があります。

AI活用におけるセキュリティと法的リスクは、利便性を上回る深刻な課題となりつつあります。ハルシネーションについても、モデル進化と共に精度が保証されるとは限らず検証フローの整備が求められます。

Perplexityによるデータ収集と企業情報の取り扱い方針

無料版でのAI学習利用とEnterprise版での保護設定

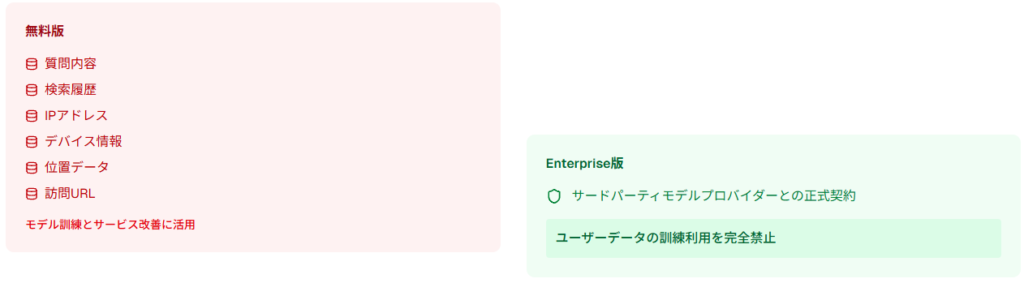

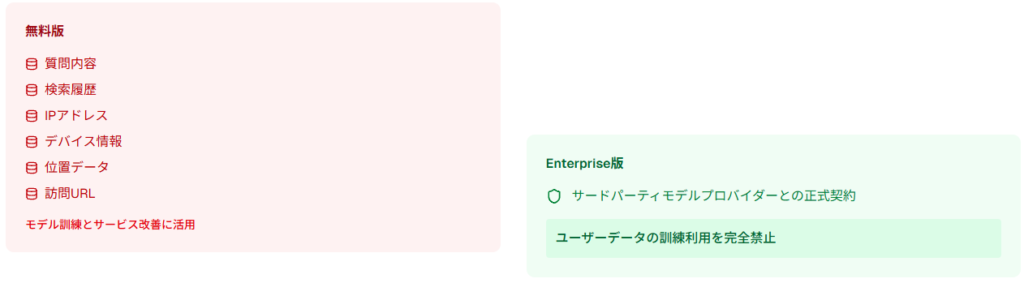

無料版では質問内容、検索履歴、IPアドレス、デバイス情報、位置データ、訪問ウェブサイトURL、閲覧ページテキストなど広範囲な個人情報を収集し、これらがモデル訓練とサービス改善に活用されます。一方、Enterprise Proでは根本的に異なるアプローチを採用しています。

すべてのサードパーティモデルプロバイダーと正式契約を結び、ユーザーデータの訓練利用を完全に禁止する保護体制を構築しています。この違いは単なる機能差ではなく、企業データの取り扱いに関する根本的な思想の違いを表しています。

各サービスのデータ保持期間の比較

各AIサービスのデータ保持期間を比較すると興味深い違いが見えてきます。ChatGPTは履歴無効時でも30日間保持し、有効時は無期限保存を行います。Google Geminiは18ヶ月間のデータ保存を基本とし、ユーザーが3ヶ月から36ヶ月の範囲で調整可能です。

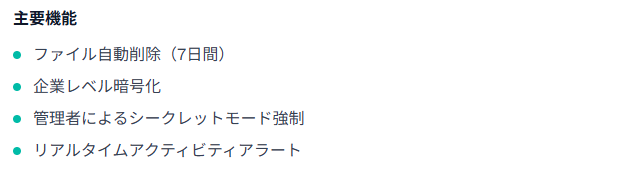

Perplexity Enterprise版では7日間の自動ファイル削除機能を備えており、Spacesにアップロードされたファイルのみ永続保存される仕組みです。この設計により、一時的な業務ファイルの長期保存リスクを回避できます。

第三者共有の条件と例外規定

データの第三者共有について、Perplexityはユーザー同意と法執行要請の場合に限定しています。GDPR準拠のため、DataRepをEU代表者(アイルランド)、TrustKeith Ltdを英国データ保護責任者として指定し、国際的な法的要件に対応しています。

ChatGPTが位置情報の第三者開示可能性を明記し、Google Geminiが法執行機関要請時の情報共有を規定する中、Perplexityは比較的制限的なアプローチを取っています。ただし、これらの方針は各国の法的要請により変更される可能性があります。

無料版AIサービスでは利便性の裏にあるデータ収集と学習活用への理解が不可欠です。一方でEnterprise版は、データ主権を重視した契約・設計に基づいており業務利用におけるリスク管理の根幹となります。

Enterprise版の安全性機能とビジネス導入メリット

SOC2認証取得とシングルサインオン対応

SOC2 Type II認証取得により、Perplexity Enterprise Proは最高水準のデータ保護基準適合が第三者機関によって証明されています。

この信頼性を背景に、Stripe、Zoom、Bridgewater、Snowflake、Databricks、HP、Cleveland Cavaliersなど多数の企業が導入を決定しています。厳格なデータ管理を要求される金融・技術業界での採用実績が、その実用性を証明しています。

これらの機能組み合わせにより、機密文書の意図しない長期保存や不正アクセスのリスクを大幅に軽減できます。

企業向けセキュリティ強化策

Enterprise版には、24時間セキュリティ監視システム、AWS IAMによる本番環境アクセス管理、Wizとの連携による能動的リスク特定が含まれます。本番環境へのエンジニアアクセスは原則禁止とし、業務上必要な場合のみセキュリティ承認を経た短期間アクセスを許可する厳格な運用体制です。

Bugcrowdとの連携による脆弱性報告体制を構築し、認定セキュリティ研究者による継続的なセキュリティ向上を図っています。現在は正式なバグバウンティプログラムではなく、ケースバイケースでの評価・報酬体系を採用しています。

Bugcrowdとの連携は脆弱性管理をオープンに保ちつつ、リスク早期発見の枠組みとして有効に機能しています。

SOC2+SSO+継続的改善の組み合わせが、特に金融・公共・法務など機密性重視の業界に適した選択肢となるでしょう。

ChatGPTとGoogle Geminiとの安全性比較分析

データプライバシー保護レベルの実用的比較

三大AIサービスのプライバシー保護を詳細比較すると、明確な特徴差が浮かび上がります。Google Geminiは18ヶ月のデータ保持期間を基本とし、ユーザーが3ヶ月から36ヶ月まで自由に調整できる透明性の高さが特徴です。

ChatGPTは履歴有効時の無期限保存という積極的なデータ活用方針を採用しています。Perplexity AIは無料版でデータをモデル訓練に使用する一方、Enterprise版では完全なデータ保護を提供するという二極化したアプローチを取っています。

企業選択の観点では、透明性を重視するならGemini、機能性を優先するならChatGPT、最高レベルの保護が必要ならPerplexity Enterpriseという使い分けが適切です。

企業コンプライアンス対応の違いと選択指針

GDPR対応状況を見ると、各サービスの企業戦略の違いが明確になります。ChatGPTはEnterprise、Education、API顧客向けにEUデータ残留オプションを新たに提供し、EU/EEA内での処理・保存を可能にしています。Google GeminiはGDPRおよびCCPA完全準拠を実現し、Google Cloudインフラによる明確な地域データ残留を提供しています。

Perplexity Enterprise ProはSOC2 Type II認証取得により、最も包括的なコンプライアンス要件を満たしています。業界別に見ると、金融・医療分野ではSOC2認証が重視され、一般企業ではGDPR対応の充実度が選択基準となる傾向があります。

各AIサービスのビジネス利用適用場面

実際の企業導入事例を見ると、各サービスの特性に応じた使い分けが行われています。Perplexityの出典機能はリサーチ業務に最適で、特に情報の信頼性確認が重要な業務で威力を発揮します。ChatGPTは創作的タスクとプログラミング支援に強みがあり、Google Geminiは動画・音声処理とGoogleエコシステム連携で差別化を図っています。

業界特有の要件が選択を左右するケースも多く、効果的な活用には各サービスの特性を理解した適材適所の運用が重要です。

Perplexity Enterpriseは、デフォルトで学習不使用・短期保持など厳格なデータ統制が実装されており、高セキュリティが求められる業務に適しています。一方、ChatGPTやGeminiは柔軟な保存設定やクラウド連携機能により利便性重視のユースケースで優位性を持ちます。

企業が実践すべき安全利用対策

AIデータ保持設定の無効化

企業でPerplexity AIを安全に運用するための第一歩は、AIデータ保持機能の無効化です。入力データが学習目的で使用されることを防ぐため、プライバシー設定の適切な調整が必要です。

Enterprise版では管理者が組織全体のファイルアクセス権限を一元制御でき、個別ユーザーの設定ミスによる情報漏洩リスクを回避できます。シングルサインオン機能の活用により、既存の企業IDプロバイダーとの安全な統合が可能となり、認証プロセスの簡素化とセキュリティ強化を同時に実現できます。

シークレットモード活用と機密情報入力禁止の徹底

機密性の高い業務では、匿名モード(シークレットモード)の常時使用により会話履歴の保存を完全に防ぐ必要があります。社内ガイドラインには、顧客情報・財務データ・開発中製品情報の直接入力を禁止し、これらを含む可能性のある質問は匿名化・抽象化して行う旨を明記すべきです。

2025年8月にBraveが発見したプロンプトインジェクション攻撃を受けて、機密情報を含む可能性のあるWebページからの情報収集時には特別な注意が必要となっています。Reddit投稿のような外部コンテンツに悪意ある命令が埋め込まれるリスクがあり、こうした新種の攻撃への備えが急務です。

必須ファクトチェック体制の構築と運用ルール

Perplexityの出典表示機能があっても、複数の信頼できるソースでの確認作業を必須とする体制構築が重要です。特に法務・契約・財務関連情報については、専門家による検証を経ずにAI回答のみに基づく判断を禁止する明確なルールが必要です。

出典として表示されたリンクへの目視確認を徹底することで、誤情報や古い情報の獲得リスクを大幅に軽減できます。定期的なファクトチェック研修の実施により従業員のAIリテラシー向上を図り、組織全体での情報品質管理能力を高めることが長期的な成功につながります。

シークレットモードの常時使用やファクトチェックの明文化はリスクを事前に防ぐ実践的なアプローチです。

また、外部サイトからの情報取得に潜むプロンプトインジェクションへの備えも今後のAI利用における重要課題です。

業界別導入事例と具体的なセキュリティ対策

金融業界での導入時のコンプライアンス対応

金融機関におけるAI導入では、個人情報保護法と金融商品取引法の厳格な要件遵守が前提となるため、Enterprise版の選択が必須です。

みずほ銀行では全社で約400件のAI・機械学習プロジェクトを推進し、2024年8月に生成AIを活用した次世代コンタクトセンターシステムを導入しました。ゴールドマン・サックスはサードパーティ製ジェネレーティブAIツールの業務利用を禁止し、情報漏洩リスクへの対策を図りました。SOC2認証を取得したPerplexity Enterprise Proは、金融業界特有の厳格要件を満たすAIサービスとして注目されています。

三菱UFJ銀行では200を超える生成AI活用ユースケースを発掘し、不正検知やリスク管理の強化、業務効率化・自動化に取り組んでいます。

製造業における技術情報保護と活用バランス

トヨタ自動車では生成AIエージェント「O-Beya」を独自開発し、Microsoft Azure OpenAI Service上でGPT-4oを活用した9つ以上のAIエージェントを搭載しています。知識継承とイノベーション加速を目的とした独自システムの構築により、外部AIサービスへの依存度を抑制しています。

パナソニックは2025年1月にAI技術積極活用方針を発表し、スマート家電、産業分野、モビリティ、エネルギー管理での活用を推進する方針を明らかにしました。

日立製作所はAI倫理原則を策定し、プライバシー保護とセキュリティ重視を明記、個人情報の使用最小限化とデータ暗号化・アクセス制限を実施しています。製造業では技術優位性の保護と情報収集効率化のバランスが重要な課題となっています。

コンサルティング業界での顧客情報管理と利用方法

マッキンゼー・アンド・カンパニーでは中国本土での生成AI関連コンサルティング業務を停止するよう社内指示し、米政府の監視強化を背景とした最も厳格な顧客選定方針を採用しています。

コンサルティング業界では高度な機密性要求と効率性向上の同時実現が重要な課題であり、特定顧客に関連する情報の入力禁止や、プロジェクト終了後の自動データ削除システム構築などの対策が求められています。顧客情報の完全分離を維持しながら業務効率化を実現する運用モデルの確立が成功要因となっています。

金融や製造、コンサルティング領域では、セキュリティ対策とコンプライアンス準拠が前提条件となります。

ユースケースの整理と情報統制ルールの明文化は、継続的なAI活用に向けた土台作りとして重要です。

よくある質問

GDPR対応状況と日本の個人情報保護法との関係は?

Perplexity Enterprise ProはGDPR準拠を明確に規定しており、DataRepのEU域内代表者指定(アイルランド)とTrustKeith Ltdの英国データ保護責任者配置により、十分性認定地域での適切な処理体制を確保しています。

個人データの削除権(忘れられる権利)への対応も含まれていますが、無料版では対応詳細が不透明なため、企業利用ではEnterprise版の選択が強く推奨されます。特に越境データ移転が発生する国際企業では、これらの法的要件遵守が事業継続の前提条件となります。

競合他社情報の調査利用は法的に問題ないか?

公開情報の収集・分析は基本的に適法行為ですが、著作権侵害リスクへの配慮が不可欠です。2025年8月の朝日新聞・日本経済新聞による訴訟事例では、記事の無断複製・保存が法的争点となっており、競合分析時には出典確認とオリジナルサイトへの適切な配慮が重要です。

企業の公開レポートや統計データの分析は問題ありませんが、有料記事や専門レポートの内容活用には慎重な判断が求められます。競合情報調査結果に基づく業務判断の最終的な法的責任は企業側が負担するため、複数ソースでの確認作業が推奨されています。

無料版から企業版への移行時の注意点は?

移行プロセスにおけるデータ移行方針の事前確認が極めて重要です。無料版で蓄積された会話履歴やファイルはEnterprise版のデータ保護方針対象外となる可能性があるため、移行前の必要データバックアップと不要履歴の完全削除が推奨されます。

AIデータ保持設定も移行時にリセットされる可能性があるため、移行後の再設定確認が必須となります。計画的な移行スケジュールの策定により、業務継続性を確保しながら安全な移行を実現できます。

データ流出が発生した場合の企業責任範囲は?

SOC2認証取得のEnterprise Proでは、Perplexity側のセキュリティ侵害に対する一定の保護措置がありますが、ユーザー側の不適切な利用による情報流出は完全に企業責任となります。

機密情報の直接入力や匿名モード未使用による履歴保存は、明確に企業の管理責任範囲です。2025年8月に発見されたプロンプトインジェクション脆弱性のような新種攻撃への対応でも、企業側の予防策と対応体制の充実が法的責任軽減の鍵となります。

包括的な利用ガイドライン策定と継続的な従業員研修により、組織全体でのリスク最小化を図ることが重要です。

他のAIツールとの併用時のセキュリティ管理方法は?

ChatGPT、Google Gemini、Perplexity AIの併用時には、各サービスの異なるプライバシーポリシー理解と統一的な管理体制構築が不可欠です。

最も厳格なセキュリティ要件に合わせた運用ルール設定により、各ツールでの入力内容を適切に分類・管理する必要があります。複数AIサービス間での同一情報の重複入力は避け、Perplexityはリサーチ専用、ChatGPTは文書作成専用、Google Geminiはデータ分析専用といった明確な使い分けが推奨されます。

統合ログ管理システムの導入により、どのAIサービスでどの情報を処理したかの完全な追跡体制を構築することが、セキュリティ管理の核心となります。