TensorRTとは?NVIDIAのディープラーニング推論最適化ツールを徹底解説

近年、ディープラーニングの推論を高速化するツールとしてTensorRTが注目を集めています。

本記事ではTensorRTの概要や仕組み、使い方について詳しく解説し、その活用事例や他のフレームワークとの連携についても紹介します。

TensorRTを理解し効果的に活用することで、ディープラーニングモデルの推論パフォーマンスを大幅に向上させることができるでしょう。

- TensorRTの概要

- TensorRTの導入手順・使用方法

- TensorRTの仕組み

- TensorRTの活用事例

「AIで業務の自動化・効率化をしたい!だけど何から始めていいのかわからない・・・」という方はご気軽にご相談ください!

TensorRTの概要

TensorRTの定義と特徴

TensorRTはNVIDIAが開発したディープラーニング推論の最適化ツールです。

学習済みのニューラルネットワークを最適化し、GPUでの推論を高速化することを目的としています。

TensorRTは推論の高速化だけでなくメモリ使用量の削減や柔軟なデプロイにも対応しており、エッジデバイスでの推論にも適しています。

TensorRTの主な機能

- 推論の高速化

- メモリ使用量の削減

- 柔軟なデプロイ

TensorRTは、ネットワークの最適化や演算の並列化により、推論速度を大幅に向上させます。

不要な演算を削減し、メモリ使用量を最小限に抑えることが可能。

TensorRTで最適化されたモデルは、様々なプラットフォームやデバイスにデプロイできます。

TensorRTの仕組み

TensorRTのアーキテクチャ

TensorRTはネットワークの解析、レイヤーの融合、精度のキャリブレーション、エンジンの生成という一連のプロセスを経て、最適化された推論エンジンを生成します。

これにより、高速かつ効率的な推論が可能となります。

最適化のプロセス

ネットワークの解析

TensorRTは、学習済みのモデルを解析し、ネットワークの構造を理解します。

レイヤーの融合

複数のレイヤーを1つのカーネルに融合することで、メモリアクセスを削減し、推論速度を向上させます。

精度のキャリブレーション

INT8量子化を使用する場合、キャリブレーションデータセットを用いて、最適な量子化パラメータを決定します。

エンジンの生成

最適化されたネットワークを推論エンジンとして生成し、推論に使用します。

TensorRTの使い方

対応フレームワークとモデル

TensorRTは、TensorFlow、PyTorch、MXNetなどの主要なディープラーニングフレームワークと互換性があります。

また、ONNX形式のモデルにも対応しているため、様々なモデルを最適化することができます。

TensorRTの導入手順

NVIDIA GPUドライバとCUDAツールキットをインストールした後、TensorRTをインストールします。

学習済みのモデルをTensorRT対応の形式(ONNX、UFF、Caffe)に変換します。

TensorRTのAPIを使用して、最適化されたモデルで推論を実行します。

以下は、TensorRTを使用した推論の実行例(Pythonコード)です。

import tensorrt as trt

# TensorRTエンジンの読み込み

with open('sample.engine', 'rb') as f:

engine = trt.Runtime(trt.Logger(trt.Logger.WARNING)).deserialize_cuda_engine(f.read())

# 推論の実行

with engine.create_execution_context() as context:

# 入力データのセット

context.set_binding_shape(0, (1, 3, 224, 224))

input_data = np.random.randn(1, 3, 224, 224).astype(np.float32)

# 出力用のメモリ確保

output_data = np.empty((1, 1000), dtype=np.float32)

# 推論の実行

context.execute_v2(bindings=[input_data.ctypes.data, output_data.ctypes.data])

# 結果の表示

print(output_data)

TensorRTの活用事例

画像認識での高速化

TensorRTを使用することで、画像認識モデルの推論速度を大幅に向上させることができます。

例えば、ResNetやInceptionなどの有名なモデルをTensorRTで最適化し、リアルタイムでの物体認識や顔認識を実現できます。

物体検出の効率化

物体検出モデルは一般的に計算コストが高く、推論速度が重要となります。

TensorRTを使用することでYOLOやSSD、Faster R-CNNなどの物体検出モデルを最適化し、高速かつ正確な検出を実現できます。

自然言語処理モデルの最適化

BERTやGPT、T5などの大規模な自然言語処理モデルは推論に多くの計算リソースを必要とします。

TensorRTを使用することでこれらのモデルを最適化し、推論速度を向上させることができます。

Stable Diffusionの高速化

Stable Diffusionは高品質な画像生成モデルですが、推論に時間がかかる傾向があります。

TensorRTを使用することでStable Diffusionの推論速度を大幅に向上させ、より快適に画像生成を行うことができます。

TensorRTとPyTorchの連携

Torch-TensorRTの概要

Torch-TensorRTはPyTorchモデルをTensorRTで最適化するためのツールキットです。

PyTorchの使い慣れた開発環境を維持しながらTensorRTの高速推論の恩恵を受けることができます。

PyTorchモデルの変換と推論

Torch-TensorRTを使用することでPyTorchモデルをTensorRT対応のエンジンに変換し、高速な推論を実行できます。

変換されたモデルはPyTorchの推論と同じように使用できるため、シームレスな移行が可能です。

パフォーマンス比較

Torch-TensorRTを使用することでPyTorchモデルの推論速度を大幅に向上させることができます。

多くの場合、TensorRTで最適化されたモデルは、元のPyTorchモデルと比較して数倍から数十倍の速度で推論を実行できます。

TensorRT-LLMによる大規模言語モデルの高速化

TensorRT-LLMの特徴

TensorRT-LLMは、大規模な言語モデル(Large Language Models)を高速化するためのTensorRTベースのソリューションです。

GPTやT5などの巨大なモデルを最適化し、推論速度を大幅に向上させることができます。

対応モデルと性能

TensorRT-LLMは、GPT-2、GPT-3、T5などの主要な言語モデルに対応しています。

これらのモデルをTensorRT-LLMで最適化することで推論速度を数倍から数十倍に向上させることが可能です。

導入と使用方法

TensorRT-LLMは、TensorRTと同様にNVIDIA GPUドライバとCUDAツールキットが必要です。

TensorRT-LLMのAPIを使用して学習済みの言語モデルを最適化し、高速な推論を実行できます。

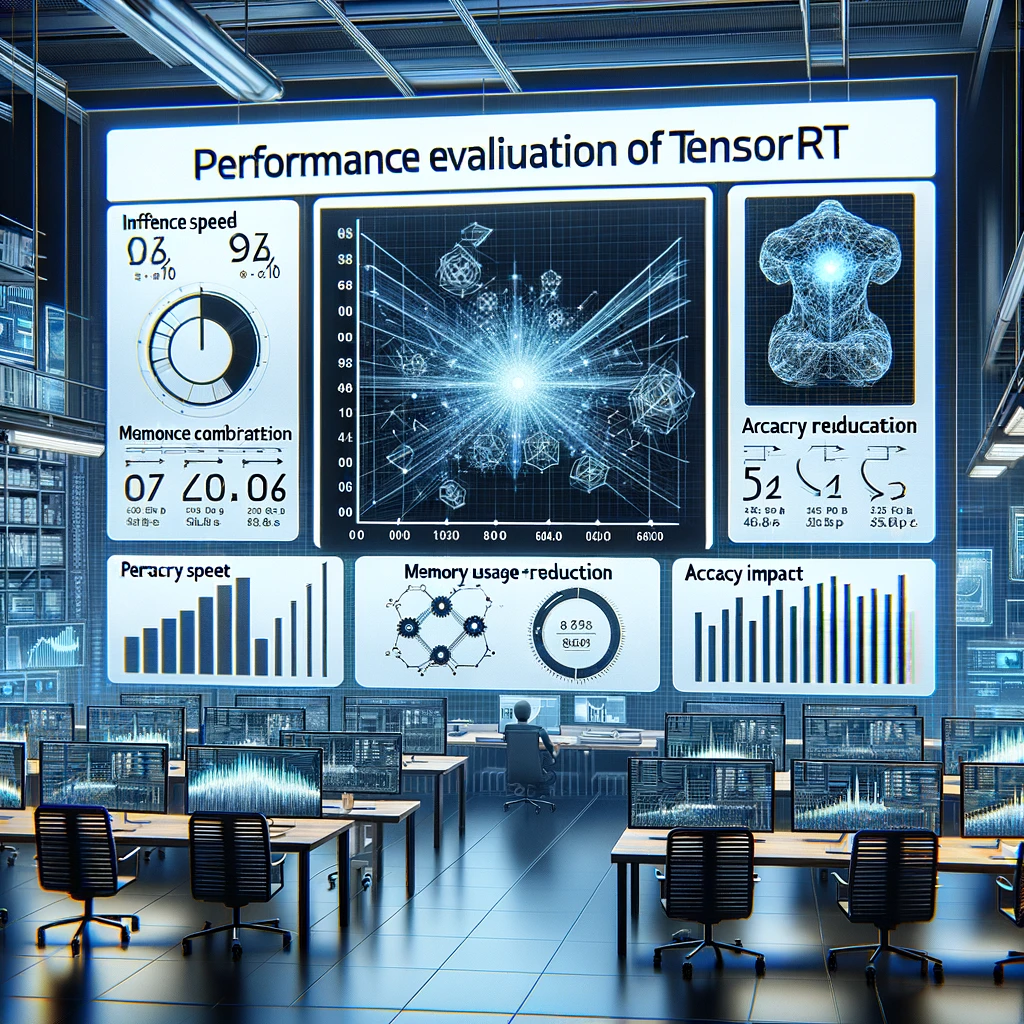

TensorRTのパフォーマンス評価

推論速度の比較

TensorRTで最適化されたモデルは元のモデルと比較して大幅な速度向上が期待できます。

多くの場合、数倍から数十倍の速度で推論を実行できます。

ただし、モデルの種類やサイズ、バッチサイズなどによって、速度向上の度合いは異なります。

メモリ使用量の削減効果

TensorRTは不要な演算を削減し、メモリ使用量を最小限に抑えることができます。

これにより、限られたメモリリソースを持つエッジデバイスでも大規模なモデルを効率的に実行できます。

精度への影響

TensorRTによる最適化は一般的に推論精度に大きな影響を与えません。

ただし、INT8量子化を使用する場合は量子化によって精度が若干低下する可能性があります。

適切なキャリブレーションを行うことで精度の低下を最小限に抑えることができます。

チャットボットを導入したい!AIで業務の自動化・効率化をしたい!

だけど何から始めていいのかわからない・・・

\AIコンサルReAliceに無料相談する/