Vertex AIのセキュリティは企業で使えるレベル?導入前に確認すべき7つの対策

「Vertex AIを導入したいけれど、セキュリティは大丈夫?」「顧客データや機密情報をAIに入力して問題ないの?」—企業でのAI活用を検討する際、多くの担当者が直面するのがセキュリティの懸念です。

2025年、生成AIの企業利用は急拡大していますが、それに伴い情報漏えいやプロンプトインジェクション攻撃などのリスクも増大しています。特に金融機関、医療機関、官公庁などでは、個人情報保護法やデータレジデンシ要件への対応が必須となっており、セキュリティ対策なしでのAI導入は企業存続に関わる問題です。

本記事では、Google CloudのVertex AIが提供する包括的なセキュリティ機能—CMEK、VPC Service Controls、Model Armor、データレジデンシなど—を詳しく解説します。

- Vertex AIのセキュリティ機能の詳細と実装方法

- プロンプトインジェクションや機密情報漏えいなど、生成AI特有のリスクへの具体的な対策

- Azure OpenAIとの機能・特性比較

- 金融・医療・官公庁など業界別のセキュリティ実装例

- 導入前のチェックリストから設定手順まで、すぐに使える実践的なガイド

Vertex AIのセキュリティが企業に必要な理由

生成AI導入で増大する情報漏えいリスク

企業での生成AI利用は急拡大していますが、それに伴いセキュリティリスクも深刻化しています。Netskopeが2025年8月18日に発表した調査では、2025年3月初頭から5月末までの3ヶ月間で、企業のエンドユーザーによる生成AIプラットフォームの利用率が50%急増したことが明らかになりました。

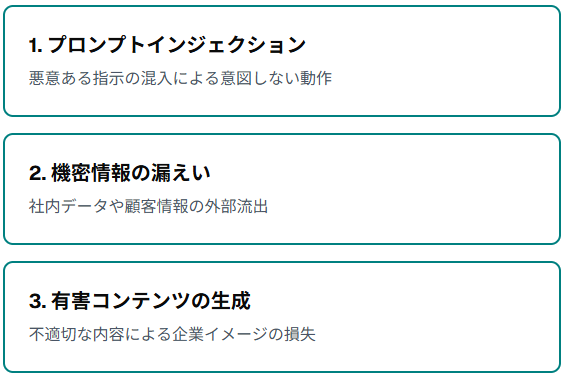

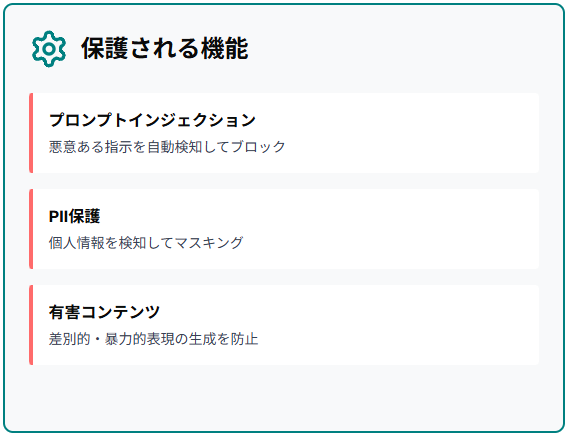

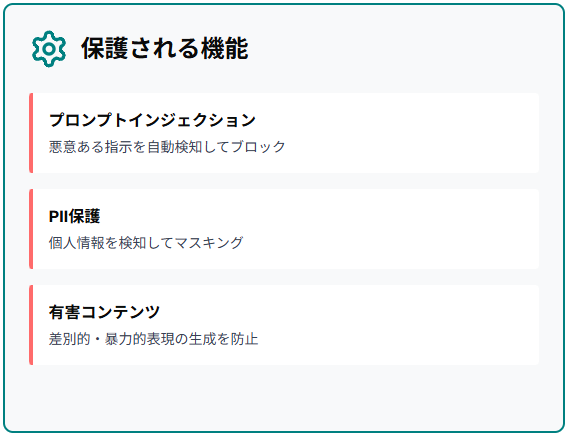

この急速な普及の裏で、従業員が会社の許可なく個人的にChatGPTなどを使う「シャドーAI」による機密情報の流出が後を絶ちません。生成AIの主なリスクは「プロンプトインジェクション」「機密情報の漏えい」「有害コンテンツの生成」の3つに大別されます。

ビジネス利用における法規制とコンプライアンス要件

日本国内でAIを業務利用する企業は、個人情報保護法やGDPRなどの法規制に対応する必要があります。特にデータの保存場所や処理場所を国内に限定する「データレジデンシ」要件は、金融機関や官公庁で厳格に求められています。

Google Cloudは日本リージョン(tokyo/asia-northeast1)でデータレジデンシ保証を提供しています。コンプライアンス認証も豊富で、ISO 27001やSOC 2などの国際基準にも対応しています。

Vertex AIが企業向けセキュリティで選ばれる背景

Vertex AIは、Google Cloudの堅牢なセキュリティ基盤を活用できる企業向けプラットフォームです。多くの企業がVertex AIを活用し、金融取引の不正検出やeコマースのユーザー体験改善などを実現しています。IAM、VPC Service Controls、Cloud Audit Logsといった高度なセキュリティ機能が標準装備されている点が評価されています。

これらの企業がVertex AIを選ぶ理由は、IAM、VPGoogle I/O 2025では、Gemini 2.5が間接プロンプトインジェクション攻撃に対する保護率を大幅に向上させ、「これまでで最も安全性の高いモデルファミリー」となったことが発表されました。

ReAlice株式会社 AIコンサルタント

ReAlice株式会社 AIコンサルタント生成AI普及に伴う漏えいリスクや規制対応の必要性が整理されており、その上でVertex AIが企業向けとして選ばれる背景がわかりやすく示されています。国内リージョンでのデータ管理や国際認証への準拠といった点は、法規制の厳しい業界にとって特に重要です。

Vertex AIの主要なセキュリティ機能

データを守る暗号化とアクセス制御

Vertex AIは、企業データを複数の層で保護する仕組みを提供しています。データは転送時も保存時も自動的に暗号化され、第三者による不正アクセスを防ぎます。Google Cloudが管理する暗号化キーに加えて、企業が独自に管理できるCMEK(Customer-Managed Encryption Keys)を利用すれば、暗号化の制御権を完全に自社で握ることが可能です。

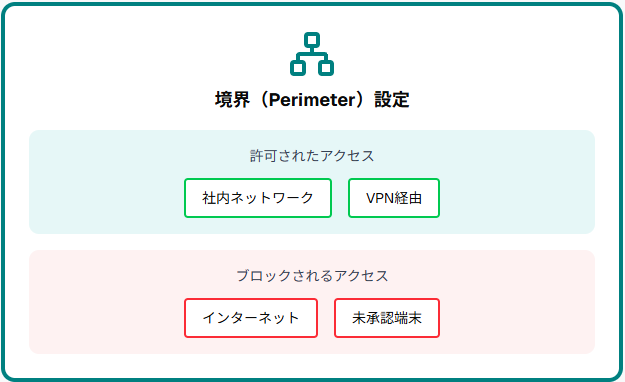

VPC Service Controlsを使えば、APIへのアクセスを特定のネットワークに限定し、インターネット経由での不正アクセスを遮断できます。

CMEKによる自社管理の暗号化キー

CMEK(Customer-Managed Encryption Keys)は、企業が自社で暗号化キーを管理できる機能です。Google Cloud Key Management Service(KMS)を通じて独自の暗号化キーを作成し、Vertex AIで処理されるデータに適用します。

万が一Googleのシステムに問題が生じても、企業側でキーを無効化すればデータへのアクセスを即座に遮断できます。金融機関や医療機関など、高いセキュリティ基準を求められる業界では必須の機能です。

VPC Service Controlsで実現する閉域運用

VPC Service Controls(VPC-SC)は、Vertex AIのAPIを特定のネットワーク境界内に閉じ込める機能です。境界(Perimeter)を設定することで、社内ネットワークやVPN経由でのみAPIにアクセス可能となります。Sensitive Data ProtectionやModel Armorと組み合わせることで、機密データの流出を多段階で防御できます。

Tenableが2025年4月7日に発表した「クラウド AI リスクレポート 2025」では、Google CloudのVertex AIノートブックを設定した組織の77%が1つ以上のインスタンスに過剰な権限が付与されたデフォルトのCompute Engineサービスアカウントを設定していることが判明しました。VPC-SCとIAMを適切に設定すれば、こうしたリスクを軽減できます。

IAMによる細かな権限設定

IAM(Identity and Access Management)は、ユーザーやサービスアカウントに対して「最小権限の原則」を適用する仕組みです。データサイエンティストにはモデルのトレーニング権限を与え、マネージャーには閲覧権限のみを付与するといった細かな制御が可能です。

Google アカウント単位だけでなく、Google グループやサービスアカウント単位での管理もできます。Cloud Audit Logsと連携すれば、誰がいつどんな操作をしたか完全に記録されるため、内部監査やコンプライアンス対応も容易になります。

日本国内でのデータ保管を保証するデータレジデンシ

データレジデンシは、企業が指定した地理的な場所(リージョン)にデータを保管し続けることを保証する機能です。Google Cloudは日本の東京リージョン(asia-northeast1)でデータレジデンシ保証を提供しており、企業はデータの保管場所を制御できます。

顧客データやプロンプト、AIの生成結果が日本国内のみで処理・保存されることが明示されています。個人情報保護法やマイナンバー法など日本固有の法令に準拠しながらAIを活用できます。金融機関や官公庁など、データの物理的な保管場所が重要視される業界では、この機能が導入の決め手となります。

ユーザーデータを学習に使わない保証

Vertex AIでは、ユーザーが入力したプロンプトやアップロードしたデータが、事前の許可なくGoogleの基盤モデルの学習に使われることはありません。この「Training Restriction(トレーニング制限)」により、企業は機密情報を含むデータをAIに入力できます。

無料のGemini API(AI Studio)では、品質向上のため人間によるレビューが行われる可能性があるため、企業利用には不向きです。Google Cloudの公式ドキュメントでは、Vertex AIのデータ保持ポリシーが明記されており、処理後一定期間でデータが削除されることも保証されています。

暗号化やアクセス制御、データレジデンシといった基盤面から、Model ArmorによるAI特有リスクへの防御まで、Vertex AIのセキュリティ機能が多層的に整理されています。CMEKやVPC-SCなど高度な統制機能は規制産業にも適した内容であり、ユーザーデータを学習に使わない保証も企業利用に安心感を与えます。

AI特有の脅威から守るModel Armor

プロンプトインジェクション攻撃への対策

プロンプトインジェクションは、悪意のある指示を巧妙にプロンプトに紛れ込ませ、AIに意図しない動作をさせる攻撃手法です。OWASP Top 10 for LLMでも最重要リスクに挙げられています。Model Armorは、こうした攻撃を検知・ブロックする専用のセキュリティ機能で、2025年6月には日本語を含む多言語対応が実現しました。

Google I/O 2025では、Gemini 2.5モデルにおいてプロンプトインジェクション攻撃への保護率が向上したと発表されました。Model Armorは入力されたプロンプトをリアルタイムで解析し、疑わしいパターンを検出すると処理を停止します。

個人情報と機密データの自動検知

Model Armorは、プロンプトやAIの生成結果に含まれる個人情報(PII: Personally Identifiable Information)や機密データを自動的に検知し、フィルタリングします。クレジットカード番号、マイナンバー、メールアドレス、住所などの情報がAIの出力に含まれそうになると、自動的にマスキングまたはブロックされます。

Model ArmorはSensitive Data Protection(旧Data Loss Prevention、DLP)と統合されており、機密データの検出とマスキングが可能です。2025年4月のアップデートにより、単一のModel Armorサービスを通じてDLP機能が利用できるようになりました。顧客対応や人事業務など、個人情報を扱うシーンでは、この機能により法令違反のリスクを低減できます。

有害コンテンツの生成防止

Model Armorには、AIが差別的表現、暴力的内容、性的コンテンツなど社会的に不適切な内容を生成するのを防ぐ「Responsible AI機能」が搭載されています。OWASP Top 10 for LLM 2025で指摘されている「有害なコンテンツ生成」リスクに対し、Vertex AIは複数の安全フィルタを組み合わせて対策しています。

2025年6月の多言語対応アップデートにより、日本語特有の表現や文脈にも対応できるようになりました。顧客向けマーケティングやカスタマーサポートでAIを使う際、不適切な発言が企業イメージを損なうリスクがありますが、この機能により「炎上」を防げます。

Model ArmorとVertex AIの統合による簡単導入

Model Armorは、Vertex AIに統合されており、わずか数ステップで有効化できます。Google Cloud Consoleから「Security Template」を作成し、Vertex AIのエンドポイントに適用するだけで、プロンプトインジェクション対策やPII保護が自動的に機能します。

従来は専門のセキュリティエンジニアが必要だった高度な防御を、開発者が直感的に設定できるようになりました。

ChatGPT利用に伴う情報漏洩の懸念は、入力データの扱い方や設定次第で大きく変わります。

企業環境では、学習利用設定やアカウント管理、履歴制御を含む基本的な対策が不可欠です。

また、攻撃手法や生成特性に起因するリスクを理解したうえで、技術面と運用面の両軸から防御を設計する姿勢が求められます。

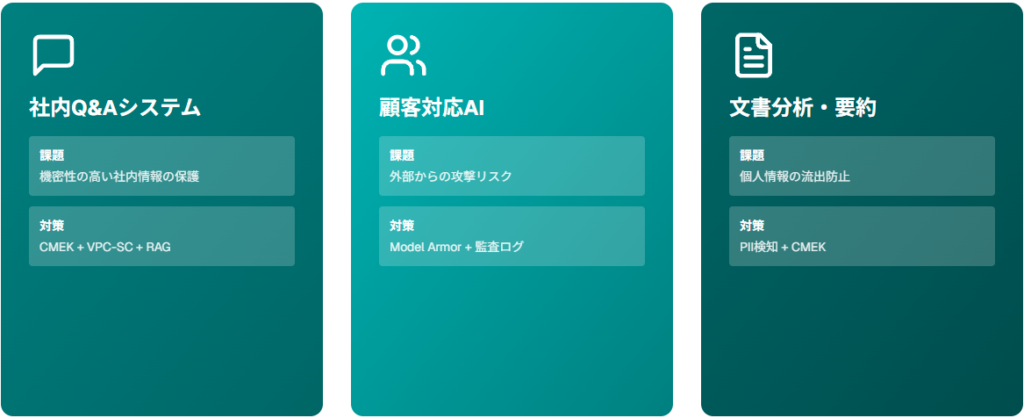

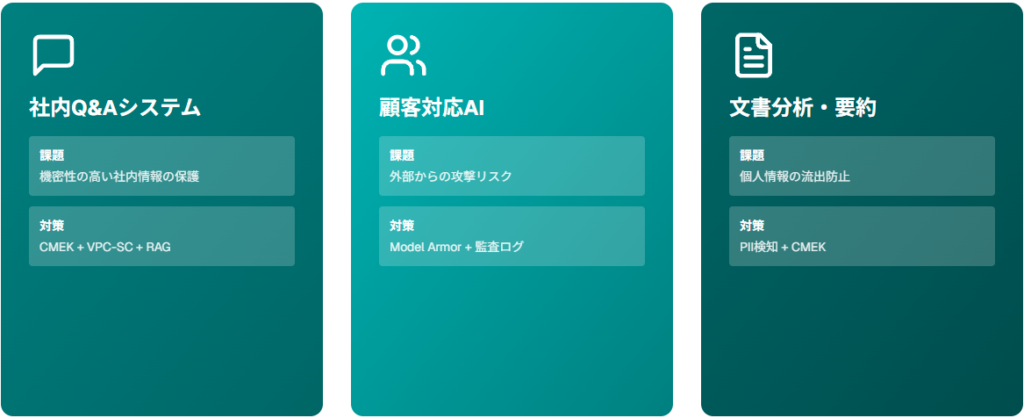

ビジネスシーン別のセキュリティ実装例

社内Q&Aシステムでの機密保護

社内Q&AシステムをVertex AIで構築する場合、RAG(検索拡張生成)エンジンと組み合わせることで、社内文書や業務マニュアルを基にした正確な回答が可能になります。機密性の高い社内情報を扱うため、CMEKとVPC Service Controlsの併用が必須となります。

Vertex AIエージェント・ビルダーを使えば、BigQueryやCloud Storageに保存された社内データと連携し、ノーコードでエージェントを構築できます。実際の導入では、サービスアカウントによる認証とIAMロールの適切な設定により、APIキーを使わずセキュアにVertex AIを呼び出せます。

顧客対応AIにおける情報漏えい対策

顧客対応AIチャットボットでは、外部からの入力を受け付けるためプロンプトインジェクション攻撃のリスクが高まります。Model Armorの導入により、悪意ある指示が混入しても自動的にブロックされ、顧客情報の流出を防げます。インドの保険会社HDFC ERGOは、Google CloudのVertex AIとNiveus Solutions、Lumiqを活用し、パーソナライズされたAI駆動の保険サービスを実現し、デジタルトランスフォーメーションを推進しています

Cloud Audit Logsによる監査機能を有効にすれば、顧客とのやり取りが全て記録され、万が一の情報漏えい時にも原因追跡が可能です。

文書分析・要約での個人情報保護

契約書や医療記録など機密性の高い文書をAIで分析・要約する場合、個人情報や機密データの流出リスクが高くなります。Model ArmorのPII検知機能を有効にすれば、氏名、住所、クレジットカード番号などが要約結果に含まれそうになると自動的にマスキングされます。

グローバルエネルギー企業のAESは、Vertex AI上のClaudeを活用した生成AIエージェントにより、エネルギー安全監査(衛生・安全監査)プロセスを合理化し、従来10時間かかっていた監査作業を3分で完了できるようになりました。監査のような厳格な文書管理が求められる業務では、CMEKによる暗号化とTraining Restriction(データを学習に使わない保証)の両方を適用することで、法的要件を満たせます。

ビジネス用途で生成AIを扱う際は、システム構成そのものにセキュリティ対策を組み込むことが重要です。

Vertex AIは、CMEKやVPC Service Controls、Model Armorなどを組み合わせることで、機密性の高い業務にも対応できる堅牢な基盤を提供します。データの扱い方、権限管理、監査ログの活用といった基本要件を満たす設計により、リスクを抑えつつ高度な自動化を実現できます。

他の生成AIサービスとの比較

Google Cloudならではのセキュリティ優位性

Vertex AIは、Google Cloudの既存セキュリティインフラと完全に統合されている点が最大の強みです。IAM、VPC Service Controls、Cloud Armor、Cloud Audit Logsなどの企業向けセキュリティ機能を追加設定なしで利用でき、コスト効率に優れています。

データレジデンシ保証により、日本企業が法規制に準拠しながらAIを活用できる環境が整備されています。Google I/O 2025で発表されたGemini 2.5モデルは、プロンプトインジェクション攻撃への保護率が向上し、「最も安全なモデルファミリー」と評されています。

Azure OpenAIとの機能比較

Azure OpenAIもデータレジデンシや暗号化機能を提供していますが、Vertex AIはModel Armorを標準統合し、簡単に導入できます。OpenAIは2025年5月7日に日本でのデータレジデンシを開始したことを発表しましたが、後発であるため運用実績ではGoogle Cloudに分があります。

CMEKやVPC-SC相当の機能はAzureにも存在しますが、Vertex AIはGoogle Cloudの他サービス(BigQuery、Cloud Storage、Cloud Runなど)との連携が緊密です。コスト面では、Vertex AIはモデル使用量に応じた従量課金制を採用しており、利用規模に合わせた柔軟なコスト管理が可能です。

企業導入における選定ポイント

- Google Cloudを既に利用中で既存システムとの統合を重視する場合

- 日本国内でのデータ保管が法的に求められる金融・医療・官公庁などの業界

- プロンプトインジェクションや有害コンテンツ生成などAI特有のリスクへの対策を重視する場合

逆に、Microsoft製品(Azure、Office 365)との親和性を優先するならAzure OpenAIが適しています。PoCフェーズで両方を試用し、自社のセキュリティポリシーや既存インフラとの相性を検証することを推奨します。

Azure OpenAIも類似機能を提供していますが、実運用の成熟度や他サービスとの統合度では差が生じます。

利用環境や法的要件、既存インフラとの親和性を見極めることで最適な選択が可能になります。

双方をPoCで比較し、自社の運用モデルに最も適した基盤を選ぶことが安全で効率的な導入につながります。

Vertex AI導入前の準備とチェックリスト

セキュリティ要件の明確化

Vertex AI導入の第一歩は、自社のセキュリティ要件を明確にすることです。生成AIの主要な3つのリスク—プロンプトインジェクション対策、機密情報漏えい防止、有害コンテンツ生成防止—を基に、自社のリスクレベルを評価します。

金融機関ならCMEKとデータレジデンシが必須、製造業なら技術情報の学習利用禁止(Training Restriction)が重要といった具合に、業界ごとに優先順位が異なります。法務部門やセキュリティ担当者を巻き込み、個人情報保護法、マイナンバー法、業界固有の規制(金融商品取引法など)への対応要件をリスト化してください。

適切なリージョンとデータ保存場所の選択

データレジデンシ要件がある場合、必ず日本の東京リージョン(asia-northeast1)を選択してください。Google Cloudのコンソールでプロジェクト作成時にリージョンを指定できますが、一度設定すると変更が困難なため慎重に決める必要があります。

すべてのVertex AI機能がデータレジデンシに対応しているわけではないため、導入前にGoogle Cloudの公式ドキュメントで各機能の対応状況を確認することが重要です。BigQueryやCloud Storageなど連携するサービスのリージョンも統一し、データが意図せず海外に転送されないよう設計してください。

IAMロールとアクセス権限の設計

最小権限の原則に基づき、各ユーザーやサービスアカウントに必要最低限の権限のみを付与します。Tenableの調査では、Vertex AI Notebookユーザーの77%が過剰な権限を持っていたことが判明しており、これが情報漏えいの温床となっています。

データサイエンティストには「Vertex AI User」ロール、マネージャーには「Vertex AI Viewer」ロールを割り当てるといった具合に設計します。Google グループ単位で権限を管理すれば、人事異動時の権限変更も効率化できます。

サービスアカウントを使えば、Cloud Run上のアプリケーションがAPIキーなしでVertex AIを呼び出せ、キー漏えいリスクも回避できます。

監査ログとモニタリング体制の構築

Cloud Audit Logsを有効化し、Vertex AIへの全アクセスと操作履歴を記録する体制を整えます。ログは「管理アクティビティログ」「データアクセスログ」「システムイベントログ」の3種類があり、コンプライアンス要件に応じて保存期間を設定します。

BigQueryにログをエクスポートすれば、SQLで柔軟に分析でき、異常なアクセスパターンの検知も可能です。Access Transparency機能を有効にすれば、Googleスタッフによるアクセスも可視化され、透明性が向上します。定期的にログをレビューし、不審なアクティビティがあれば即座にサービスアカウントを停止する運用フローを確立しておくことが重要です。

Vertex AIの導入では、業界固有の法規制やデータ管理要件を踏まえた事前整理が欠かせません。

リージョン選択や権限設計を誤ると、のちの運用で大きな制約やリスクが生じるため、初期段階で統一的な設計方針を固めることが重要です。

最小権限の徹底やサービスアカウント活用により、運用中の情報流出リスクを抑えられます。

セキュリティ機能の設定手順

プロジェクト作成とAPI有効化の基本

新規プロジェクトを作成し、プロジェクト名は組織の命名規則に従います。リージョンは東京(asia-northeast1)を選択してください。

「APIとサービス」メニューから「Vertex AI API」を検索し、有効化ボタンをクリックします。課金アカウントの設定が求められるため、適切な予算アラートを設定しておくと、想定外のコスト発生を防げます。

初期設定では、プロジェクト所有者に全権限が付与されますが、すぐにIAMで権限を見直し、不要な権限を削除することが重要です。

VPC Service Controlsの境界設定

境界内に含めるプロジェクトとサービス(Vertex AI、BigQuery、Cloud Storageなど)を指定し、外部からのアクセスを遮断します。

「イングレス ポリシー」で許可する送信元IPアドレスやVPNを設定し、「エグレス ポリシー」でデータの持ち出し先を制限します。設定後は必ず動作確認を行ってください。

設定ミスによりAPI呼び出しがブロックされる可能性があるため、まず「Dry Run」モードでテストし、問題がなければ本番適用することを推奨します。

Model Armorテンプレートの作成と適用

Google Cloud Consoleで「Vertex AI」→「Model Armor」に移動し、「セキュリティ テンプレートを作成」をクリックします。テンプレート名を入力し、有効にする機能(プロンプトインジェクション検知、PII保護、有害コンテンツフィルタ)を選択します。

検知レベル(低・中・高)は、業務の性質に応じて調整しますが、初期設定では「中」が推奨されます。

テンプレート作成後、Vertex AIのエンドポイントまたはオンライン予測設定画面で作成したテンプレートを選択し、適用します。Pythonコードからの利用も簡単で、エンドポイント作成時にModel Armorテンプレートを指定して保護されたエンドポイントを作成できます。

Model Armorの活用により、プロンプトインジェクションや個人情報混入といったAI特有のリスクにも対応しやすくなります。

Dry Runで事前検証を行うことは、運用トラブルを避けるうえで有効です。

これらの手順を一貫して実施することで、安全なVertex AI運用の基盤が整います。

よくある質問|Vertex AIのセキュリティに関する疑問

Vertex AIでの入力データはGoogleの学習に使われますか?

いいえ、Vertex AIでは「Training Restriction(トレーニング制限)」により、ユーザーが入力したプロンプトやアップロードしたデータが事前の許可なくGoogleの基盤モデルの学習に使われることはありません。

これは無料のGemini API(AI Studio)とは異なる重要なポイントで、企業利用ではVertex AIが推奨される理由の一つです。Google Cloudの公式ドキュメントでは、データ保持ポリシーが明記されており、処理後一定期間でデータが自動削除されることも保証されています。

日本の個人情報保護法に対応できますか?

はい、Vertex AIのデータレジデンシ機能を使えば、データを日本国内(東京リージョン)に保管し続けることが保証され、個人情報保護法に準拠できます。

CMEKによる暗号化、Cloud Audit Logsによる監査記録、機密データ保護機能を組み合わせることで、法令要件を満たせます。金融機関や医療機関など厳格な規制がある業界でも、適切な設定により安全に利用可能です。

Gemini APIとVertex AIのセキュリティの違いは?

Gemini API(AI Studio)はAPIキーベースの認証で、品質向上のため人間によるレビューが行われる可能性があり、企業の機密情報を扱うには不適切です。

一方、Vertex AIはIAM、VPC Service Controls、Cloud Audit Logsなど企業向けの高度なセキュリティ機能を備え、データが学習に使われない保証(Training Restriction)もあります。企業や官公庁での利用には、必ずVertex AIを選択すべきです。

セキュリティ機能の追加コストはかかりますか?

基本的なセキュリティ機能(IAM、Cloud Audit Logs、データ暗号化)は追加料金なしで利用できます。VPC Service Controlsは追加課金なしで利用できます。Vertex AIのモデル使用料は従量課金で、使用量に応じた柔軟なコスト管理が可能です。

ただし、Cloud DLPなど一部のサービスは別途料金が発生するため、事前に料金計算ツールで見積もることを推奨します。

インシデント発生時の追跡は可能ですか?

はい、Cloud Audit Logsにより全ての操作履歴が記録されるため、インシデント発生時に誰がいつどんな操作をしたか完全に追跡できます。サービスアカウントのインパーソネーション機能を使えば、不正アクセスの経路も特定可能です。

BigQueryにログをエクスポートしてSQLで分析すれば、異常なパターンを素早く発見し、被害拡大を防げます。Access Transparency機能により、Googleスタッフによるアクセスも可視化されるため、透明性の高いインシデント対応が可能です。